Hive中就是把Map,Reduce的Join拿过来,通过SQL来表示。

参考链接:https://cwiki.apache.org/confluence/display/Hive/LanguageManual+Joins

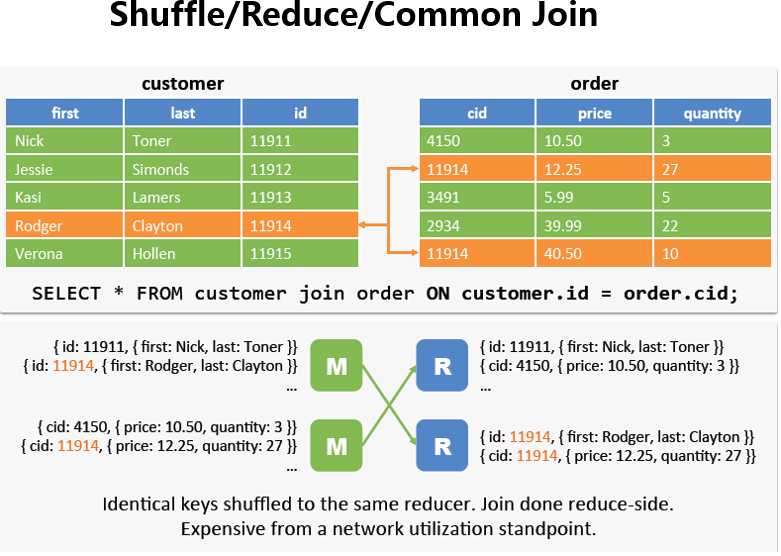

Reduce Join在Hive中也叫Common Join或Shuffle Join

如果两边数据量都很大,它会进行把相同key的value合在一起,正好符合我们在sql中的join,然后再去组合,如图所示。

如果一张表的数据很大,另外一张表很少,那么我们可以将数据量少的那张表放到内存里面,在map端做join。

Hive支持Map Join,用法如下

select /*+ MAPJOIN(time_dim) */ count(1) from

store_sales join time_dim on (ss_sold_time_sk = t_time_sk)

当然也可以让hive自动识别,把join变成合适的Map Join如下所示

注:当设置为true的时候,hive会自动获取两张表的数据,判定哪个是小表,然后放在内存中

set hive.auto.convert.join=true;

select count(*) from store_sales join time_dim on (ss_sold_time_sk = t_time_sk)

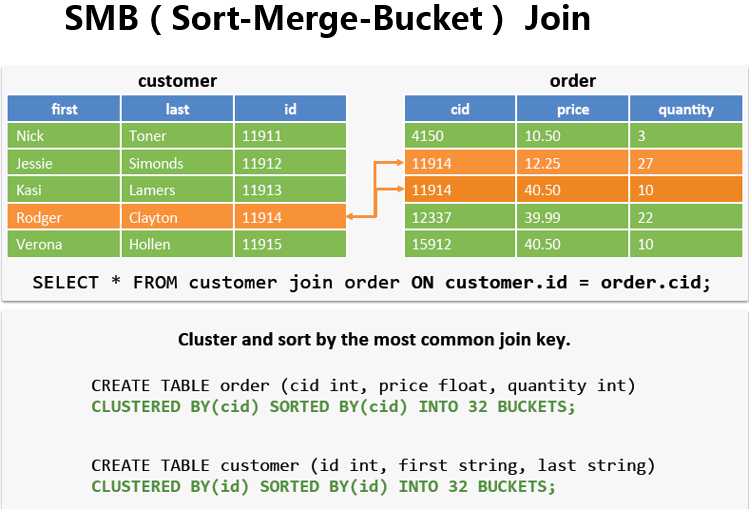

大表对小表应该使用MapJoin,但是如果是大表对大表,如果进行shuffle,那就要人命了啊,第一个慢不用说,第二个容易出异常,既然是两个表进行join,肯定有相同的字段吧

tb_a - 5亿(按排序分成五份,每份1亿放在指定的数值范围内,类似于分区表)

a_id

100001 ~ 110000 - bucket-01-a -1亿

110001 ~ 120000

120001 ~ 130000

130001 ~ 140000

140001 ~ 150000

tb_b - 5亿(同上,同一个桶只能和对应的桶内数据做join)

b_id

100001 ~ 110000 - bucket-01-b -1亿

110001 ~ 120000

120001 ~ 130000

130001 ~ 140000

140001 ~ 150000

注:实际生产环境中,一天的数据可能有50G(举例子可以把数据弄大点,比如说10亿分成1000个bucket)。

在运行SMB Join的时候会重新创建两张表,当然这是在后台默认做的,不需要用户主动去创建,如下所示:

设置(默认是false):

set hive.auto.convert.sortmerge.join=true

set hive.optimize.bucketmapjoin=true;

set hive.optimize.bucketmapjoin.sortedmerge=true;

其实在写程序的时候,我们就可以知道哪些是大表哪些是小表,注意调优。

原文:http://www.cnblogs.com/raymoc/p/5323824.html