我们知道,对于开发而言,IDE是有很多个选择的版本。如我们大部分人经常用的是如下。

而我们知道,对于spark的scala开发啊,有为其专门设计的eclipse,Scala IDE for Eclipse

1、Scala IDE for Eclipse的下载

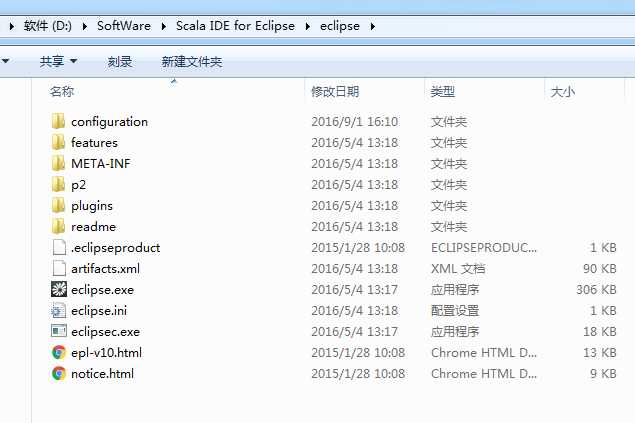

2、Scala IDE for Eclipse的安装

进行解压

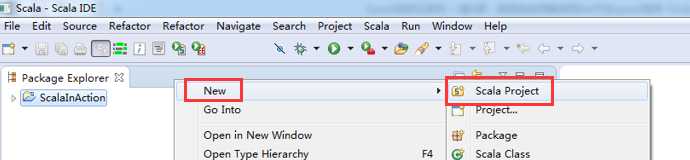

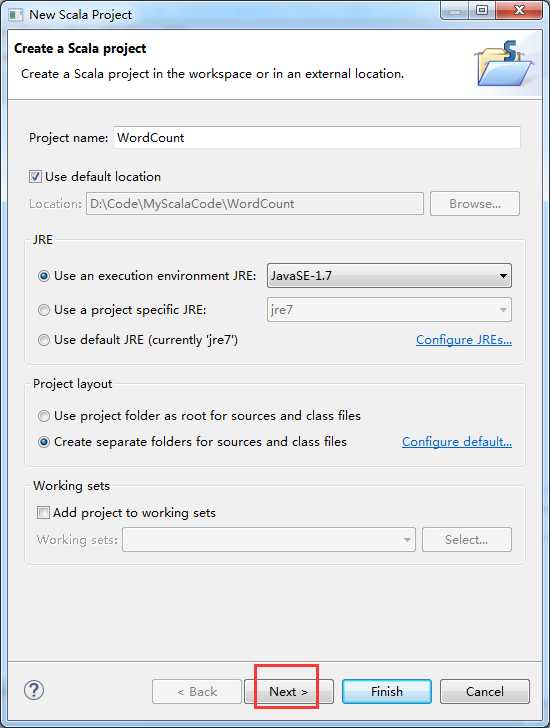

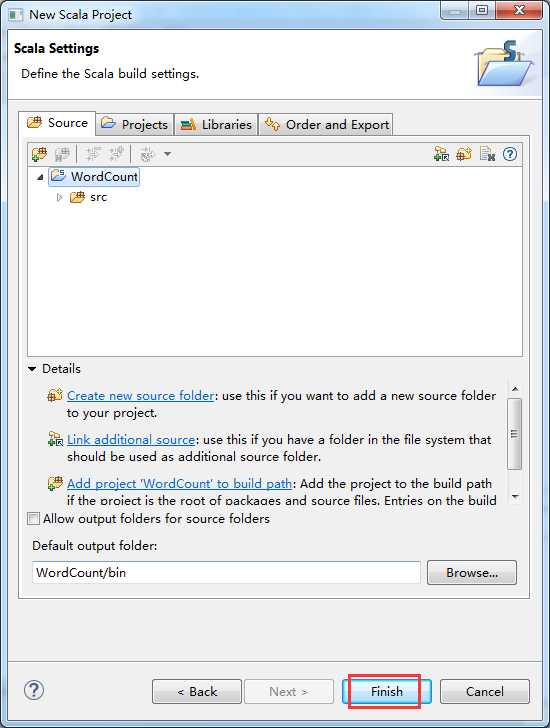

3、Scala IDE for Eclipse的WordCount的初步使用

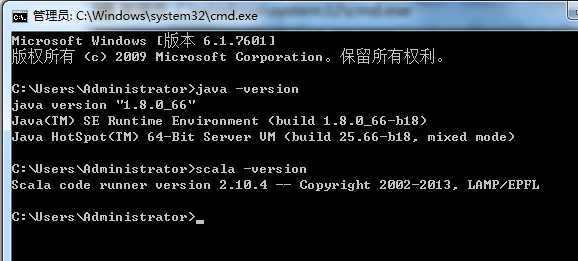

在这之前,先在本地里安装好java和scala

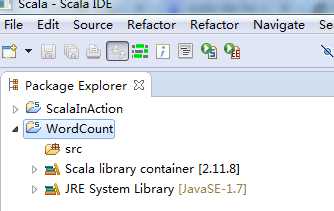

默认竟然变成了scala 2.11.8去了

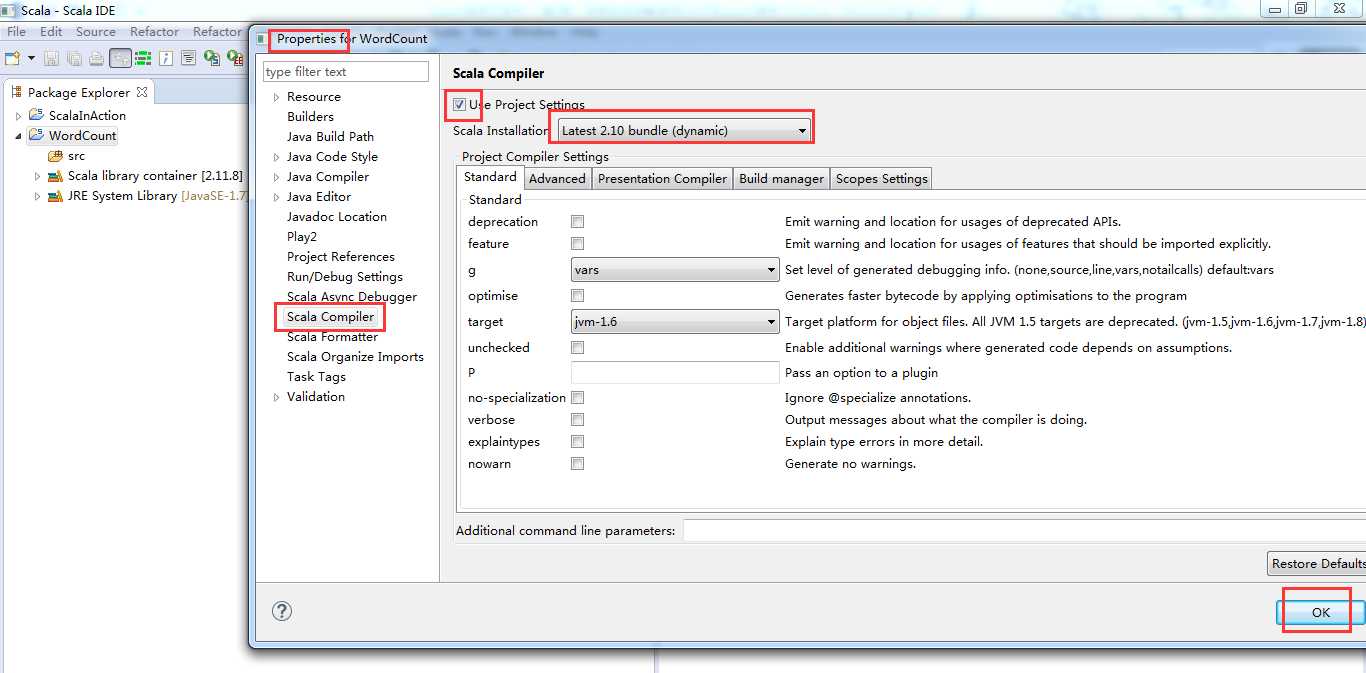

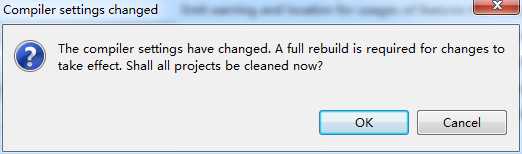

这一定要换!

Scala2.11.8(默认的版本) --------> scala2.10.4(我们的版本)

第一步:修改依赖的scala版本,从scala2.11.*,至scala2.10.*。

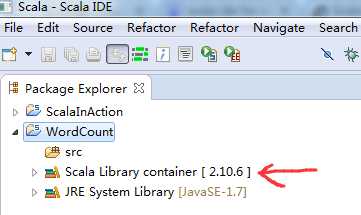

这里是兼容版本,没问题。Scala2.10.6和我们的scala2.10.4没关系!!!

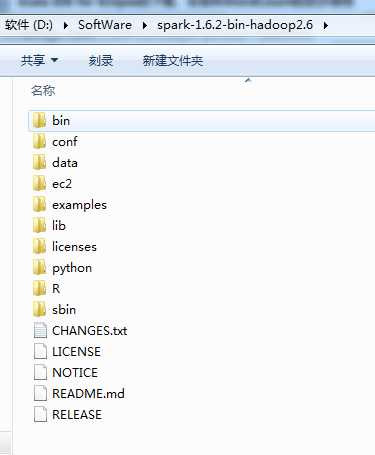

第二步:加入spark1.6.0的jar文件依赖

http://spark.apache.org/downloads.html

http://www.apache.org/dyn/closer.lua/spark/spark-1.6.2/spark-1.6.2-bin-hadoop2.6.tgz

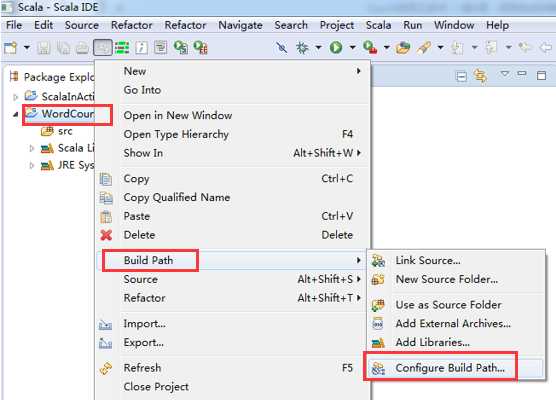

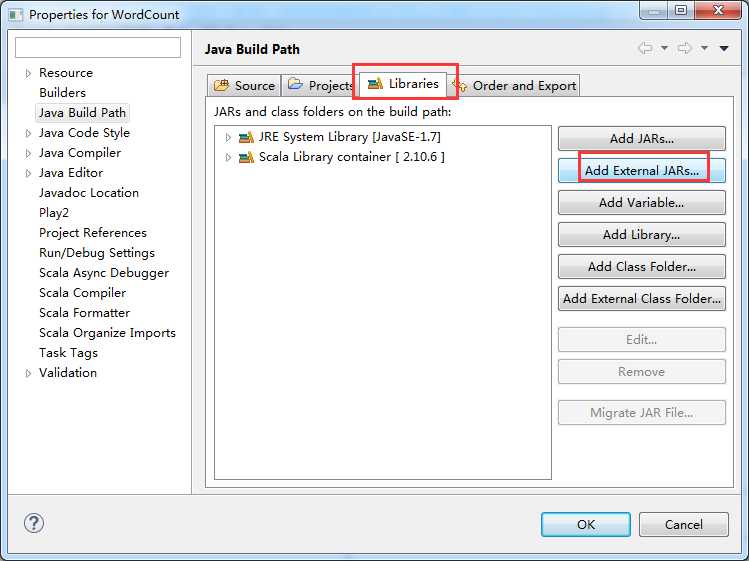

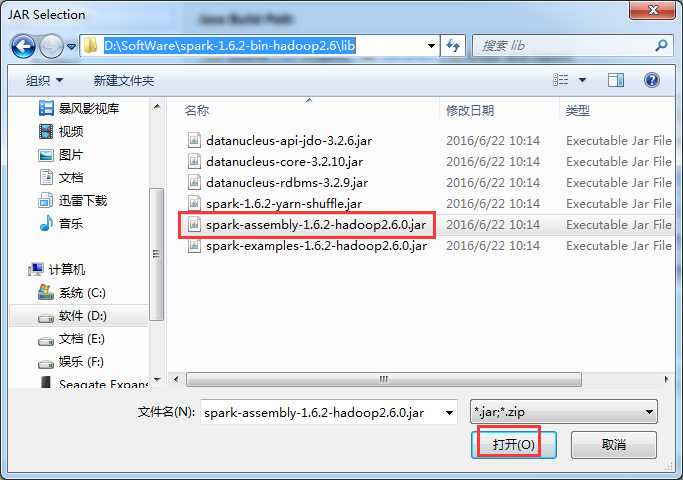

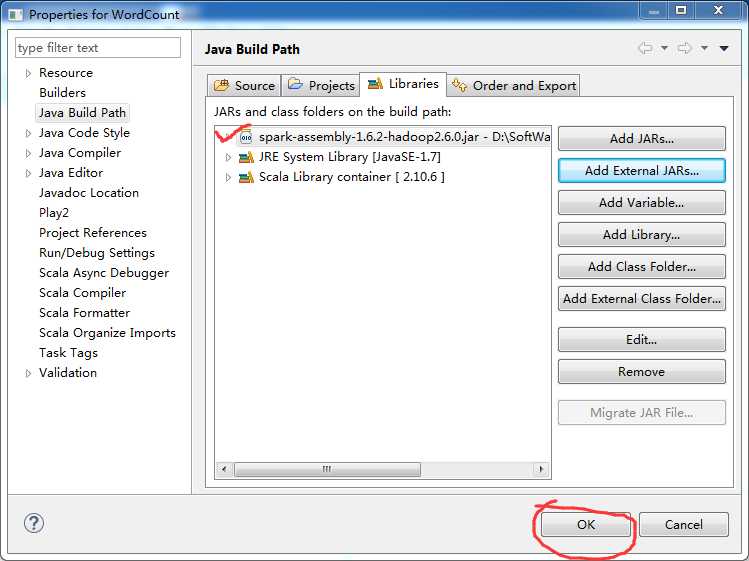

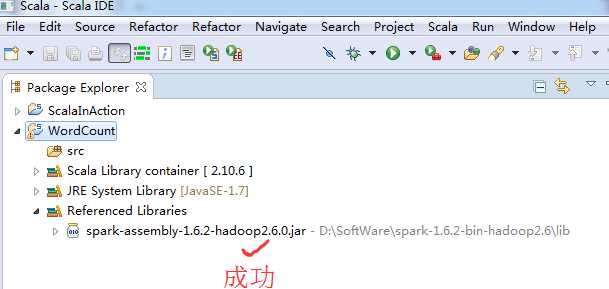

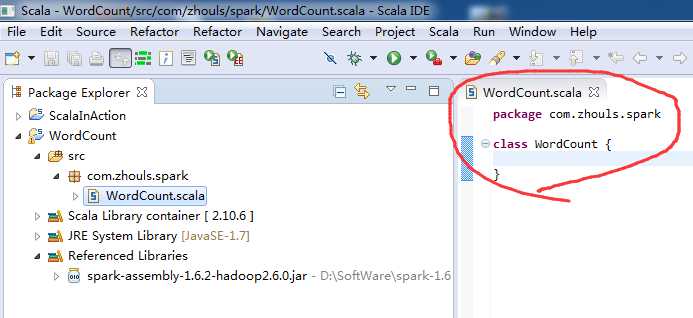

第三步:找到依赖的sparkjar文件,并导入到Scala IDE for Eclipse的jar依赖中

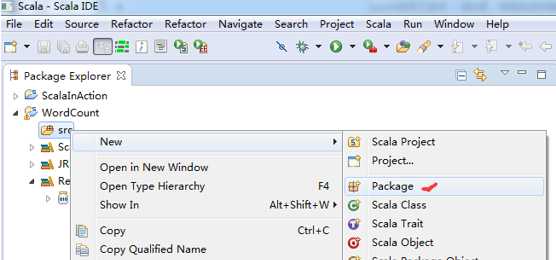

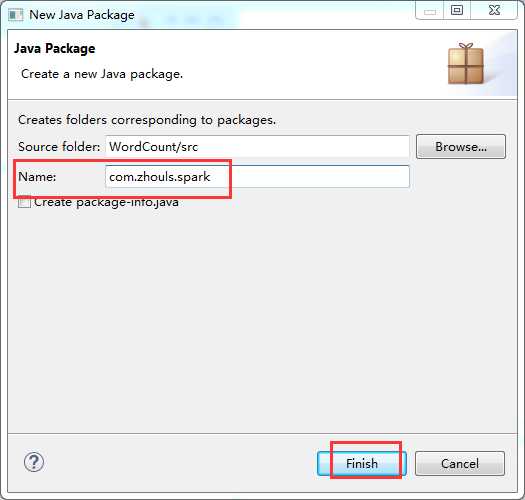

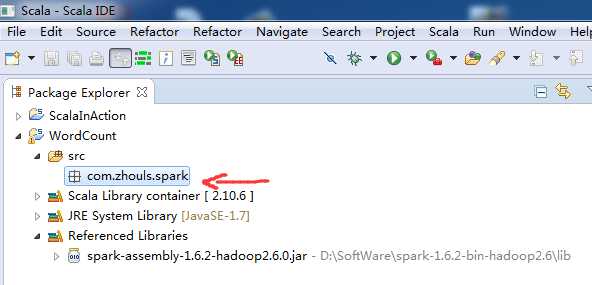

第四步:在src下,建立spark工程包

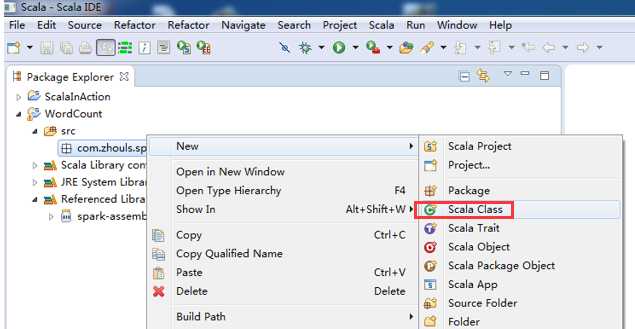

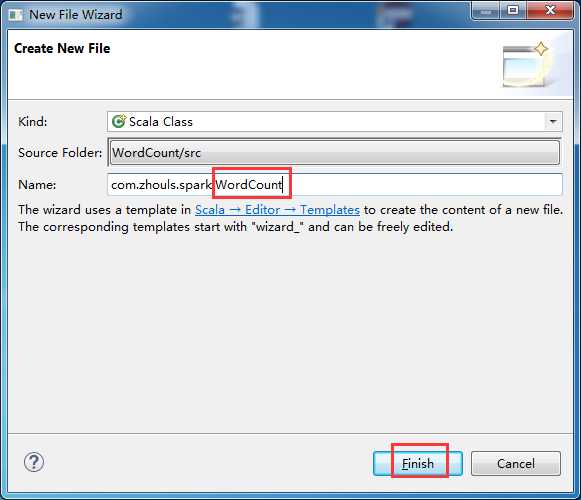

第五步:创建scala入口类

Scala IDE for Eclipse的下载、安装和WordCount的初步使用

原文:http://www.cnblogs.com/zlslch/p/5880006.html