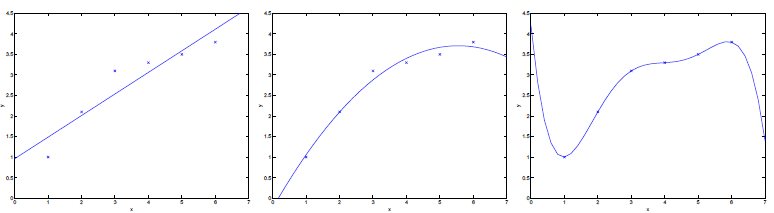

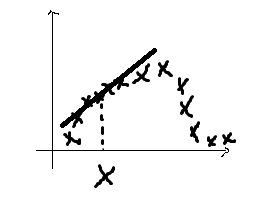

首先看下面的图

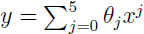

对于图中的一系列样本点,当我们采用 形式,便会产生最右边的拟合曲线。从三张图中我们可以看出来,第一条曲线存在欠拟合问题,第三条的曲线存在过拟合问题。

形式,便会产生最右边的拟合曲线。从三张图中我们可以看出来,第一条曲线存在欠拟合问题,第三条的曲线存在过拟合问题。

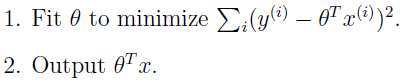

在基本的线性回归问题中,首先我们构造出预测函数h(x),然后变化参数θ使得误差函数最小化,一旦θ确定,以后不会改变,所有的预测值都会使用着一个参数:

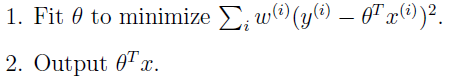

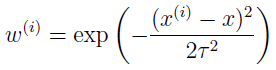

相比之下,局部权重线性回归方法执行如下的算法:

x代表需要预测的值的输入,

w中的τ称为带宽(bandwidth)参数,可以控制x周围的概念,即控制距离x多远可以参与线性函数的估计,τ越大,参与的点越多,反之,参与的点越少。

由于局部权重线性回归方法每个预测每一个点时候都需要重新计算一次

θ的值,因此,算法费时间复杂度会很高,是一种non-parametric算法。前面的基本线性回归是一种parametric学习算法。

个人博客:http://www.houlaizhexq.com houlaizhexq.github.io

局部权重线性回归(Locally weighted linear regression),布布扣,bubuko.com

局部权重线性回归(Locally weighted linear regression)

原文:http://blog.csdn.net/houlaizhexq/article/details/27706477