线性回归模型,即一个函数,这个函数里含有未知的参数,通过学习,可以估计出参数。然后利用这个模型去预测/分类新的数据。

线性回归形式简单,易于建模。许多更为强大的非线性模型可以在该模型基础上引入层级结构或高维映射而得。

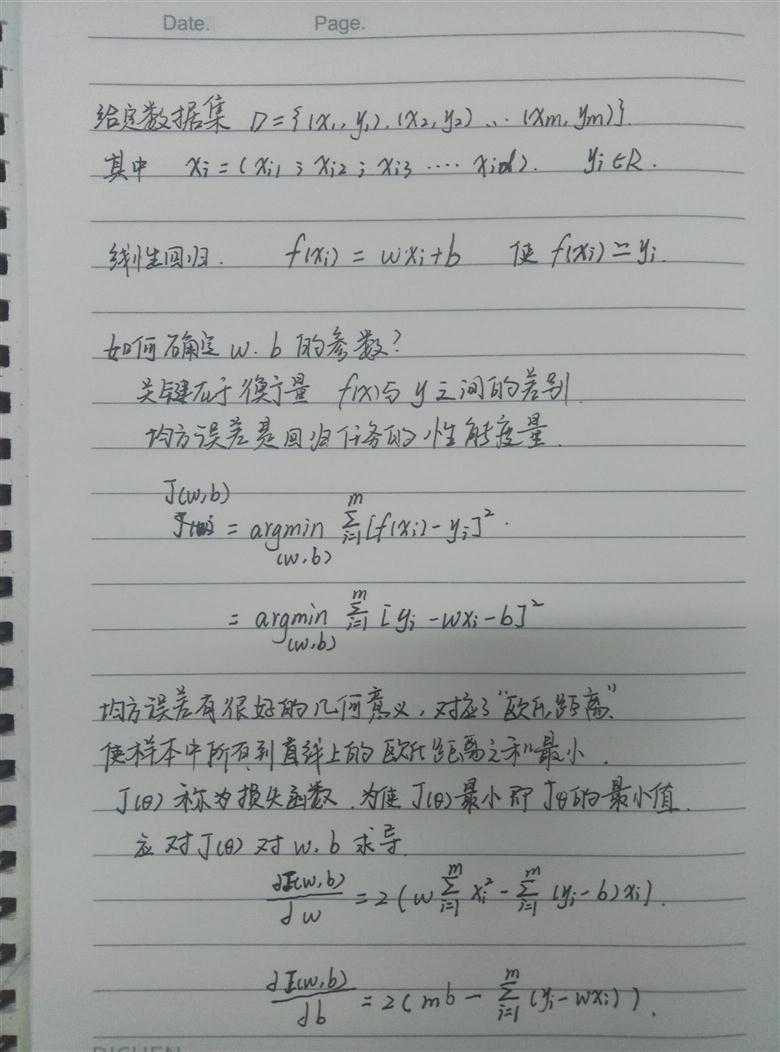

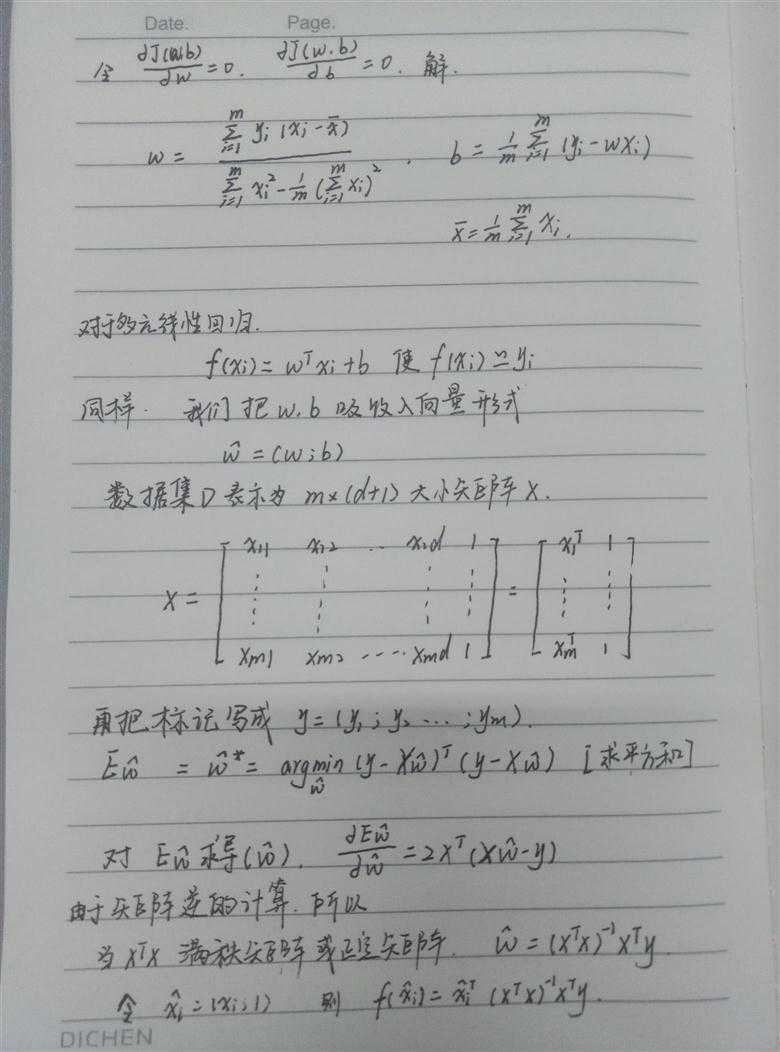

给定由d个属性表述的示例x=(X1,X2,X3...),期中每个Xi表示x在第i个属性上的取值,线性模型试图去学得一个通过属性的线性组合来进行预测的函数

f(x)= w1X1+w2X2+w3X3+...+wdXd+b

向量表示:

f(x) = wTx+b

期中w=(w1,w2,w3...wd),w,b学得之后,模型就得以确定。w直观的表达出各个属性在预测中的重要性(w为权重矩阵)。

下边通过一个简单的例子来实例化上面定义的概念。

假设有一个房屋销售的数据如下:

|

面积(m^2) |

销售价钱(万元) |

|

123 |

250 |

|

150 |

320 |

|

87 |

160 |

|

102 |

220 |

|

… |

… |

这个表类似于北京5环左右的房屋价钱,我们可以做出一个图,x轴是房屋的面积。y轴是房屋的售价,如下:

如果来了一个新的面积,假设在销售价钱的记录中没有的,我们怎么办呢?

我们可以用一条曲线去尽量准的拟合这些数据,然后如果有新的输入过来,我们可以在将曲线上这个点对应的值返回。如果用一条直线去拟合,可能是下面的样子:

绿色的点就是我们想要预测的点。

首先给出一些概念和常用的符号。

房屋销售记录表:训练集(training set)或者训练数据(training data), 是我们流程中的输入数据,一般称为x

房屋销售价钱:输出数据,一般称为y

拟合的函数(或者称为假设或者模型):一般写做 y = f(x)

训练数据的条目数(#training set),:一条训练数据是由一对输入数据和输出数据组成的输入数据的维度n (特征的个数,#features)

这个例子的特征是两维的,结果是一维的。然而回归方法能够解决特征多维,结果是一维多离散值或一维连续值的问题。

上图中对于XTX满秩矩阵时的方法,有时候我们得到XTX往往并不是满秩矩阵,比如我们遇到大量的变量他的属性或特征数目超过样例数目导致X的列多余行数,此时解的个数不唯一选择哪个解作为输出,这样学习算法的归纳偏好决定,常见的做法是引入正则化。也可以用梯度下降法来求解(以后更新该算法)。

假设我们输出标记在指数尺度上变化,就可以将输出标记的对数作为线性模型逼近的目标:

lny = wTx+b

这就是对数线性回归,实际上是在试图让ewTx+b 逼近y。对数线性回归已经是在求取输入空间到输出空间的非线性函数映射。

更一般考虑可微函数g(*),

y = g-1(wTx+b )

这样得到的模型称之为广义线性模型,g(*)为联系函数。

原文:http://www.cnblogs.com/wang-yufan/p/7470828.html