1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

因为python生成的结果为中文,所以首先去网上下载一篇英文小说,我选择的时《了不起的盖茨比》

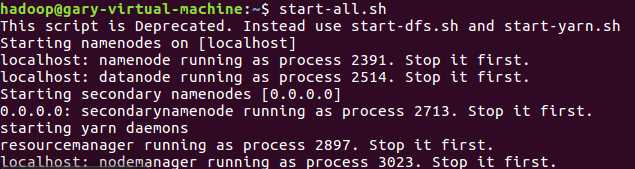

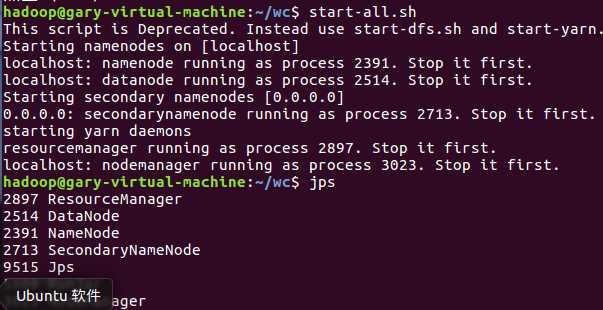

首先启动hadoop

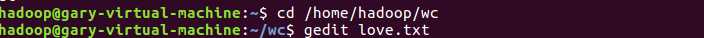

文件上传到hdfs

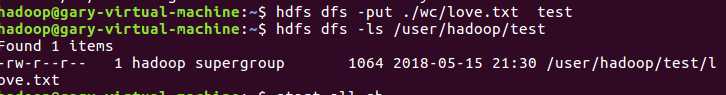

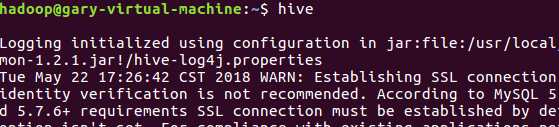

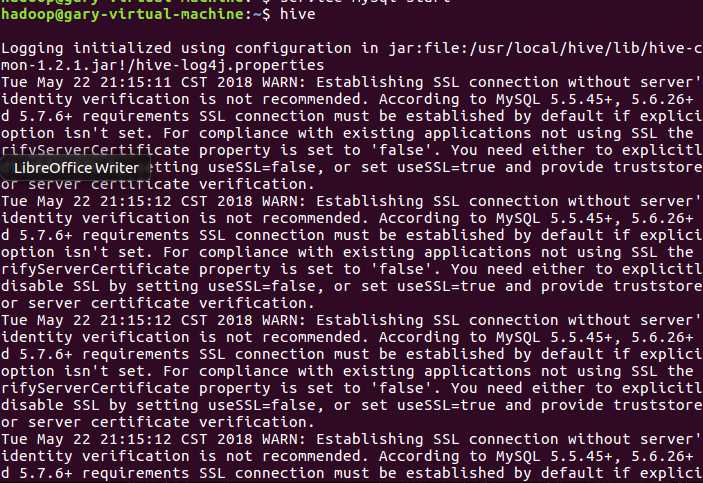

启动hive

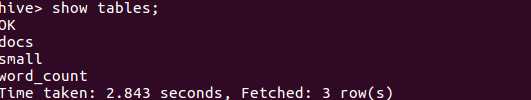

创建原始文件,导入文件到small中并查看,因为之前已经操作,所以直接查看是否有small表

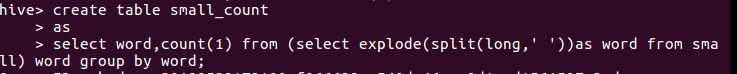

然后进行HQL词频统计,结果放到small_count中

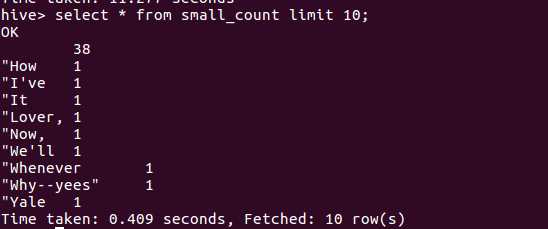

查看small_count表中的前十

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

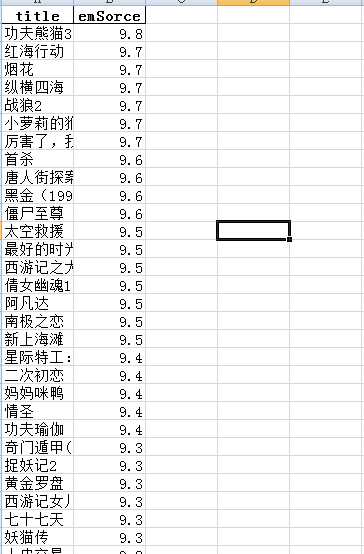

统计的时2345电影网的热门电影数据。如图:

将文件转换为csv格式和txt格式,并将文件放入到虚拟机中

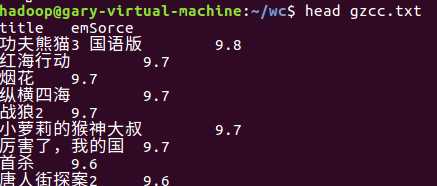

查看前十条:

启动hdfs

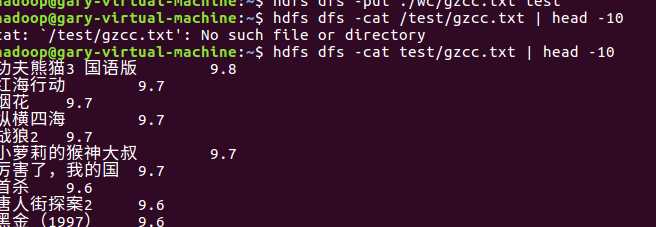

将文件上传至hdfs并显示前十条

启动hive

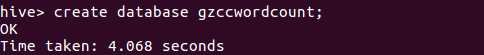

创建数据库

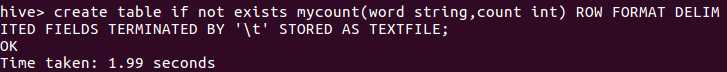

创建表

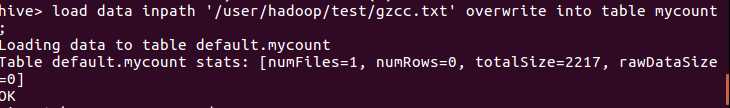

将文件导入表中

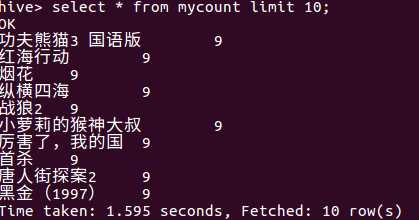

查看前十条

原文:https://www.cnblogs.com/cgz123/p/9074289.html