如垃圾邮件和非垃圾邮件、肿瘤的良性和恶性等,分类一般有二分类以及多分类问题。

0,一般解析为没有某样东西;1,一般解析为拥有某样东西。至于正类和负类,视具体情况而分。

不推荐将线性回归用于分类问题。

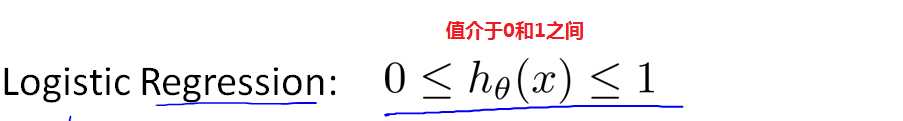

Logistic回归,介于0和1之间,视为一种"分类算法"。

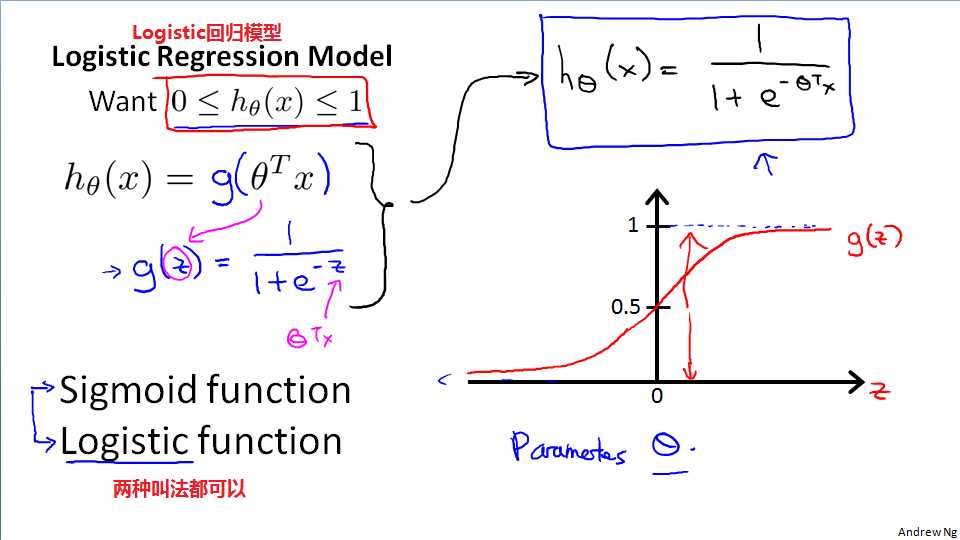

Logistic回归模型

P(y=1|x;o)表示当x=o时,y=1的概率,P(y=1|x;o) + P(y=0|x;o) = 1,即P(y=0|x;o) = 1 - P(y=1|x;o)

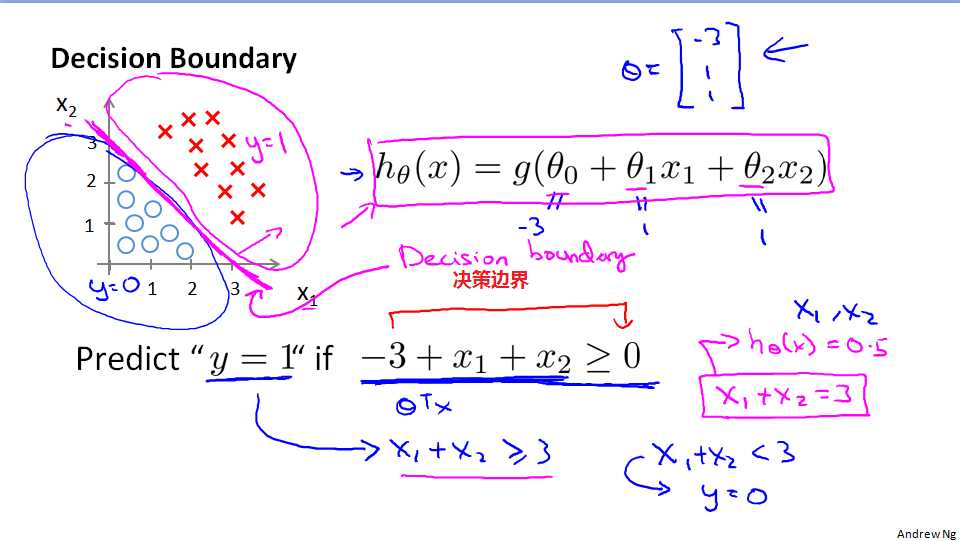

决策边界的概念,决策边界是假设函数的属性,而不是数据集的特征。因为一开始选择Sigmoid函数的时候,函数里面就带了边界特征。

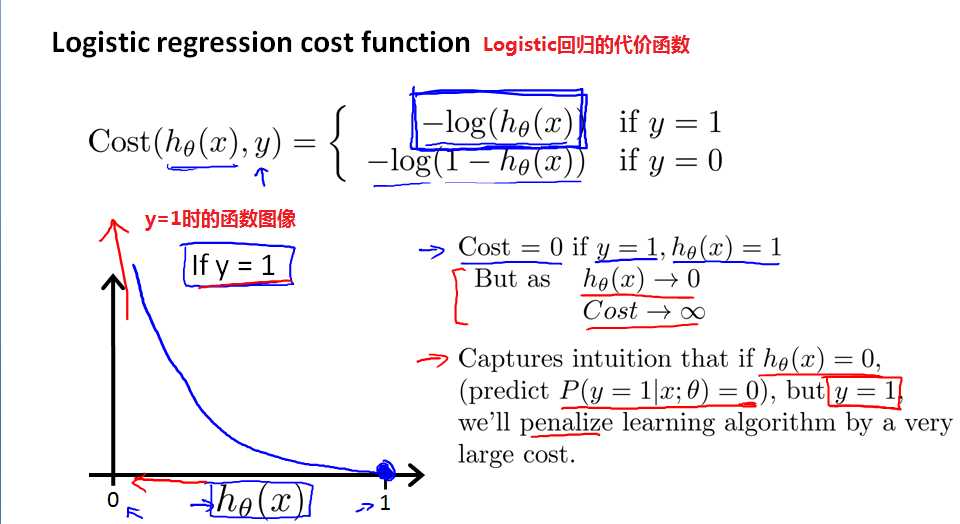

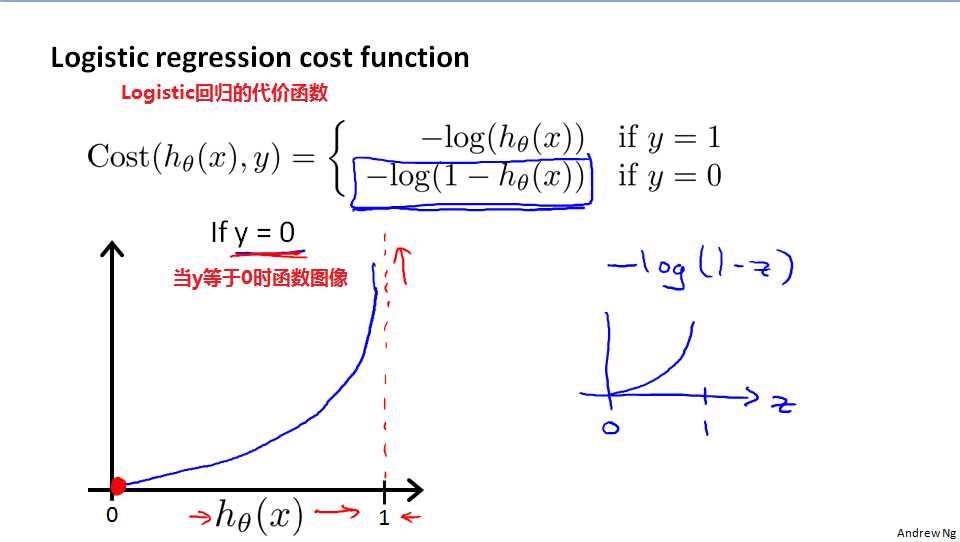

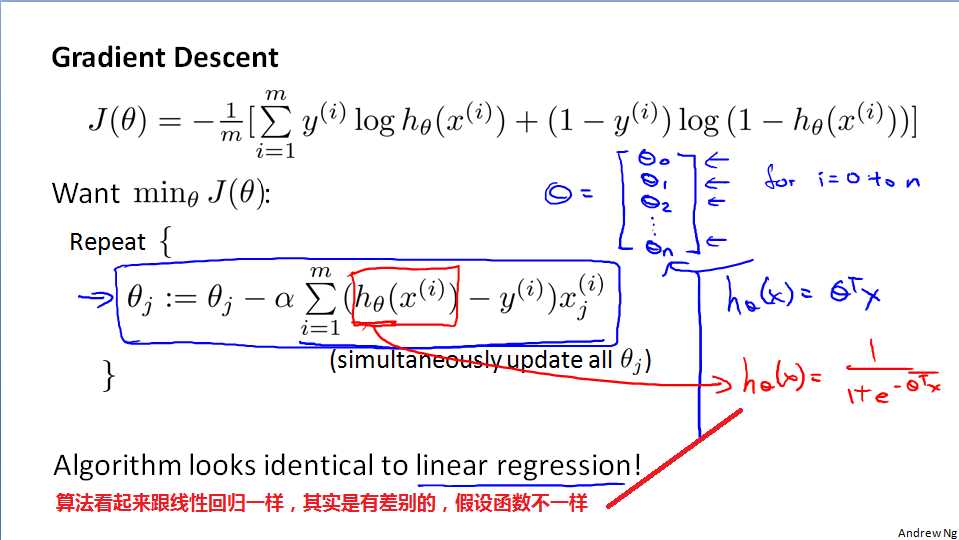

对于logistic回归,之前线性回归的代价函数已经不能再适用了。因为经过代换后的代价函数,是一个非凸函数,难以找到全局最优解。因此,需要更换代价函数。重新定义代价函数,使其为凸函数,以便使用梯度下降法求最优。

Logistic回归的代价函数及y=1时的函数图像

Logistic回归的代价函数及y=0时的函数图像

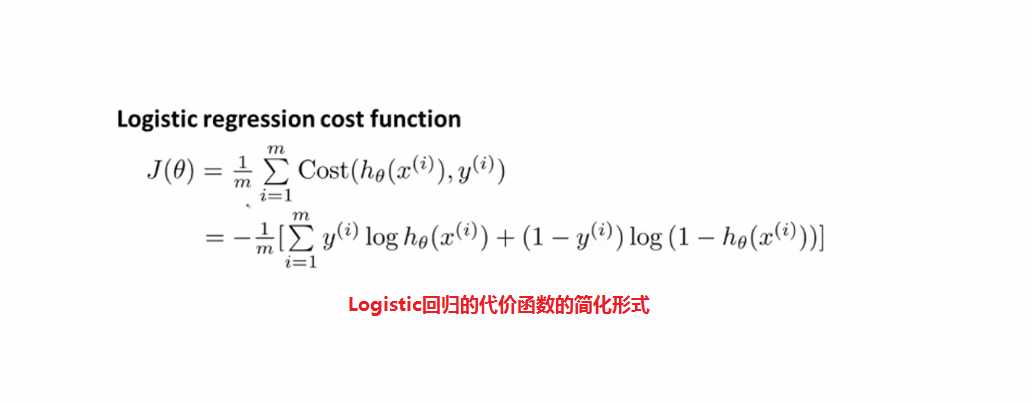

Logistic回归代价函数的简化

跟线性回归一样,可以使用特征缩放,对Logistic回归进行缩放

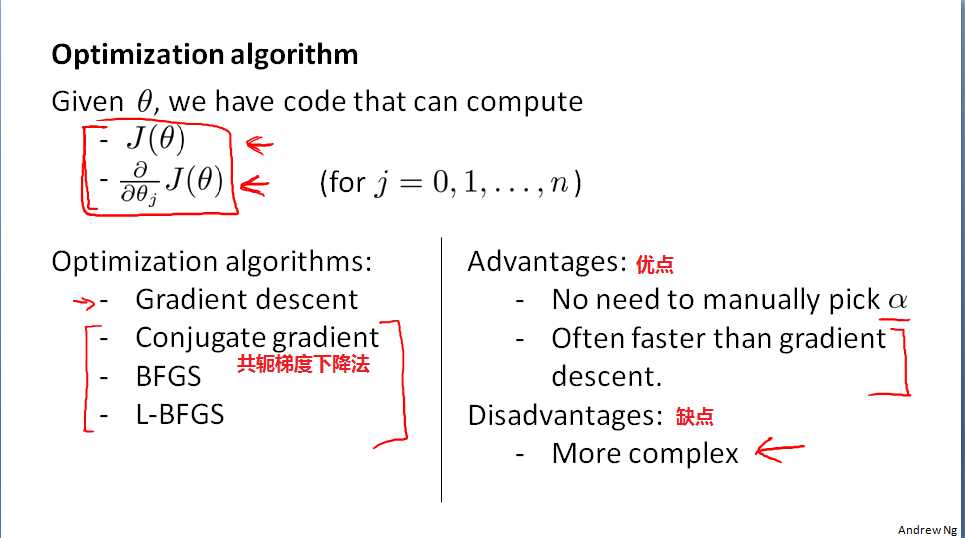

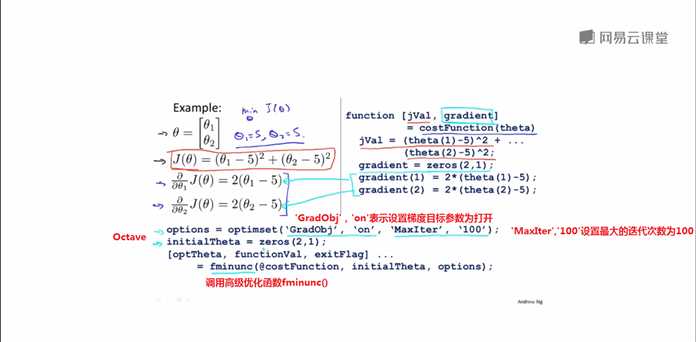

梯度下降算法并不是唯一的寻求最优解的算法,还有高级优化算法,如共轭梯度算法(Gradient descent)、BFGS、L-BFGS,他们的优点是:不需要手动选择学习率,比梯度下降法更加快,缺点是:更加地复杂。

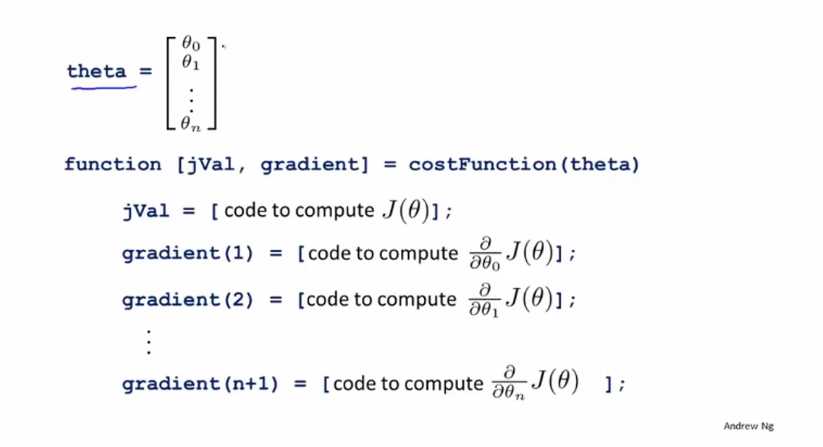

使用Octave调用高级优化算法

步骤解析

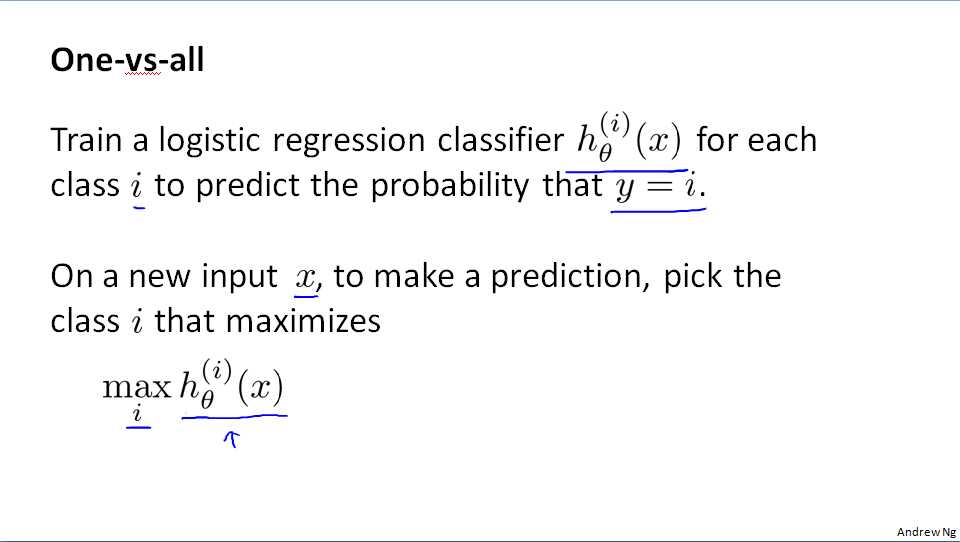

把m个分类中每个类别看做与其他类别不同,做二元分类

初识机器学习——吴恩达《Machine Learning》学习笔记(六)

原文:https://www.cnblogs.com/haifengbolgs/p/9325732.html