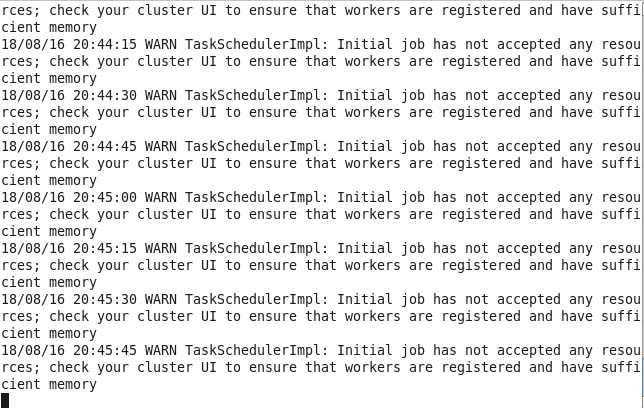

在spark中运行./spark-shell --master YARN-client --num-executors 3 --executor-memory 1g是碰到如下的问题:

biaoshi

表示资源不足,可能是内存不足或者core不足,于是就将1g改为512m,运行成功

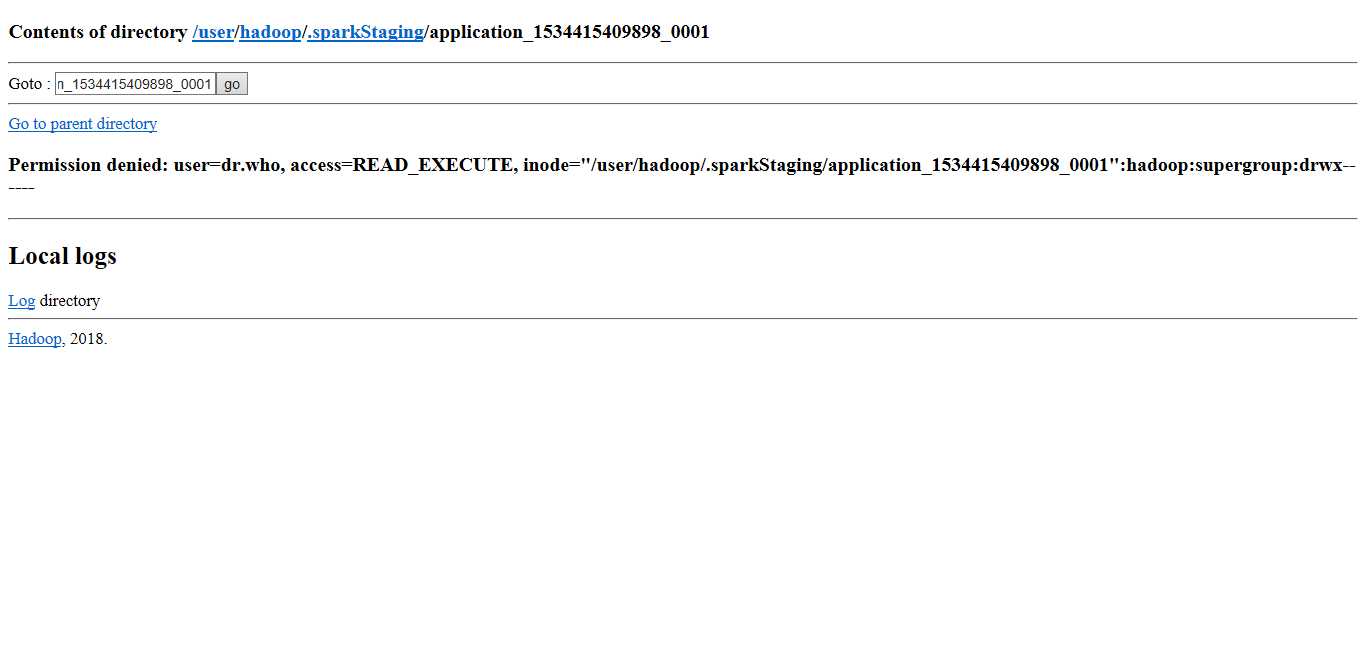

以spark-client运行时候查看hdfs时,以http://hadoop1:50070查看,发现多了一个.sparkStaging文件夹

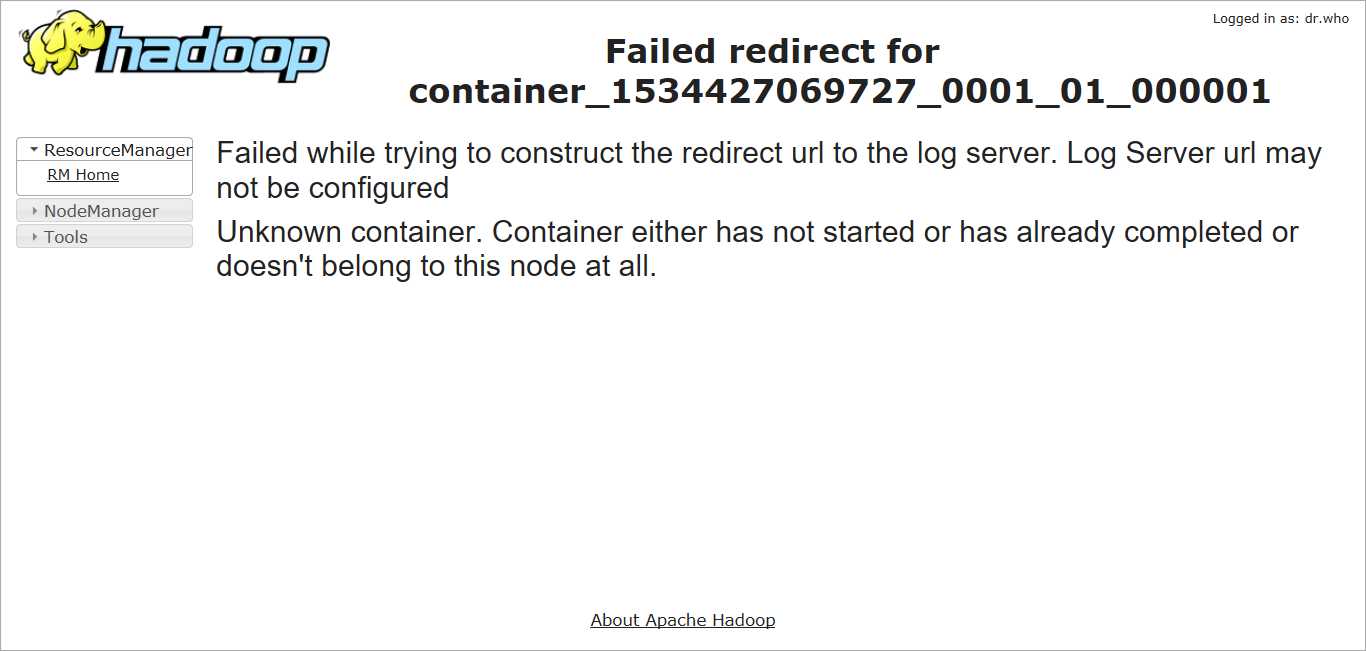

以spark-client运行时碰到如下问题,是因为log server没有开启

解决办法:

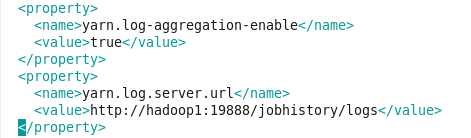

修改mapred-site.xml和 yarn-site.xm

yarn-site.xml添加:

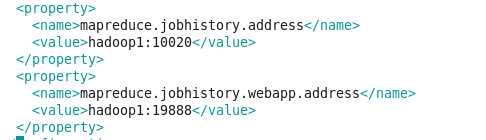

mapred-site.xml添加:

原文:https://www.cnblogs.com/hotMemo/p/9490658.html