win10下Spark的环境搭建

2018-08-19 18:36:45

一、jdk 1.8.0 安装与配置

二、scala 2.11.8 安装与配置

上面两步见《win10下安装scala》

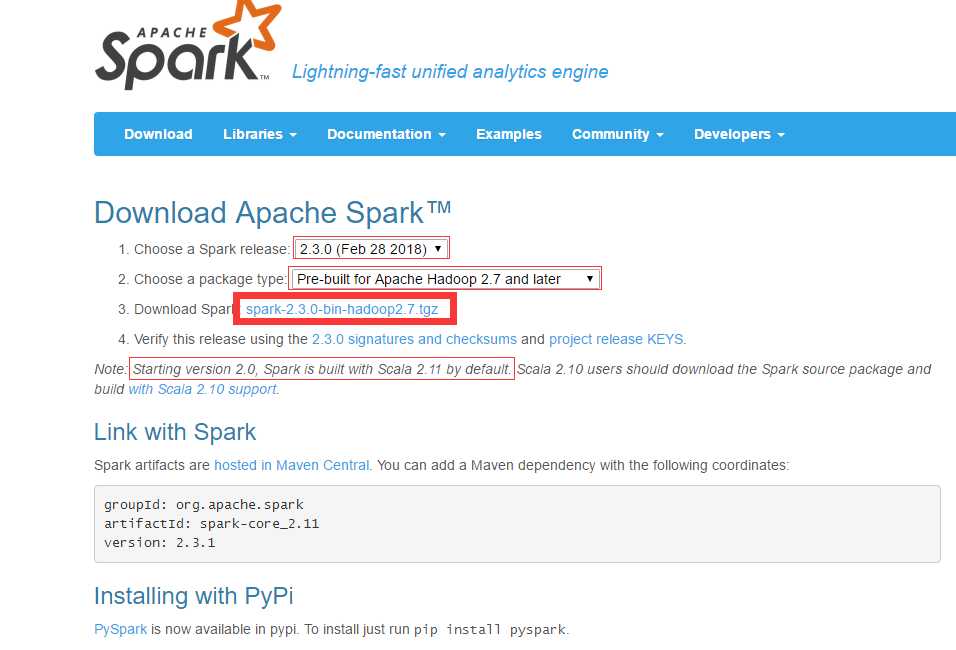

三、spark 2.3.0 安装与配置

1、下载spark:官网地址:http://spark.apache.org/downloads.html

2、下载完成后解压到D盘根目录下即可。D:\spark-2.3.0-bin-hadoop2.7。

3、配置Path:将D:\spark-2.3.0-bin-hadoop2.7\bin添加到Path中。

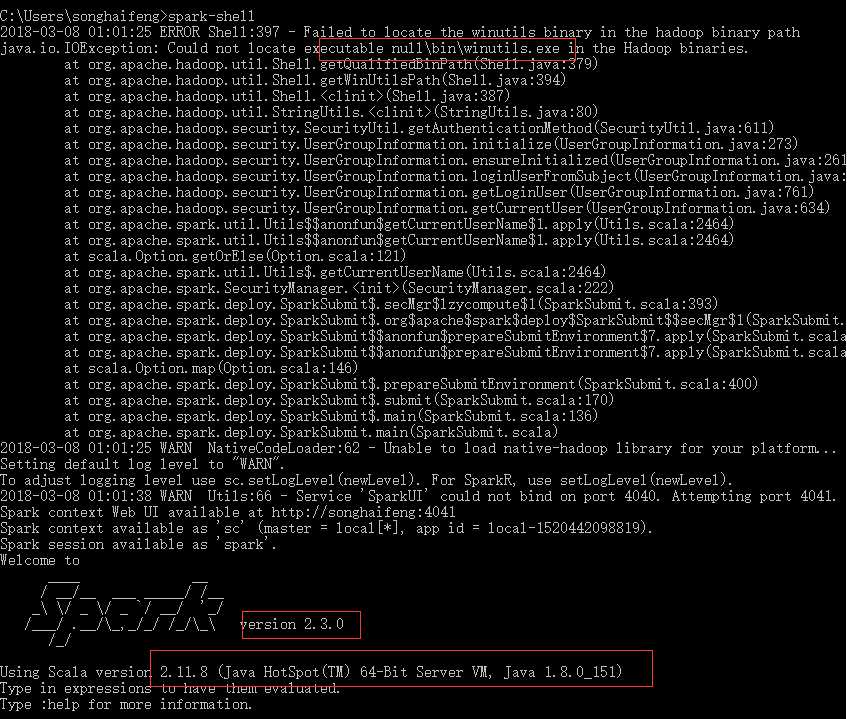

4、通过spark-shell进入到spark交互式命令行模式下

上面可以看见安装的scala版本、jdk版本、spark版本。

注意:上面出现了异常信息,是由于hadoop导致的。所以还要下载安装hadoop进行相关配置。

四、hadoop 2.8.3 安装与配置

1、下载hadoop:官方地址:http://hadoop.apache.org/releases.html

2、解压到D盘根目录下。

3、配置环境变量:HADOOP_HOME 和 Path。

4、winutils下载:https://github.com/steveloughran/winutils

下载对应版本的bin目录将hadoop文件夹中的bin目录替换掉。

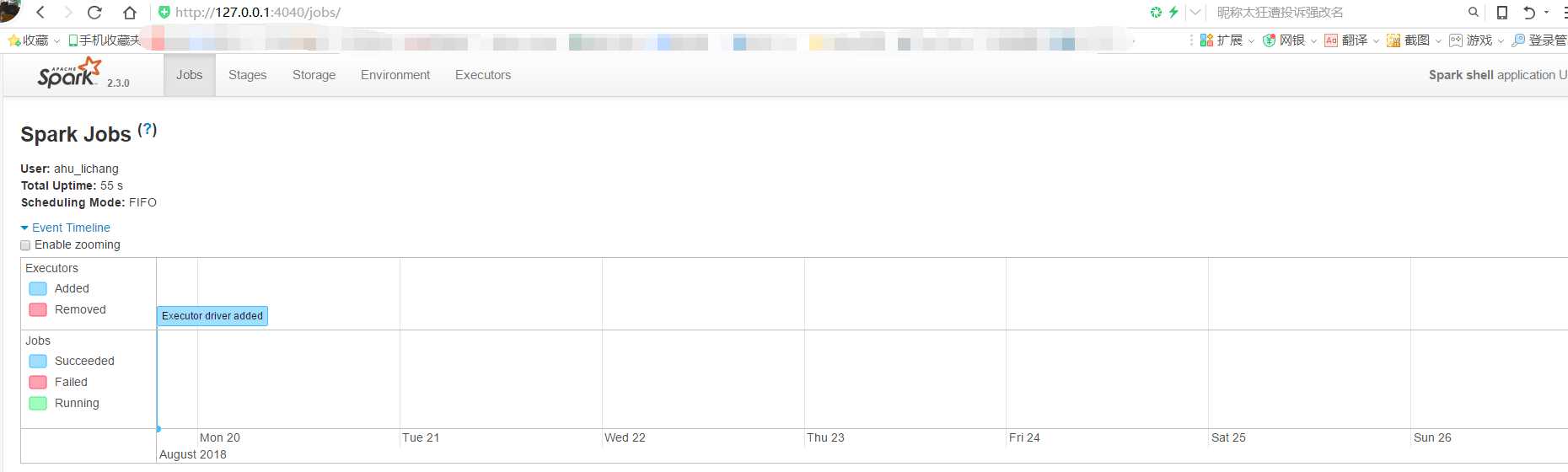

5、再次spark-shell,就不会出现异常信息了。

6、访问webUI:

这样win10环境下本地的spark环境就搭建完成了!!!

下面就可以编程学习了。。。。。

https://blog.csdn.net/u011513853/article/details/52896230 ( IDEA和maven)

原文:https://www.cnblogs.com/ahu-lichang/p/9502233.html