首先

使用scala 写的

创建模式类 确定scheme

object test {

case class p(

a:String, //字段名和数据类型

b:Int,

c:Double

)

def main(args: Array[String]): Unit = {

sparksession.builder().master(local[*]).appname("d“).getOrCreate()

import spark.implicits._//隐士转换 必须加

val filds=spark.sparkContext.textFile(”e:\\text.txt“)//本地文件路径

e盘文件

q 1 1.1

q 3 2.1

f 4 44.1

.map(line=>{

val a=line.split(" ")

}).toDF().show()

file.createOrReplaceTempView("a")//视图名字也就是表名

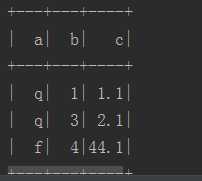

结果

原文:https://www.cnblogs.com/lppz/p/10021683.html