来源:雷锋网

原地址:

http://news.ifeng.com/a/20170515/51093579_0.shtml

=====================================================

雷锋网[AI科技评论]按:本文根据俞扬博士在中国人工智能学会AIDL第二期人工智能前沿讲习班"机器学习前沿"所作报告《强化学习前沿》编辑整理而来,雷锋网在未改变原意的基础上略作了删减,并经俞扬博士指正确认,特此感谢。全文分为上下两篇,本文为下篇。

上篇传送门:《南京大学俞扬博士:强化学习前沿(上)》

俞扬博士、副教授,主要研究领域为人工智能、机器学习、演化计算。分别于2004年和2011年获得南京大学计算机科学与技术系学士学位和博士学位。

2011年8月加入南京大学计算机科学与技术系、机器学习与数据挖掘研究所(LAMDA)从事教学与科研工作。曾获2013年全国优秀博士学位论文奖、2011年中国计算机学会优秀博士学位论文奖。发表论文40余篇,包括多篇Artificial Intelligence、IJCAI、AAAI、NIPS、KDD等国际一流期刊和会议上,研究成果获得IDEAL‘16、GECCO‘11、PAKDD‘08最佳论文奖,以及PAKDD’06数据挖掘竞赛冠军等。

任《Frontiers of Computer Science》青年副编辑,任人工智能领域国际顶级会议IJCAI’15/17高级程序委员、IJCAI‘16/17 Publicity Chair、ICDM‘16 Publicity Chair、ACML‘16 Workshop Chair。指导的学生获天猫“双十一”推荐大赛百万大奖、Google奖学金等。

在此列出俞扬老师讲课目录,以供读者参考:

一、介绍(Introduction)

二、马尔可夫决策过程(Markov Decision Process)

三、从马尔可夫决策过程到强化学习(from Markov Decision Process to Reinforce Learning)

四、值函数估计(Value function approximation)

五、策略搜索(Policy Search)

六、游戏中的强化学习(Reinforcement Learning in Games)

七、强化学习总结

八、强化学习资源推荐

在强化学习任务中,奖赏和转移都是未知的,需要通过学习得出。具体解决办法有两个:

一种是还原出奖赏函数和转移函数。首先把MDP还原出来,然后再在MDP上解这个策略,这类方法称为有模型(Model-Based)方法,这里的模型指的是MDP。

还有一类和它相对应的方法,免模型(Model-Free)法,即不还原奖赏和转移。

在这类方法中,智能体会维护Model(即MDP),然后从Model中求解策略。

从随机策略开始,把策略放到环境中运行,从运行的序列数据中把MDP恢复出来。因为序列数据可以提供环境转移和奖赏的监督信息,简单的做一个回归,就能知道一个状态做了一个动作下面会转移到哪儿,以及能得到的奖赏是多少。

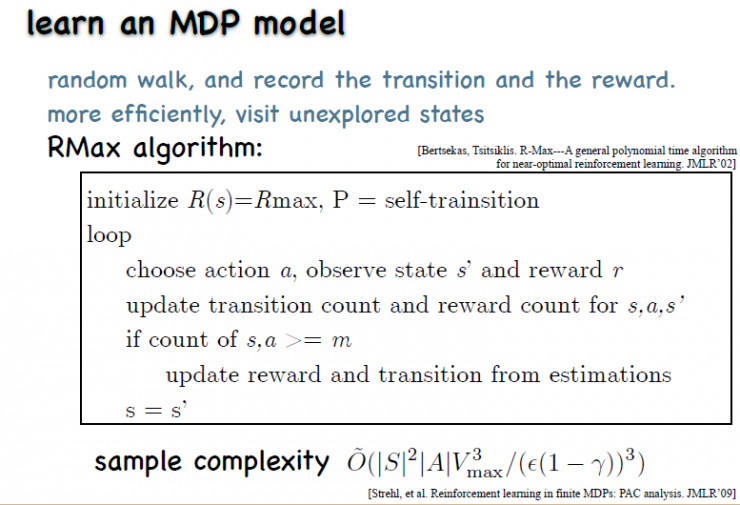

这里有一个非常简单的环境探索方法——RMax,它用了计数这个非常简单的回归模型。

虽然看起来很简单,但是还原MDP的样本复杂度是状态数的平方,远高于前面说到的求解策略的复杂度。

从这里可以看出学习MDP的复杂度极高,所以大量的研究工作都集中在免模型学习上。

=====================================================

本文转自雷锋网,如需转载请至雷锋网官网申请授权

原文:https://www.cnblogs.com/devilmaycry812839668/p/10308770.html