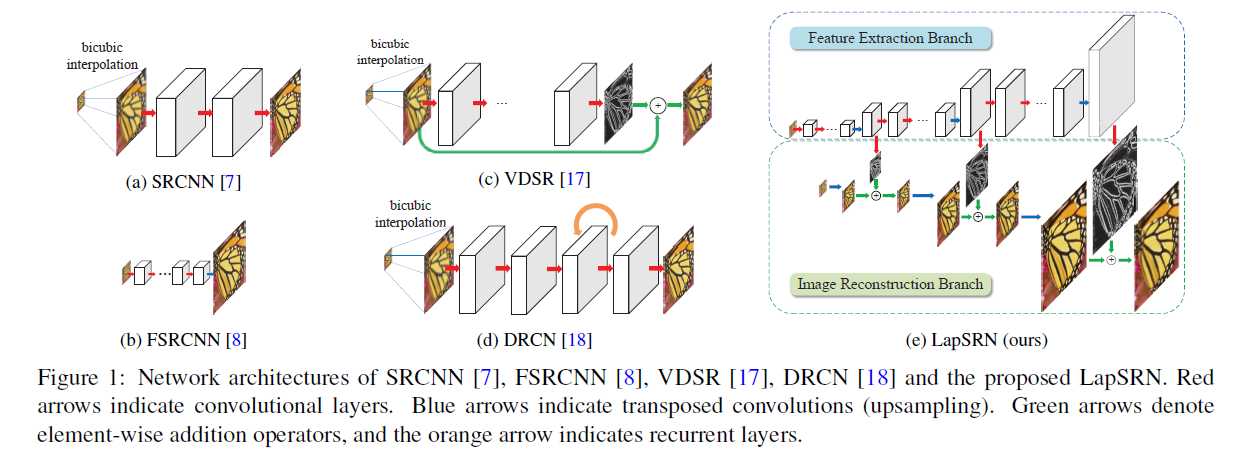

模型大致结构:LR作为输入渐进地以一种粗糙到良好的方式预测sub-band residuals。每个level用卷积提取特征然后使用反卷积上采样到finer level然后预测sub-band residuals(上采样图片与groud truth间的差异)训练模型使用charbonnier损失函数

LapSRN使用串联金字塔预测不同fator的residuals,因此其 8fator的模型依旧可以表现2 或 4 fator SR,通过bypassing(绕路)

输入:由SR下采样 为HR直接输入

特征提取:每个level(金字塔层)都有d个卷积层和一个反卷积层,反卷积层的输出分别连接到当个level重建residuals和下一个level继续提取特征训练。

图像重建:每个level的输入image都使用scale为2的反卷积进行上采样再与predicted residuals整合为HR image,该HR image,又被喂入下一个level,需要特定的scale时只需在特定的level处截断模型

损失函数:使用Charbonnier penalty function

训练细节:每个卷积层在卷积前都进行了padding保持了与输入一致,filters为64个 size为 3 x 3,反卷积的filter为3 x 3,作者在训练前进行了data argumation,实验中也对比了 data argumation的影响

原文:https://www.cnblogs.com/echoboy/p/10351021.html