首先来了解几个概念:

1) MapOutputTracker

MapOutputTracker是Spark架构中的一个模块,是一个主从架构。管理磁盘小文件的地址。

2) BlockManager

BlockManager块管理者,是Spark架构中的一个模块,也是一个主从架构。

BlockManagerMaster会在集群中有用到广播变量和缓存数据或者删除缓存数据的时候,通知BlockManagerSlave传输或者删除数据。

BlockManagerWorker会与BlockManagerWorker之间通信。

无论在Driver端的BlockManager还是在Excutor端的BlockManager都含有四个对象:

① DiskStore:负责磁盘的管理。

② MemoryStore:负责内存的管理。

③ ConnectionManager:负责连接其他的 BlockManagerWorker。

④ BlockTransferService:负责数据的传输。

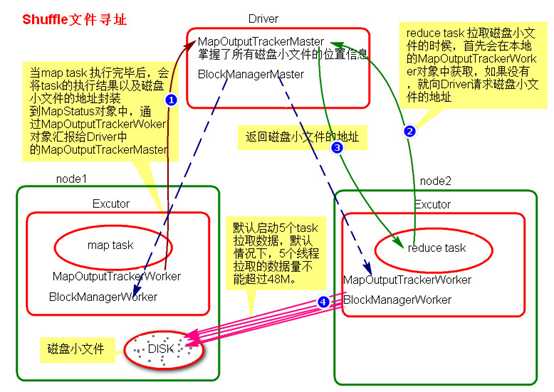

Shuffle文件寻找文件的流程图

Shuffle文件拉取流程:

a) 当map task执行完成后,会将task的执行情况和磁盘小文件的地址封装到MpStatus对象中,通过MapOutputTrackerWorker对象向Driver中的MapOutputTrackerMaster汇报。

b) 在所有的map task执行完毕后,Driver中就掌握了所有的磁盘小文件的地址。

c) 在reduce task执行之前,会通过Excutor中MapOutPutTrackerWorker向Driver端的MapOutputTrackerMaster获取磁盘小文件的地址。

d) 获取到磁盘小文件的地址后,会通过BlockManager(BlockManagerWork)中的ConnectionManager连接数据所在节点上的ConnectionManager(BlockManagerWork),然后通过BlockTransferService进行数据的传输。

e) BlockTransferService默认启动5个task去节点拉取数据。默认情况下,5个task拉取数据量不能超过48M。

原文:https://www.cnblogs.com/yehuili/p/10466248.html