下载网址

http://archive.apache.org/dist/hbase/

下载1.2.6bin.tar.gz

安装查看网址

https://www.cnblogs.com/lzxlfly/p/7221890.html

编辑 vim /etc/profile 加入

export HBASE_HOME=/home/hadoop/hadoop_home/hbase-1.2.6

export PATH=$PATH:$HBASE_HOME/bin

source ~/.profile

复制一下需要修改的内容

cp /home/hadoop/hadoop_home/hbase-1.2.6/conf/hbase-env.sh /home/hadoop/hadoop_home/hbase-1.2.6/conf/hbase-env.sh.bak

cp /home/hadoop/hadoop_home/hbase-1.2.6/conf/hbase-site.xml /home/hadoop/hadoop_home/hbase-1.2.6/conf/hbase-site.xml.bak

cp /home/hadoop/hadoop_home/hbase-1.2.6/conf/regionservers /home/hadoop/hadoop_home/hbase-1.2.6/conf/regionservers.bak

编辑vim /home/hadoop/hadoop_home/hbase-1.2.6/conf/hbase-env.sh 加入

export JAVA_HOME=/home/hadoop/hadoop_home/jdk1.8.0_181(jdk安装路径)

去掉注释 # export HBASE_MANAGES_ZK=true,使用hbase自带zookeeper。

<configuration>

<property>

<name>hbase.rootdir</name> <!-- hbase存放数据目录 -->

<value>hdfs://master:9000/user/hadoop/hbase/hbase_db</value>

<!-- 端口要和Hadoop的fs.defaultFS端口一致-->

</property>

<property>

<name>hbase.cluster.distributed</name> <!-- 是否分布式部署 -->

<value>true</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name> <!-- list of zookooper -->

<value>master,node1,node2</value>

</property>

<property><!--zookooper配置、日志等的存储位置 -->

<name>hbase.zookeeper.property.dataDir</name>

<value>/home/hadoop/hadoop_home/hbase-1.2.6/hbase/zookeeper</value>

</property>

</configuration>

编辑 vim /opt/hbase-1.2.6/conf/regionservers 去掉默认的localhost,

加入node1、node2,(换行)保存退出

然后把在master上配置好的hbase,通过远程复制命令

scp -r /home/hadoop/hadoop_home/hbase-1.2.6/ node1:/home/hadoop/hadoop_home/

scp -r ~/.profile node1:/home/hadoop/.profile

然后在node1下

source ~/.profile

scp -r /home/hadoop/hadoop_home/hbase-1.2.6/ node2:/home/hadoop/hadoop_home/

scp -r ~/.profile node2:/home/hadoop/.profile

然后在node2下

source ~/.profile

复制到node1、node对应的位置

(1)在Hadoop已经启动成功的基础上,输入start-hbase.sh,过几秒钟便启动完成,

输入jps命令查看进程是否启动成功,若 master上出现HMaster、HQuormPeer,

slave上出现HRegionServer、HQuorumPeer,就是启动成功了。

(2)输入hbase shell 命令 进入hbase命令模式

输入status命令可以看到如下内容,1个master,2 servers,3机器全部成功启动。

1 active master, 0 backup masters, 2 servers, 0 dead, 2.0000 average load

(3)接下来配置本地hosts,(前边配置过的无需再配置了)

编辑 C:\Windows\System32\drivers\etc的hosts文件,加入

192.168.0.235 master

192.168.0.225 node1

192.168.0.215 node2

在浏览器中输入http://master:16010就可以在界面上看到hbase的配置了

(4)当要停止hbase时输入stop-hbase.sh,过几秒后hbase就会被停止了。

输入

hbase shell

进入hbase界面

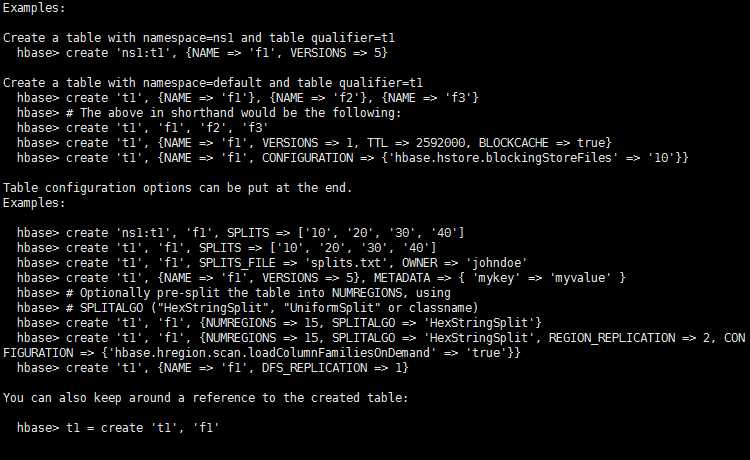

创建表的例子

例如

create ‘test‘,‘data‘ 建表

list 查看表

put ‘test‘,‘row1‘,‘data:1‘,‘value1‘ 插入数据

put ‘test‘,‘row2‘,‘data:2‘,‘value2‘

put ‘test‘,‘row3‘,‘data:3‘,‘value3‘

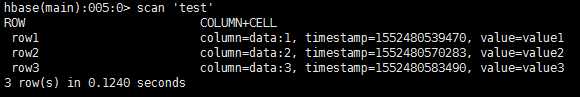

然后查看表内容

scan ‘test‘

disable ‘test‘ 移除表之前要设为禁用

drop ‘test‘ 移除表

(1)CentOS默认没有启动ssh无密登录,编辑 vim /etc/ssh/sshd_config,

去掉以下两行注释,开启Authentication免登陆。

#RSAAuthentication yes

#PubkeyAuthentication yes

如果是root用户下进行操作,还要去掉 #PermitRootLogin yes注释,允许root用户登录。

(2)输入命令,ssh-keygen -t rsa,生成key,一直按回车,

就会在/root/.ssh生成:authorized_keys id_rsa.pub id_rsa 三个文件,

这里要说的是,为了各个机器之间的免登陆,在每一台机器上都要进行此操作。

(3) 接下来,在master服务器,合并公钥到authorized_keys文件,

进入/root/.ssh目录,输入以下命令

cat id_rsa.pub>> authorized_keys 把master公钥合并到authorized_keys 中

ssh root@192.168.172.72 cat ~/.ssh/id_rsa.pub>> authorized_keys

ssh root@192.168.172.73 cat ~/.ssh/id_rsa.pub>> authorized_keys

把slave1、slave2公钥合并到authorized_keys 中

完成之后输入命令,把authorized_keys远程copy到slave1和slave2之中

scp authorized_keys 192.168.172.72:/root/.ssh/

scp authorized_keys 192.168.172.73:/root/.ssh/

最好在每台机器上进行chmod 600 authorized_keys操作,

使当前用户具有 authorized_keys的读写权限。

拷贝完成后,在每台机器上进行 service sshd restart 操作, 重新启动ssh服务。

之后在每台机器输入 ssh 192.168.172.xx,测试能否无需输入密码连接另外两台机器。

原文:https://www.cnblogs.com/pursue339/p/10526134.html