\[ ?_{AFM}(x)=ω_0+∑_{i=1}^{n}ω_{i}x_{i}+p^T∑^{n}_{i=1}∑^{n}_{j=i+1}a_{ij}(v_i⊙v_j)x_ix_j \]

模型特点

相对FM,AFM引入attention-based pooling,其学习出来的参数值用于判断不同特征之间交互的重要性。

模型案例

https://github.com/hexiangnan/attentional_factorization_machine

推荐系统遇上深度学习(八)--AFM模型理论和实践

模型架构

模型原理

\[ Φ_{FwFMs}((w,v), x) = w_{0} +∑_{i=1}^{m}x_iw_i +∑_{i=1}^{m}∑_{j=i+1}^{m}x_ix_j?v_i,v_j?r_{F (i),F (j)} \]

模型特点

相对FM,AFM引入attention-based pooling,其学习出来的参数值用于判断不同特征之间交互的重要性。

模型案例

https://github.com/hexiangnan/attentional_factorization_machine

推荐系统遇上深度学习(八)--AFM模型理论和实践

模型架构

模型原理

\[ Φ_{FwFMs}((w,v), x) = w_{0} +∑_{i=1}^{m}x_iw_i +∑_{i=1}^{m}∑_{j=i+1}^{m}x_ix_j?v_i,v_j?r_{F (i),F (j)} \]

模型特点

FwFM是在WWW‘18上由Oath公司提出的点击率预估模型,针对FFM参数量大的不足提出了改进并在著名的公开数据集Criteo上验证有效。从模型形式上可以看出FwFM与FM区别仅在于FwFM给每个二阶交叉项引入了一个实数weight:

\[

r_{F (i),F (j)}

\]

总计多出m*(m-1)/2个参数,m是field个数。

模型架构

模型原理

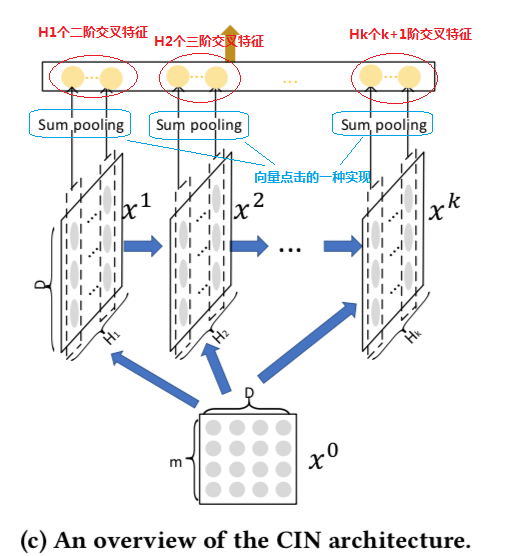

1.CIN结构:

2.矩阵\[??^??\]中的第?行的计算公式如下:

\[

X_{h,*}^k = \sum_{i=1}^{H_{k-1}}\sum_{j=1}^m{W_{ij}^{k,h}(X_{i,*}^{k-1} \circ X_{j,*}^0)}

\]

原文:https://www.cnblogs.com/arachis/p/DL4REC2.html