学习自然语言处理的同学都知道,条件随机场(crf)是个好东西。虽然它的原理确实理解起来有点困难,但是对于我们今天用到的这个crf工具crf++,用起来却是挺简单方便的。

今天只是简单试个水,参考别人的博文进行了个简单的中文分词,如有错误之处,欢迎指出。

在正式开工之前,我先介绍下条件随机场以及crf++的安装

首先介绍下啥是条件随机场,条件随机场(CRF)是给定一组输入随机变量条件下,另一组输出随机变量的条件概率分布模型。

以一组词性标注为例,给定输入X={我,喜欢,雷峰塔},那么输出为Y={名词,动词,名词}的概率应该为最大。输入序列X又称为观测序列,输出序列Y又称为状态序列。这个状态序列构成马尔可夫随机场,所以根据观测序列,得出状态序列的概率就包括,前一个状态转化为后一状态的概率和状态变量到观测变量的概率。

回到咱们的主题中文分词,采取4-tag标注(S表示单字,B表示词首,M表示词中,E表示词尾)的话,可以为X={我喜欢雷峰塔},Y={我/S喜/B欢/E雷/B峰/M塔/E}。

而crf++是个独立工具,官网的下载地址似乎进不去,可以找找其他地方的资源。

windows版本的就下载解压就行了,Linux版本的可以参照其他博文。

训练和测试的数据下载地址,这个数据集应该是人民日报的文本。

准备好工具和数据后,就可以开工了。

首先,使用python将文本数据弄成crf++能处理的格式。

def character_tagging(input_file,output_file):

input_data = codecs.open(input_file,‘r‘,‘utf-8‘)

output_data = codecs.open(output_file,‘w‘,‘utf-8‘)

for line in input_data.readlines():

word_list = line.strip().split()

for word in word_list:

if len(word)==1:

output_data.write(word+‘\tS\n‘)

else:

output_data.write(word[0]+‘\tB\n‘)

for w in word[1:len(word)-1]:

output_data.write(w+‘\tM\n‘)

output_data.write(word[len(word)-1]+‘\tE\n‘)

output_data.write(‘\n‘)

input_data.close()

output_data.close()

调用character_tagging函数将下载的文本数据放进去,这些文本是已经做了分词的。源文本类似于这样:

据 新华社 北京 12月 31日 电 ( 记者 罗 玉文 ) 中央军委 委员 、 总政治部 主任 于 永波 日前 在 会见 全军 和 武警 部队 先进 典型 代表 时 强调 , 全军 要 认真 贯彻 落实 江 泽民 主席 最近 的 重要 指示 精神 , 形成 学习 邓小平理论 的 新 高潮 , 把 这 一 学习 提高 到 十五大 所 达到 的 新 水平 , 进一步 加强 军队 的 革命化 、 现代化 、 正规化 建设 。

标记后,文本类似于这样:

据 S

新 B

华 M

社 E

北 B

京 E

1 B

2 M

月 E

3 B

1 M

日 E

电 S

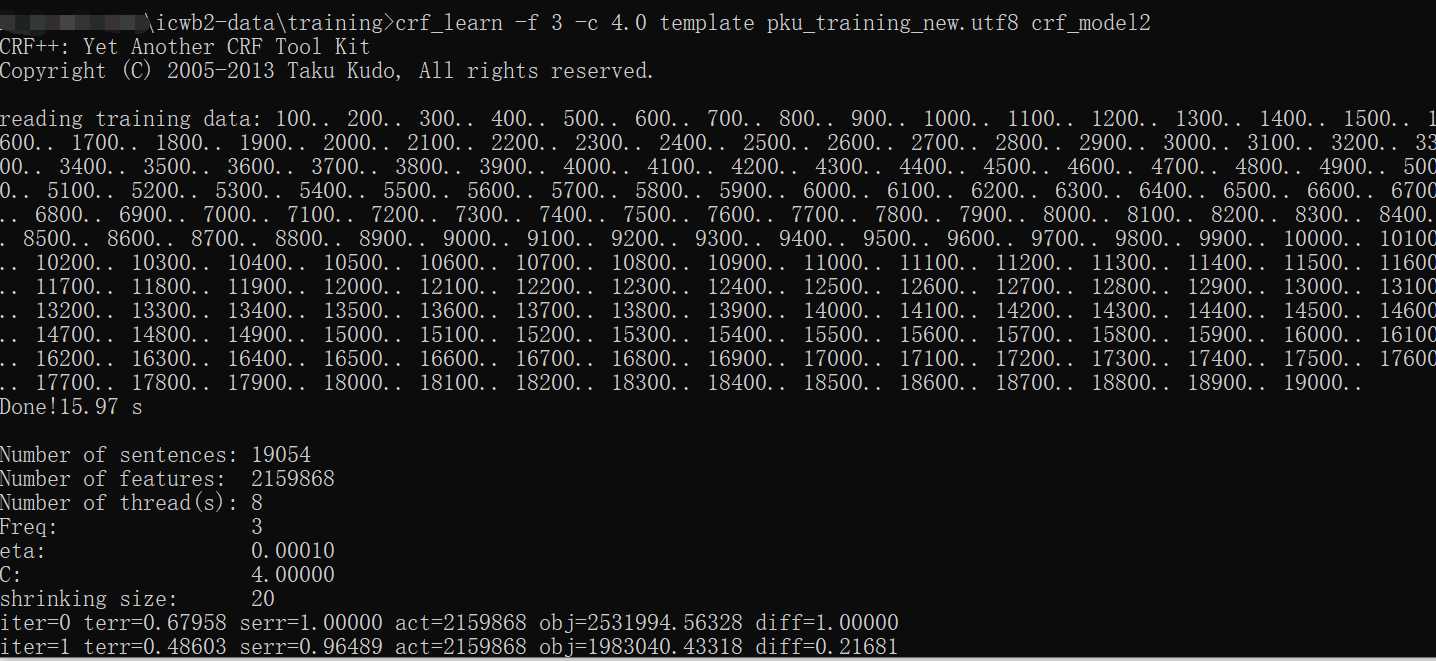

标记后的文本数据即可用来训练了,将crf++文件夹下的crf_learn.exe、crf_test.exe、libcrfpp.dll以及example目录里seg下的template文件粘到刚刚标记好的文件所在目录下,然后在该目录下进入cmd,输入crf_learn -f 3 -c 4.0 template pku_training_tag.utf8 crf_model。

运行结果如下

该目录下生成一个crf_model的模型文件,通过该模型可以对文本进行分词了。

依然是使用python进行文本数据的处理,将待分词文本处理成一列,进入cmd,输入crf_test -m crf_module data.utf8 > outfile,将生成分词结果,当然格式依然是4-tag格式,利用python转换成好看一点的格式。

def crf_convert(input_file,output_file):

out = codecs.open(output_file, ‘w‘, ‘utf-8‘)

inf = codecs.open(input_file, ‘r‘, ‘utf-8‘)

for line in inf.readlines():

if len(line) > 3:

if line[-3] == ‘S‘ or line[-3] == ‘E‘:

out.write(line[0] + ‘ ‘)

if line[-3] == ‘B‘ or line[-3] == ‘M‘:

out.write(line[0])

out.close()

inf.close()

这样,文本就做好分词了。

分词结果

据 新华社 北京 12月 31日 电 ( 记者 罗 玉文 ) 中央军委 委员 、 总政治部 主任 于 永波 日前 在 会见 全军 和 武警 部队 先进 典型 代表 时 强调 , 全军 要 认真 贯彻 落实 江 泽民 主席 最近 的 重要 指示 精神 , 形成 学习 邓小平理论 的 新 高潮 , 把 这 一 学习 提高 到 十五大 所 达到 的 新 水平 , 进一步 加强 军队 的 革命化 、 现代化 、 正规化 建设 。

感觉和人工分词效果已经差不多了,这是训练的数据比较多的时候才产生的效果,试过训练时给少量数据,然后产生了下面的分词效果

据 新华 社 北京 12 月3 1日 电( 记者 罗玉 文) 中央 军委 委 员 、 总政 治 部 主 任 于永 波 日 前 在 会 见全 军 和武 警部队 先 进典 型 代表 时强调 , 全军 要 认真 贯 彻落 实江 泽 民 主 席 最近 的 重 要 指示 精神 , 形成 学习 邓 小平 理论 的 新高 潮 , 把 这 一 学习 提高 到 十五 大所 达到 的 新水 平 , 进 一 步 加 强军队 的 革命 化 、 现 代 化 、 正规 化 建设 。

可以看出,训练数据过少会导致模型效果很不佳。

同时,训练出来的模型对实体命名似乎不太友好,比如罗玉文这个人名,分词模型并没有分对,给分成了 罗/S 玉/B文/E ,这个有待改进。

crf++实现中文分词简单例子 (Windows crf++0.58 python3)

原文:https://www.cnblogs.com/zhuangzi101/p/10702348.html