jieba库作为python中的第三方库,在平时是非常实用的,例如一些网站就是利用jieba库的中文分词搜索关键词进行工作。

一、安装环境

window + python

二、安装方式

在电脑命令符(cmd)中直接写进下面的语句:pip install jieba 即可

三、jieba库分词的基本原理

1、利用中文词库,分析汉字与汉字之间的关联几率

2、还有分析汉字词组的关联几率

3、还可以根据用户自定义的词组进行分析

四、jieba库三种模式和对应的三个函数

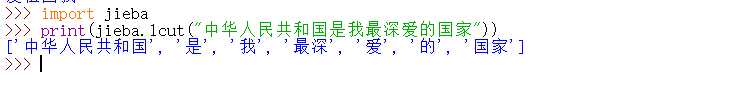

精确模式 : 把文本精确的切分开,不存在冗余单词 (就是切分开之后一个不剩的精确组合)

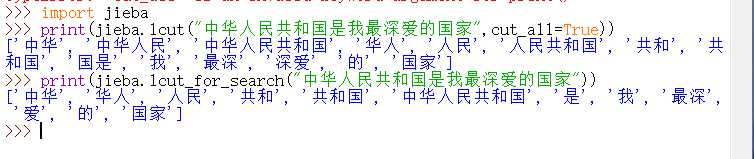

全模式 : 把文本中所有可能的词语都扫描出来,有冗余

即: 可能有一个文本,可以从不同的角度来切分,变成不同的词语。在全模式下把不同的词语都挖掘出来

搜索引擎模式:在精确模式基础上,对长词语再次切分

| 函数 | 对应模式 |

| lcut(s) | 精确模式,没有多余 |

| lcut(s,cut_all=Ture) | 全模式,有多余,长词组 |

| lcut_for_search(s) | 搜索引擎模式,有多余,长词组 |

例如:

以上就是jieba库的一些基本的知识。

原文:https://www.cnblogs.com/liyanyinng/p/10958791.html