近几年随着计算力和数据量的飞速飙升,深度学习有了自己的用武之地。最近几年,各种顶会的期刊呈指数形式不断飞升,各种网络和方法的创新也层出不穷。除此之外,一些很多年前提出的方法有的也在最新的应用中取得很好的效果。Attention模型在九几年就被提出了,开始被应用在机器视觉等方面,后来被在机器翻译等NLP方向证明用很高的应用价值。最近因为课题需要,学习了Attention模型,并将自己学到的粗浅认识记录于此。主要分为两部分:一是Attention模型在Seq2Seq问题中与RNN(LSTM、GRU)结合的模型;二是Google提出的Transform模型,本文首先介绍第一部分,并使用Pytorch框架实现基本模型。

一、 Seq2Seq模型

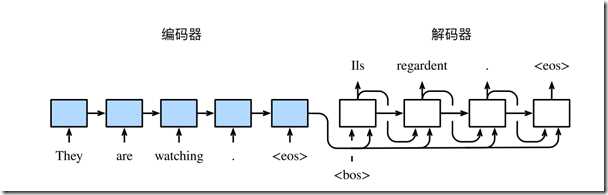

在一些任务中,模型的输入与输出可能是不定的,例如在机器翻译任务中翻译和被翻译的语言一般都是不定长的序列。在这些情况下我们可以使用编码器—解码器(encoder-decoder)或者seq2seq模型。这两个模型本质上都用到了两个循环神经网络,分别叫做编码器和解码器。编码器用来将语句编码成背景向量,而解码器将背景向量编码并输出序列。模型的具体结构如下图所示。

原文:https://www.cnblogs.com/ffjsls/p/11027051.html