识别方式不同,使得AI擅于纹理识物,弱于轮廓; 对人类来说,整体形状是物体识别的首要条件,而通过整体形状识别图像似乎根本不在这些深度学习系统考虑范畴当中。

Copy

counterfeit 伪造的

latent 潜在的

interaction 相互作用

trivial 琐碎的,微不足道的(一般用否定形式) non-trivial意为重要的

bound 限制在

separate 分开的,单独的

prominent 重要的;著名的,突出的

scalar 标量

assign 确定

simultaneously 同时地

state of the art 当前最好的(炼丹侠们的目标)

prohibitive 禁止的

analogous 类似的

optimum/optimal 最佳的;最适宜的条件

proposition 计划;主张;提议

saturate 饱和,充满

objective 目标

differentiate 区分,分开;求微分

region 区域

theorem 定理

semantic 语义的;意义 (划重点!)

segmentation 分割 semantic segmentation 语义分割

substantial 显著的,重要的 substantially 相当多地

counteract 抵消;抵制

augment 增加

manifold 流行(流行空间和流行学习,一种机器学习方法,简单理解就是数据在不同维度的一些 运算)

texture 结构,纹理

plausible 貌似合理的

alternatively 或者

alternative 可供替代的;n.选择

inherently 内在地,本质上地

external 外在的

state of art 最先进的

geometry 几何学

spark 启发

synthesis 合成;n.综合体,

compression 压缩

wavelet 小波

deviation 偏差;[数]偏差 Standard Deviation 标准差

texture 结构,纹理,质地

synthetic 合成的,人工的

assessment 评价

property 特性

intriguing 引起兴趣的

quantization数字化 quantitative 定量分析的

give rise to 造成,导致

convergence 聚合,收敛

exclude 排除

intuitive 凭直觉的

suppression 抑制,阻碍

coordinate 坐标;套装

retrieve 取回,检索

harness 利用

denote 表示;意味着

redundancy 多余,冗余

overlap 重叠的

take into account 考虑到

context 背景;环境;上下文 contextual 上下文的,背景的

pixel-wise 像素级别

generic 一般的

propagation 传播

prototype 原型

topological 拓扑的

dilation 膨胀 dilation convolution 空洞卷积

derive 得出,导出

dramatically 显著地

inverse 相反的;逆

underdetermined 证据不足的,待定的

hierarchical 分级的

junction 汇合处;枢纽站

Norm 范数

Fisher matrix 费雪矩阵

KL-divergence KL散度

metric 度量标准

curvature 曲率,曲度

First-order 一阶 order为 阶数 的意思

conjugate gradient 共轭梯度

episode 一个事件;(美剧中的剧集常用该词汇)

approximation 近似值

partition 划分

sparse 稀少的;稀疏的

decay 衰减;腐烂

redundant 被裁剪的;多余的

median 中等的;n.中位数

co-efficent 系数

fuse 融合

with respect to 至于;关于

manifold 多种多样的

adjacent 毗邻的,邻近的

ba cast to 被认为

blur 模糊

intractable 难对付的;倔强的

sidestep 回避;绕开

piece wise 分段的

analogous 相似的,可比拟的

adversarial 对抗的

overlap 重叠部分

modality 方式

distill 提取

cardiovascular 心血管的

anatomy 解剖学

promising 前景好的

hinder 阻碍,妨碍

manual 手工的

chamber 心室

annotation 注释

dense 浓密的,密集的

utility 实用的;实用程序;公共事业

interpolation 插补;插值

optional 可选择的

crop 修剪

incorporation 吸收;合并

ground truth alignments 标记数据集

silhouettes 轮廓

validation 认可

spatiotemporal 时空的

encapsulate 封装;概述

reside 属于;居住

bridge 弥补;跨越

exponentially 呈几何级数地 exponent 指数;

cornerstone 基础,垫脚石

interpolation 插入;插值

outline 提纲,梗概

residual 剩余的,残余的

explicitly 明确地;直接地

extremely 非常,极大地

model 模仿

utilize 利用

inferior 下级的;较差的

conceptually 概念上地

minor 较小的,轻微的

cascade 传递;层叠

accordance 依照 in accordance with 按照…规则

exploited 发挥;利用;开发

extent 范围;程度

threshold 门槛,阈值;下限;起征点

suppress 抑制;阻止

regime 政权,管理体制

stack 堆叠

evaluation 估计;评估(常用简写eval)

surveillance 监视

lately 最近

ensemble 合奏曲;团体

spread over 分布,散开

convergence 汇聚,相交

factor 因素;因子

propose 提出

termed 被称为

in comparison to 与....相比

engineered 设计谋划的

chunk 大量的部分

replicated 复制的

keep track of 记录;保持联系

aforementioned 上述的

minor 较小的,轻微的

favorably 正面地;很好地

impractical 不现实的

scenario 设想的情况

methodology 方法

correspond to 相当于

rectified 修复

moderate 一般的;温和的;适当的

facilitate 促进,帮助;加快

aggregated 总的

scalable 可扩展的;大小可变的

besides 而且;此外

principally 主要的

pronounced 明显的,显著的

typically 典型的;一般的

sole 仅有的,唯一的

novel 新的,与众不同的

be prone to 易于…;有…倾向

complementary 互补的;辅助性的

incrementally 增长地

attribute to 归因于

effectiveness 有效性

is equivalent to 等同于

bandwidth 带宽

alleviate 缓解,减轻

ambiguity 模棱两可,不明之处

scheme 策略;方案

breathtaking 惊人的;非常激动人心的

cavern 大山洞;挖空

drift 漂流,流动

circularly 圆地;循环地

denote 表示;意味着

diagonalize 对角化

ridge 屋脊

consider 考虑到

objective 目标;客观的

resemblance 相似处

criteria/criterion 标准

holistic 全面的,整体的

perceptual 感觉上的

be subject to 受支配;易遭受

appealing 有吸引力的

paradigm 范例,范式

variants 变体;不同版本

pedestrian 行人(自动联想到行人重识别)

mitigate 缓和

relatively 相对地

valid 合理的;符合逻辑的

address 处理

early 之前的

spread over 分散,传开

procedure 程序

is tuned to 被调整为

shallow 浅的;微弱的

decompose 分解

contiguous 毗邻的,邻近的;共同的

adjacent 毗连的,邻近的

sound 完整的

manner 方式

observe 观察;注意到;遵守

is comparable to 比得上

hypothesis 假说,假设

counterpart 对应物;相当的人

clarity 清晰;明确性

convention 惯例,公约

literature 文献

split 分开的

qualitative 性质的

exhibit 表现出

animation 动画片;动画制作技术

retain 保留,保持;记住

leverage 对...施加影响

contradict 与…矛盾;反驳

distract 转移注意力

impair 削弱;降低

surpass 超过

prioritization 优先考虑,优先顺序

slightly 略微

credit 声誉;信用

preference 偏爱

pulmonary 肺的(自动联想到医学图像)

sensitively 谨慎周到地;善解人意地

nodule 瘤 (自动联想到医学图像)

proceeding 进展;继续

clinically 客观地; 临床方式地

ensemble 全体,整体

considerably 相当多地

deploy 部署;有效利用

plane 平面

rich 丰富的

advent 出现,到来

foreground 前景 background 背景

isolation 隔离;孤立

purge 清除

mechanism 机制;途径;机械装置

readily 乐意地;容易地

collaboration 合作;合作成果

trade-off 权衡,做取舍(论文常见)

conservative 传统的;保守的

computationally 计算上地

exclusive 独有的;独家报道

recover 追回;恢复

geometric 几何的

approach 接近;处理

dilemma 困境,进退两难

stabilize 使稳定

halve 减半

symmetric 对称的

be proportional to 与...成比例

middle 中间的

namely 即

polarized 偏振的;两极分化的

concatenate 把…联系起来;串联(这是一个非常重要的词汇,也是一种数组操作的名称,注意与pixelwise-add区别)

utterance 表达;说话

contrive 策划;设计,发明

deterministic 确定的

slides (PPT)幻灯片;滑落,下跌

variance 分歧,不同

paradigm 范式,样例

prefix 前缀

go straight down 沿着...往前走

comment 意见;注解;评论

in excess of 超过,多于

propagate 繁衍,增殖;扩散,扩大

extension 延期;扩展

checkboard 棋盘(图像中有一种棋盘格效应)

vertically 竖直地,垂直地

aggressively 挑衅地;激烈地(表示程度大)

stall 拖延;货摊

accessibility 可达性

lateral 侧面的;横向的(在FPN那篇论文中提到lateral connection就是指侧面的连接)

unilaterally 单边地,单方面地

unleash 宣泄;接触…束缚

divergence 分歧;区别

spectral 谱的(常见有光谱,频谱)

simultaneous 同时发生的 simultaneously 同时地

equilibrium 均衡

pitfall 陷阱;隐藏的困难

proxy 代理人,代替物;代理服务器

distill 提取;蒸馏 Knowledge Distillation(知识蒸馏)

preceding 前面的,在先的(用于描述前面层的网络)

bypass 旁道,支路;绕过,避开

presume 推测;认为,认定

compelling 非常强烈的;强迫的,不可抗拒的

nominal 名义上的;微不足道的

bring together 联合;使相识

boarder 寄宿生,高校的学生;登船(机)的人

fellow 研究员;同事,同伴(常见的有 IEEE fellow)

commitment 承诺;委任;(对工作或活动)献身

coarse 粗糙的

consecutive 连续的,连贯的

immense 巨大的

inferior 不好的;低劣的,下等的

variability 变化性,易变;变率

preliminary 初步的;预赛的

sidestep 回避,躲开

accommodate 为…提供住宿;容纳;为...提供便利(这也是一个雅思重点词汇)

to date 迄今,到目前为止

modality 方式

duality 二元性

tweak 扭,拽;轻微调整

reproduce 复制,模仿;再现

dummy 仿制品;笨蛋,蠢货;假的

ordinal 序数;比较

layout 布局,安排,设计(界面的排版就成为layout)

mutate 变异;突变,变化

alias 别名

elevation 高处,海拔

heterogeneous 各种各样的;成分混杂的

in-place 原状(在一些函数接口中常见,是指在原对象或原址中操作,无需返回)

metadata 元数据

transaction 交易,业务;学报,会议记录(TPAMI, TIP中的"T";一些操作中transaction done就是指你交代的业务执行完了)

perspective 观点;视角

stampede 蜂拥

arguably 可论证地

ridge 屋脊,山脊

occlusion 堵塞;闭塞

daunting 畏惧的,令人却步的

seamless 无缝的;无漏洞的

protocal 会议纪要;协议(例如;Http protocal)

symmetric 对称的

contract 收缩;签订合同

scarce 稀有的,稀少的;不足的

discrete 分离的

terminology 术语;专门名词

deformable 可变形的(Deformable Conv可变性卷积)

mentor 导师,顾问

discretize 使离散

pane 面板;窗格

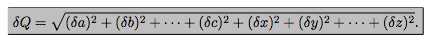

stale 不新鲜的,厌倦的一个门高为\(0.88m\pm0.02m\), 门把手高\(0.5m\pm0.01m\), 那么门顶部到门把手距离怎么表示? 应该是在0.88-0.5=0.35左右, 那么误差呢?, 使用公式\[error uncertainity=\sqrt{({0.02}^2+{0.01}^2)}\]

以上是加法, 如果为减法

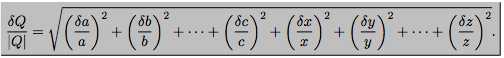

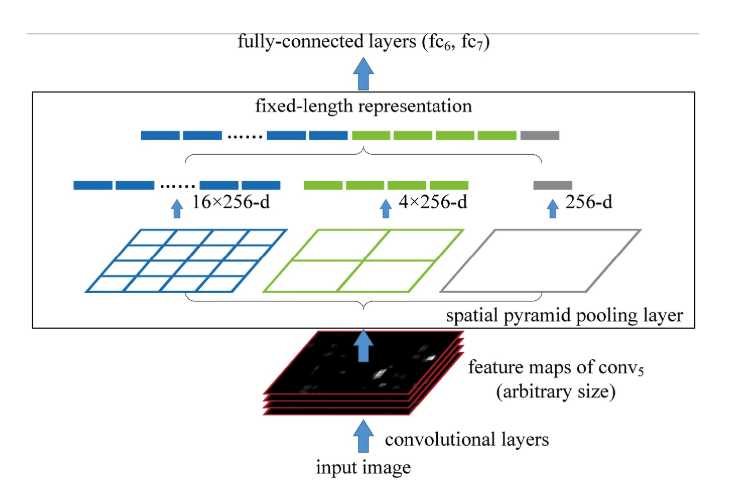

上图中同一组, 每一层之间做差分

class SPPLayer(nn.Module):

def __init__(self, sides):

"""

Parameters

----------

sides : array-like

A list of side lengths

"""

super(SPPLayer, self).__init__()

self.sides = sides

def forward(self, x):

out = None

for side in self.sides:

ksize = tuple(map(lambda v: math.ceil(v / side), x.size()[2:]))

strides = tuple(map(lambda v: math.floor(v / side), x.size()[2:]))

paddings = (math.floor(ksize[0] * side - x.size()[2]), math.floor(ksize[1] * side - x.size()[3]))

output = nn.MaxPool2d(ksize, strides, paddings)(x)

if out is None:

out = output.view(-1)

else:

out = t.cat([out, output.view(-1)])

return out

ISOMAP算法的主要流程, 主要由KNN, Dijkstra, MDS(多维缩放算法)算法组成

结果图

熵衡量的是不确定性, 事件发生的概率越小, 不确定性越大, 信息量越大

原文:https://www.cnblogs.com/megachen/p/11154702.html