第一个是SGD想要很好的收敛需要在调节学习率上下很大的功夫。

第二个是不同的参数都用了相同的学习率,但是实际上不同参数的学习的难度是不同的,我们会希望哪些难以学习的参数有更大的学习率。

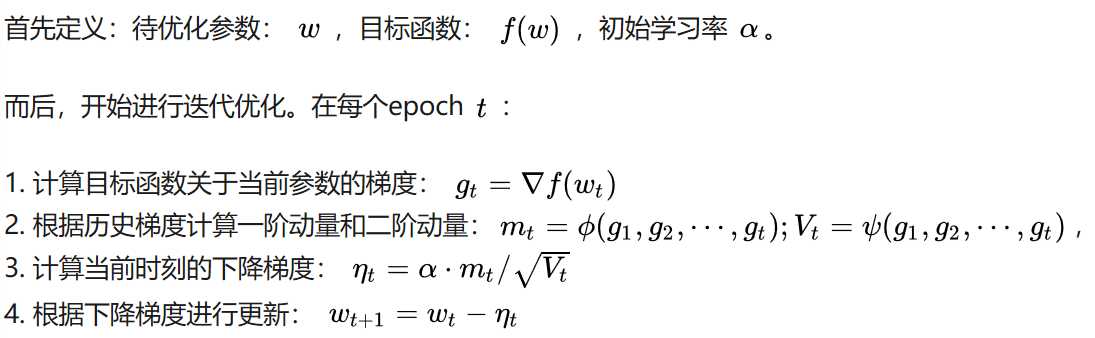

对于第一个缺点,我们引入了一阶动量,即根据前面累积的梯度的值来自发的控制学习率的变化,使算法能更好的收敛,简化算法调节学习率的难度。

对于第二个缺点,我们引入了二阶动量使不同的参数有不同大小的学习率,使算法能更好的处理不同参数学习难易程度的差别。

https://zhuanlan.zhihu.com/p/32230623

https://blog.csdn.net/leadai/article/details/79178787

原文:https://www.cnblogs.com/xumaomao/p/11182733.html