互联网:由网络设备(网线,路由器,交换机,防火墙)和一台台计算机连接而成,像一张网一样。

互联网建立目的:互联网的核心价值在与数据的共享/传递:数据是存放在一台台机器上,将计算机联到一起的目的为了能方便彼此之间的数据共享/传递,否则你只能拿U盘去别人的计算机上拷贝数据。

爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程。

通用爬虫:爬取整个页面源码数据,抓取数据

聚焦爬虫:爬取一个页面中局部的数据(数据解析),也就是有用的数据

增量式爬虫:用于检测网站数据更新的情况,从而爬取网站中最新更新出来的数据

互联网中最有价值的便是数据,比如天猫商城的商品信息,链家网的租房信息,雪球网的证券投资信息等等,这些数据都代表了各个行业的真金白银,可以说,谁掌握了行业内的第一手数据,谁就成了整个行业的主宰。

如果自己的门户网站中的指定页面中的数据不想让爬虫程序爬取到的话,那么则可以通过编写一个robots.txt的协议文件来约束爬虫程序的数据爬取。robots协议的编写格式可以观察淘宝网的robots(访问www.taobao.com/robots.txt即可)。

但是需要注意的是,该协议只是相当于口头的协议,并没有使用相关技术进行强制管制,所以该协议是防君子不防小人。但是我们在学习爬虫阶段编写的爬虫程序可以先忽略robots协议。

门户网站通过相应的策略和技术手段,防止爬虫程序进行网站数据的爬取。

爬虫程序通过相应的策略和技术手段,破解门户网站的反爬虫手段,从而爬取到相应的数据。

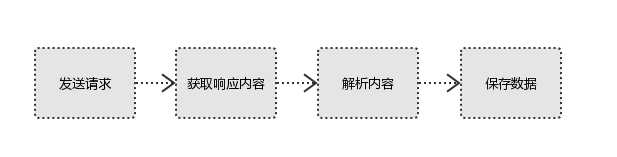

1.发起请求:

使用http库向目标站点发起请求,即发送一个request,包含:请求头、请求体

2.获取相应内容:

如果服务器能正常响应,则会得到一个Response,包含:html,json,图片,视频

3.解析内容:

解析html数据:正则表达式,第三方解析库如Beautiful,xpath,pyquery等。

解析json数据:json模块

解析二进制数据:以b的方式写入文件

4.保存数据

数据库,文件

常用请求方式:GET,POST

其他请求方式:HEAD,PUT,DELETE,OPTHONS

post与get请求最终都会拼接成这种形式:k1=xxx&k2=yyy&k3=zzz

post请求的参数放在请求体内:可用浏览器查看,存放于form data内。

get请求的参数直接放在url后。

url全称统一资源定位符,如一个网页文档,一张图片,一个视频等都可以用url唯一来确定。

网页的加载过程是: 加载一个网页,通常都是先加载document文档,在解析document文档的时候,遇到链接,则针对超链接发起下载图片的请求。

User-Agent:请求载体的身份标识

Connection:close连接方式

content-type:响应数据类型

Referer:上一次的跳转路径

如果是get方式,请求体没有内容。

如果是post方式,请求体是format data。

登录窗口,文件上传等,信息都会被附加到请求体内

登录,输入错误的用户名密码,然后提交,就可以看到post,正确登录后页面通常会跳转,无法捕捉到post

1.响应状态

200:代表成功

301:代表跳转

404:文件不存在

403:权限

502:服务器错误

2.Response header

location:跳转

set-cookie:可能有多个,告诉浏览器,把cookie保存下来

3.preview

最主要的部分,包含了请求资源的内容,如html,图片等

http协议更多相信见

这里就简单回顾一下。

1.官方概念:HTTP协议是Hyper Text Transfer Protocol(超文本传输协议)的缩写,是用于从万维网(WWW:World Wide Web )服务器传输超文本到本地浏览器的传送协议。听烂了的概念

2.自述概念:HTTP协议就是服务器(Server)和客户端(Client)之间进行数据交互(相互传输数据)的一种形式。

HTTP协议工作于客户端-服务端架构为上。浏览器作为HTTP客户端通过URL向HTTP服务端即WEB服务器发送所有请求。Web服务器根据接收到的请求后,向客户端发送响应信息。

HTTP使用统一资源标识符(Uniform Resource Identifiers, URI)来传输数据和建立连接。URL是一种特殊类型的URI,包含了用于查找某个资源的足够的信息

URL,全称是UniformResourceLocator, 中文叫统一资源定位符,是互联网上用来标识某一处资源的地址。以下面这个URL为例,介绍下普通URL的各部分组成:http://www.aspxfans.com:8080/news/index.asp?boardID=5&ID=24618&page=1#name

从上面的URL可以看出,一个完整的URL包括以下几部分:

协议部分:该URL的协议部分为“http:”,这代表网页使用的是HTTP协议。在Internet中可以使用多种协议,如HTTP,FTP等等本例中使用的是HTTP协议。在"HTTP"后面的“//”为分隔符

域名部分:该URL的域名部分为“www.aspxfans.com”。一个URL中,也可以使用IP地址作为域名使用

端口部分:跟在域名后面的是端口,域名和端口之间使用“:”作为分隔符。端口不是一个URL必须的部分,如果省略端口部分,将采用默认端口

虚拟目录部分:从域名后的第一个“/”开始到最后一个“/”为止,是虚拟目录部分。虚拟目录也不是一个URL必须的部分。本例中的虚拟目录是“/news/”

文件名部分:从域名后的最后一个“/”开始到“?”为止,是文件名部分,如果没有“?”,则是从域名后的最后一个“/”开始到“#”为止,是文件部分,如果没有“?”和“#”,那么从域名后的最后一个“/”开始到结束,都是文件名部分。本例中的文件名是“index.asp”。文件名部分也不是一个URL必须的部分,如果省略该部分,则使用默认的文件名

锚部分:从“#”开始到最后,都是锚部分。本例中的锚部分是“name”。锚部分也不是一个URL必须的部分

参数部分:从“?”开始到“#”为止之间的部分为参数部分,又称搜索部分、查询部分。本例中的参数部分为“boardID=5&ID=24618&page=1”。参数可以允许有多个参数,参数与参数之间用“&”作为分隔符。

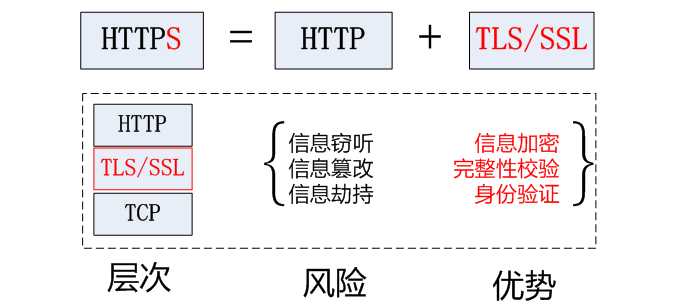

1.官方概念:HTTPS (Secure Hypertext Transfer Protocol)安全超文本传输协议,HTTPS是在HTTP上建立SSL加密层,并对传输数据进行加密,是HTTP协议的安全版。

2.自述概念:加密安全版的http协议

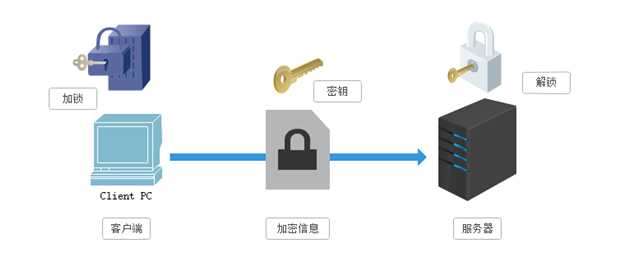

SSL采用的加密技术叫做“共享密钥加密”,也叫作“对称密钥加密”。

加密过程:

客户端向服务器发送一条信息,首先客户端会采用已知的算法对信息进行加密,比如MD5或者Base64加密,接收端对加密的信息进行解密的时候需要用到密钥,中间会传递密钥,(加密和解密的密钥是同一个),密钥在传输中间是被加密的。

缺点:

这种方式看起来安全,但是仍有潜在的危险,一旦被窃听,或者信息被挟持,就有可能破解密钥,而破解其中的信息。因此“共享密钥加密”这种方式存在安全隐患

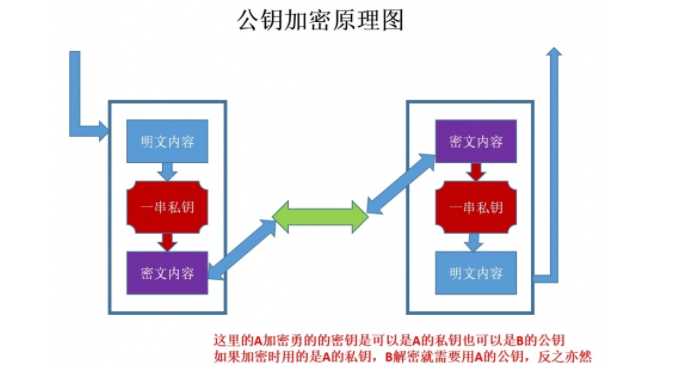

加密过程:

“非对称加密”使用的时候有两把锁,一把叫做“私有密钥”,一把是“公开密钥”,使用非对象加密的加密方式的时候,服务器首先告诉客户端按照自己给定的公开密钥进行加密处理,客户端按照公开密钥加密以后,服务器接受到信息再通过自己的私有密钥进行解密,这样做的好处就是解密的钥匙根本就不会进行传输,因此也就避免了被挟持的风险。

就算公开密钥被窃听者拿到了,它也很难进行解密,因为解密过程是对离散对数求值,这可不是轻而易举就能做到的事。

缺点:

如何保证接收端向发送端发出公开秘钥的时候,发送端确保收到的是预先要发送的,而不会被挟持。只要是发送密钥,就有可能有被挟持的风险。

非对称加密的方式效率比较低,它处理起来更为复杂,通信过程中使用就有一定的效率问题而影响通信速度

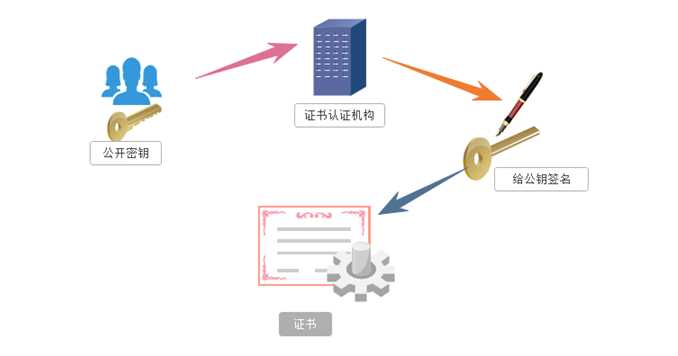

数字证书认证机构是客户端与服务器都可信赖的第三方机构。

证书的具体传播过程如下:

服务器的开发者携带公开密钥,向数字证书认证机构提出公开密钥的申请,数字证书认证机构在认清申请者的身份,审核通过以后,会对开发者申请的公开密钥做数字签名,然后分配这个已签名的公开密钥,并将密钥放在证书里面,绑定在一起。

服务器将这份数字证书发送给客户端,因为客户端也认可证书机构,客户端可以通过数字证书中的数字签名来验证公钥的真伪,来确保服务器传过来的公开密钥是真实的。一般情况下,证书的数字签名是很难被伪造的,这取决于认证机构的公信力。

原文:https://www.cnblogs.com/ryxiong-blog/p/11285575.html