网络爬虫就是模拟浏览器去伪造请求

数据从何而来:

1.企业产生的

2.数据平台购买

3.政府/机构公开的

4.爬取网络数据

爬虫的分类:

1.通用爬虫:搜索引擎抓取系统的组成,大而全但信息不精确

2.聚焦爬虫:抓取之前先筛选内容,只抓取需要的数据

几点提示:

1.requests很好用,但个别难缠的网站还是会用urllib

2.打码平台可以对付12306图片验证码

3.网页上找不到数据,可以把浏览器调成手机模式

Python字符串内容补充

字符串的两种表现形式:

1.bytes类型:二进制。网上数据都是以二进制的方式进行传输

2.str类型:unicode的呈现形式

ASCII、GB2312、unicode等都是字符集

ASCII编码是1个字节,unicode编码通常是2个字节。

UTF-8是unicode的实现方式之一(UTF-8是unicode的升级版或子集),UTF-8是一种变长的编码,可以是1、2、3个字节。

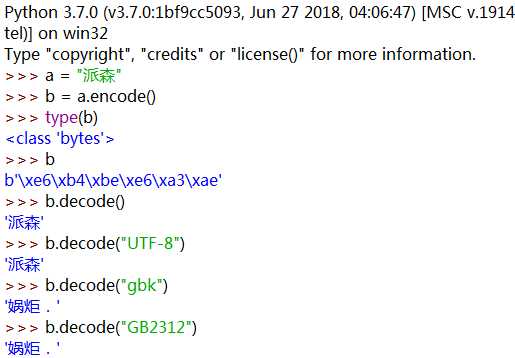

Python3中bytes和str之间的类型转换:

encode()编码,默认utf-8;decode()解码,默认也是utf-8

注意:编码时若指定了其他编码格式,那么解码时也必须是对应的编码,否则就会发生解码解出来不是原本的内容或是一堆看不懂的乱码,甚至报错!

HTTP/HTTPS

HTTP:超文本传输协议,默认端口80。所谓协议就是互联网的约定,约定好怎么传数据,怎么拿数据。

HTTPS:HTTP+SSL(安全套接字层),默认端口443。发送数据时进行加密,接受到数据时先解密再拿数据。

HTTPS更加安全,但效率比较慢。

备注:在Django开发中是可以指定80端口的,但小于1000的端口号需要超级管理员权限才能启动。

原文:https://www.cnblogs.com/quanquan616/p/11336581.html