假设式作用于单一数据点产生的概率

\(P(y|x)=\)\(\begin{cases} h(x),y=1\\ 1-h(x) ,y=-1 \end{cases}\)

由\(\theta\)函数\(\theta(x)=\frac{e^s}{1+e^s}\)可得,\(\theta(-s)=1-\theta(s)\),带入到上式可以简化为

\(P(y|x)=\theta(yw^Tx)\)

作用于数据集\(D=(x_1,y_1),...,(x_n,y_n)\)的可能性就是

\(\prod_{n=1}^{N}P(y_n|x_n)=\prod_{n=1}^N\theta(y_nw^Tx_n)\)

假设式输出的概率\(P(y|x)\)描述了该数据点是正确标签的概率,显然这个数值越大越好

同理作用于数据集的可能性可以使用每个样本点的概率连乘来衡量,也是数值越大越好

目标 Maximize \(\prod_{n=1}^N\theta(y_nw^Tx_n)\)

等价于 Maximize \(ln(\prod_{n=1}^N\theta(y_nw^Tx_n))\)

等价于 Maximize \(\frac{1}{N}ln(\prod_{n=1}^N\theta(y_nw^Tx_n))\)

等价于 Minimize \(-\frac{1}{N}ln(\prod_{n=1}^N\theta(y_nw^Tx_n))\)

等价于 Minimize \(\frac{1}{N}\sum_{n=1}^Nln(\frac{1}{\theta(y_nw^Tx_n)})\)

由\(\theta\)函数\(\theta(x)=\frac{e^s}{1+e^s}\)可得,\(\frac{1}{\theta(s)}=1+e^-s\),带入到上式可以简化为

等价于 Minimize \(\frac{1}{N}\sum_{n=1}^Nln(1+e^{-y_nw^Tx_n})\)

即\(E_{in}(w)=\frac{1}{N}\sum_{n=1}^Nln(1+e^{-y_nw^Tx_n})\)

\(e(h(x_n),y_n)=ln(1+e^{-y_nw^Tx_n})\) 交叉熵误差(cross-entropy)

\(E_{in}(w)=\frac{1}{N}\sum_{n=1}^Nln(1+e^{-y_nw^Tx_n})\)

我们只要设法减小\(E_{in}\)就行

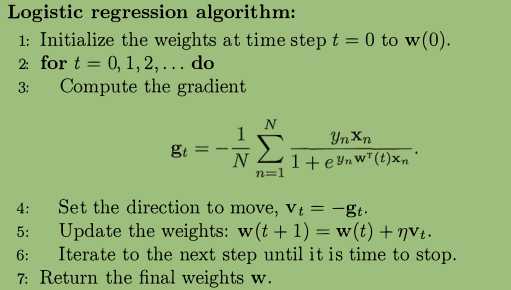

在逻辑回归中无法像线性回归找到闭合解,只能寻求迭代解

梯度下降就像是置身于漆黑的山林中,你想下山却只能看清周围两米范围内的事物,所以你每次都环视四周,然后挑选一个斜度大的方向走一步,如此重复最终走到山脚,但也有可能走到一个山谷(局部最优解)

减小\(E_{in}(w)\)的过程就是修正参数w的过程,我们每次将w朝着\(E_{in}\)减小的方向修正,最终也许就会到达目标

\(\eta\)称作学习速率

\(\frac{dE_{in}(w)}{dw}=-\frac{1}{N}\sum_{n=1}^N\frac{y_nx_n}{1+e^{y_nw^Tx_n}}\)

\(w(1)=w(0)+\eta\frac{dE_{in}(w)}{dw}\)

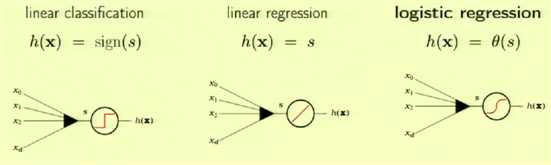

| 模型 | 线性分类 | 线性回归 | 逻辑回归 |

|---|---|---|---|

| h(x) | sign(s)硬阈值 | 无处理 | \(\theta(x)\)软阈值 |

| 输出 | 二分类 | 实值 | 概率 |

三种模型作用于信用卡审核的意义

| 模型 | 线性分类 | 线性回归 | 逻辑回归 |

|---|---|---|---|

| 输出的意义 | 批准还是拒绝 | 信用额度的确定 | 批准的概率 |

原文:https://www.cnblogs.com/redo19990701/p/11397071.html