这里讨论的优化问题指的是,给定目标函数f(x),我们需要找到一组参数x(权重),使得f(x)的值最小。

本文以下内容假设读者已经了解机器学习基本知识,和梯度下降的原理。

SGD指stochastic gradient descent,即随机梯度下降。是梯度下降的batch版本。

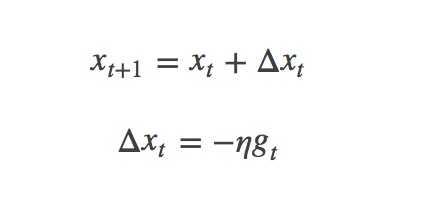

对于训练数据集,我们首先将其分成n个batch,每个batch包含m个样本。我们每次更新都利用一个batch的数据,而非整个训练集。即:

其中,η为学习率,gt为x在t时刻的梯度。

这么做的好处在于:

SGD方法的一个缺点是,其更新方向完全依赖于当前的batch,因而其更新十分不稳定。解决这一问题的一个简单的做法便是引入momentum。

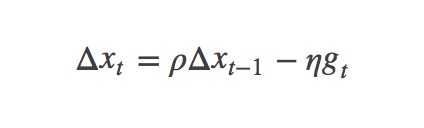

momentum即动量,它模拟的是物体运动时的惯性,即更新的时候在一定程度上保留之前更新的方向,同时利用当前batch的梯度微调最终的更新方向。这样一来,可以在一定程度上增加稳定性,从而学习地更快,并且还有一定摆脱局部最优的能力:

其中,ρ 即momentum,表示要在多大程度上保留原来的更新方向,这个值在0-1之间,在训练开始时,由于梯度可能会很大,所以初始值一般选为0.5;当梯度不那么大时,改为0.9。η 是学习率,即当前batch的梯度多大程度上影响最终更新方向,跟普通的SGD含义相同。ρ 与 η 之和不一定为1。

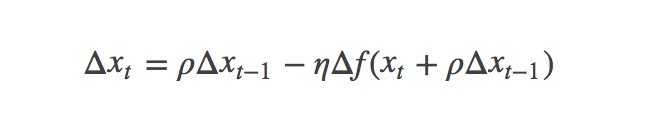

这是对传统momentum方法的一项改进,由Ilya Sutskever(2012 unpublished)在Nesterov工作的启发下提出的。

首先,按照原来的更新方向更新一步(棕色线),然后在该位置计算梯度值(红色线),然后用这个梯度值修正最终的更新方向(绿色线)。上图中描述了两步的更新示意图,其中蓝色线是标准momentum更新路径。

公式描述为:

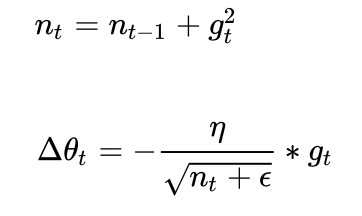

Adagrad其实是对学习率进行了一个约束。即:

此处,对从1到

进行一个递推形成一个约束项regularizer,

,

用来保证分母非0

特点:

缺点:

Adadelta是对Adagrad的扩展,最初方案依然是对学习率进行自适应约束,但是进行了计算上的简化。Adagrad会累加之前所有的梯度平方,而Adadelta只累加固定大小的项,并且也不直接存储这些项,仅仅是近似计算对应的平均值。即:

在此处Adadelta其实还是依赖于全局学习率的,但是作者做了一定处理,经过近似牛顿迭代法(求根点)之后:

其中,代表求期望。

此时,可以看出Adadelta已经不用依赖于全局学习率了。

特点:

RMSprop可以算作Adadelta的一个特例:

当时,

就变为了求梯度平方和的平均数。

如果再求根的话,就变成了RMS(均方根):

此时,这个RMS就可以作为学习率的一个约束:

特点:

Adam(Adaptive Moment Estimation)本质上是带有动量项的RMSprop,它利用梯度的一阶矩估计和二阶矩估计动态调整每个参数的学习率。Adam的优点主要在于经过偏置校正后,每一次迭代学习率都有个确定范围,使得参数比较平稳。公式如下:

其中,,

分别是对梯度的一阶矩估计和二阶矩估计,u和v为衰减率,u通常为0.9,v通常为0.999,可以看作对期望

,

的估计;

,

是对

,

的校正,这样可以近似为对期望的无偏估计。可以看出,直接对梯度的矩估计对内存没有额外的要求,而且可以根据梯度进行动态调整,而

对学习率形成一个动态约束,而且有明确的范围。

特点:

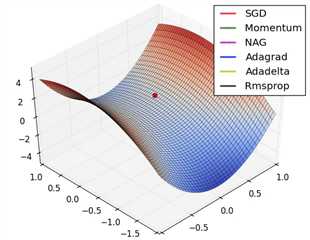

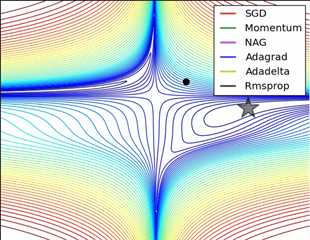

性能比较

损失曲面的轮廓和不同优化算法的时间演化(Contours of a loss surface and time evolution of different optimization algorithms)

参考:

[1] Optimization Algorithms for Deep Learning

[2] Adam — latest trends in deep learning optimization

[3] Intro to optimization in deep learning: Momentum, RMSProp and Adam

[4] Gradient Descent based Optimization Algorithms for Deep Learning Models Training

原文:https://www.cnblogs.com/carsonzhu/p/11413378.html