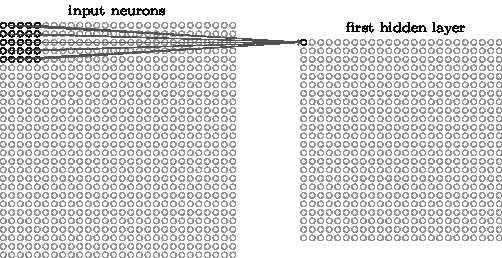

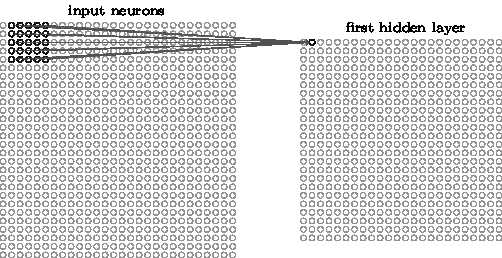

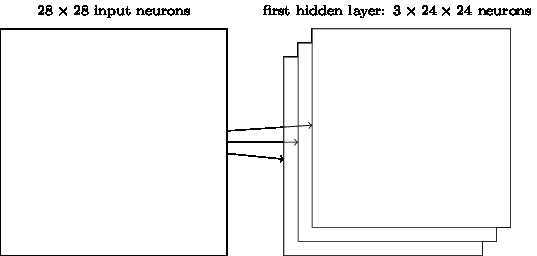

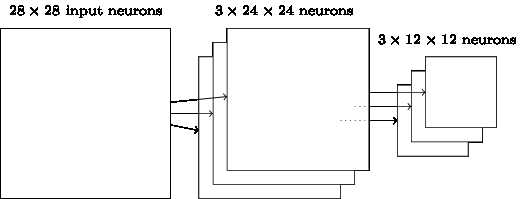

对于每一个feature map, 需要 5x5=25个权重参数, 加上1个偏向b, 26个

如果有20个feature maps, 总共26x20=520个参数就可以定义CNN

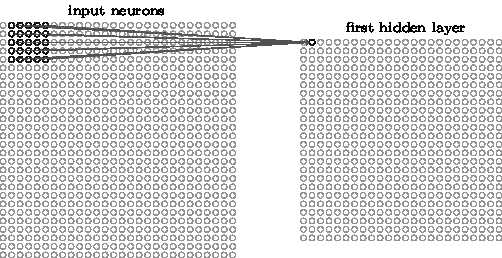

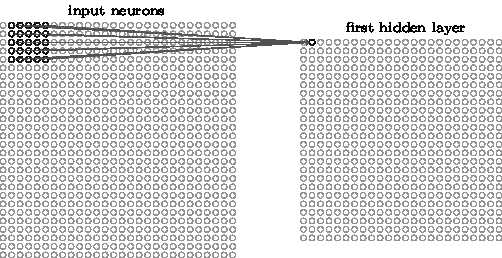

如果像之前的神经网络, 两两相连, 需要 28x28 = 784 输入层, 加上第一个隐藏层30个神经元, 则需要784x30再加上30个b, 总共23,550个参数! 多了40倍的参数.

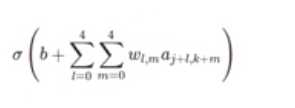

也可以写成:

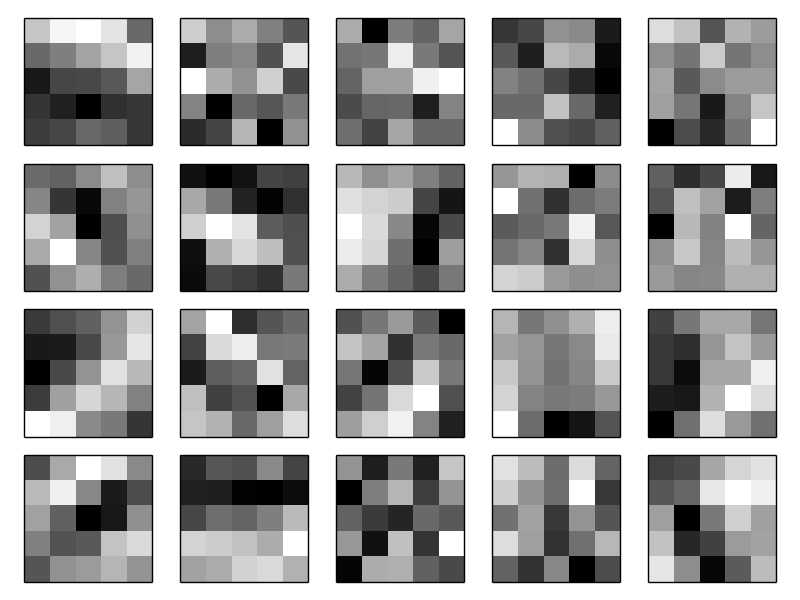

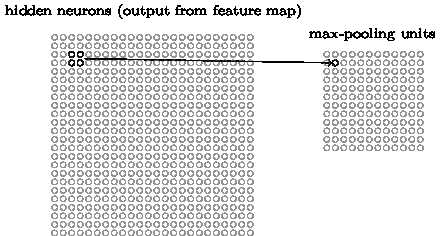

Pooling layers:

浓缩神经网聚的代表性, 减小尺寸:

24x24 , 2x2 pooling => 12x12

多个feature maps:

重要特征点找到之后, 绝对位置并不重要, 相对位置更加重要

其他pooling: L2 pooling, 平方和开方

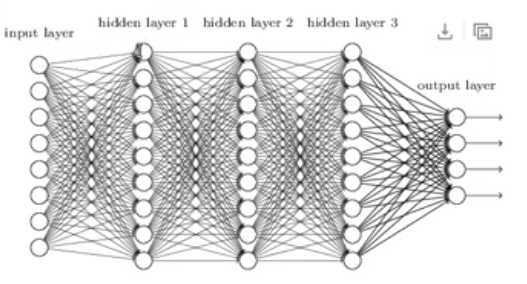

以上所有步骤结合在一起:

还是用Backpropagation, gradient descent解决