kafka的认证方式一般有如下3种:

1. SASL/GSSAPI 从版本0.9.0.0开始支持

2. SASL/PLAIN 从版本0.10.0.0开始支持

3. SASL/SCRAM-SHA-256 以及 SASL/SCRAM-SHA-512 从版本0.10.2.0开始支持

其中第一种SASL/GSSAPI的认证就是kerberos认证,对于java来说有原生的支持,但是对于python来说配置稍微麻烦一些,下面说一下具体的配置过程,confluent kafka模块底层依赖于librdkafka,这是使用c编写的高性能的kafka客户端库,有好多语言的库都是依赖于这个,所以GSSAPI接口的开启也需要在librdkafka编译的时候支持

librdkafka源码:https://github.com/edenhill/librdkafka

编译之前需要先安装必要的开发包,否则相关的接口编译不进去

首先是openssl库,使用yum安装为: yum -y install openssl openssl-devel ,编译openssl只能支持默认的PLAIN还有SCRAM这两种机制,无法支持GSSAPI的机制,还需要编译libsasl2依赖,yum安装命令如下:

yum install cyrus-sasl-gssapi cyrus-sasl-devel

在ubuntu下使用命令: apt-get install libsasl2-modules-gssapi-mit libsasl2-dev 安装libsasl2开发包

然后确认一下是否有zlib库,这个是方便对kafka消息压缩使用的,一般都会存在,安装命令: yum install zlib-devel ,如果需要更高的性能可以手动编译安装zstd并且启用压缩,这里不再详细叙述

上面的库都安装成功就可以开始编译librdkafka源码了,这里源码包为:librdkafka-1.2.1.tar.gz,安装命令如下:

# 解压包 tar -xvzf librdkafka-1.2.1.tar.gz cd librdkafka-1.2.1 # 编译源码 ./configure make make install

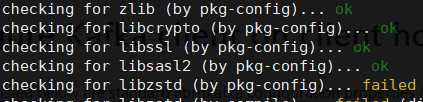

上面注意一下在执行命令./configure之后,根据输出确认libssl以及libsasl2是否被开启,如下:

这里libssl以及libsasl2都显示ok说明是可以的,现在SSL和SASL SCRAM以及SASL GSSAPI都已经支持了,执行configure阶段没指定prefix则默认安装位置为/usr/local,动态库位置就为:/usr/local/lib,需要将这个目录添加到动态库连接列表中,比如加到/etc/ld.so.conf,保存后执行ldconfig生效

最后可以编译和安装python的confluent kafka模块,这里安装的版本是1.2.0,安装之后可以运行下面的代码测试:

1 #!/usr/bin/env python3 2 # coding=utf-8 3 from confluent_kafka import Producer 4 5 def delivery_report(err, msg): 6 """ Called once for each message produced to indicate delivery result. 7 Triggered by poll() or flush(). """ 8 if err is not None: 9 print(‘Message delivery failed: {}‘.format(err)) 10 else: 11 print(‘Message delivered to {} [{}]‘.format(msg.topic(), msg.partition())) 12 13 if __name__ == ‘__main__‘: 14 producer_conf = { 15 "bootstrap.servers": ‘192.168.0.3:9092,192.168.0.4:9092,192.168.0.5:9092‘, 16 "security.protocol": ‘sasl_plaintext‘, 17 ‘sasl.kerberos.service.name‘: ‘kafka‘, 18 ‘sasl.kerberos.keytab‘: ‘/opt/user.keytab‘, 19 ‘sasl.kerberos.principal‘: ‘kafkauser‘, 20 } 21 p = Producer(producer_conf) 22 23 p.poll(0) 24 p.produce(‘testTopic‘, ‘confluent kafka test‘.encode(‘utf-8‘), 25 callback=delivery_report) 26 27 p.flush() 28 print(‘done‘)

如果生产消息正常就配置成功了,使用GSSAPI只需要配置security.protocol以及keytab的路径即可,其他的认证参数比如用户名和密码在不同的认证机制下配置,更多的配置参数参考文档:https://github.com/edenhill/librdkafka/blob/master/CONFIGURATION.md

librdkafka SASL认证的详细配置流程参考:https://github.com/edenhill/librdkafka/wiki/Using-SASL-with-librdkafka

python confluent kafka客户端配置kerberos认证

原文:https://www.cnblogs.com/freeweb/p/11655833.html