1. 下载nodejs

2.下载javaScript编辑器webStorm或者 vs (根据自己的习惯)

3. 在d盘新建一个文件夹WebSpider

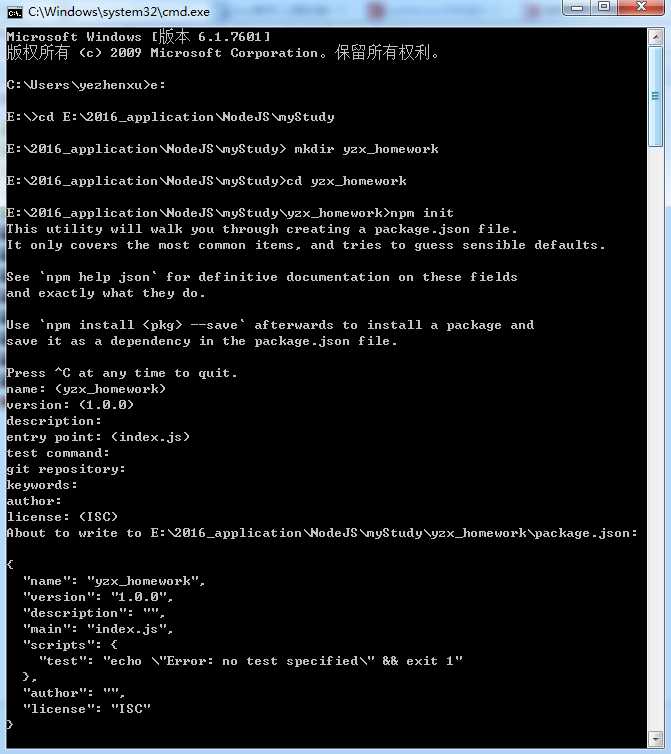

4 .cmd右键以管理员模式打开(window+R键),进入d盘,cd 进入刚刚创建的文件夹里面

cd WebSpider

5.mkdir FirstSpider (创建一个FirstSpider文件夹)

6.进入刚刚创建的文件夹里面 cd FirstSpider

7. npm init (初始化工程)

此时需要填写一些项目信息,你可以根据情况填写,当然也可以一路回车。 (图片里面显示的文件夹名和盘不正确,仅供参考,主要看图片信息,一路回车即可)

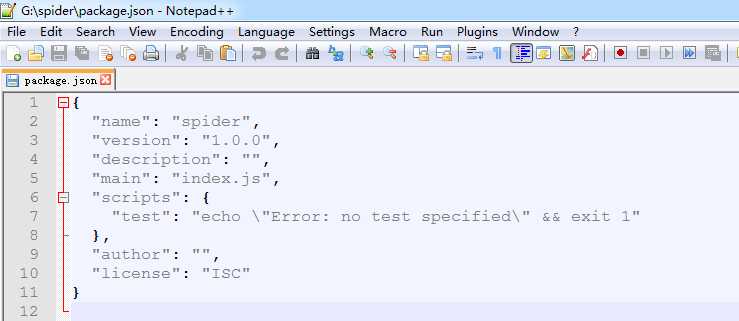

创建完项目后,会生成一个package.json的文件。该文件包含了项目的基本信息。

8.安装第三方包(后面程序会直接调用包的模块)

************** 在cmd中,cd进入cd FirstSpider文件夹,然后执行命令: npm install cheerio

*************安装完cheerio包后,继续安装request包:npm install request

说明: 这里安装cheerio包,和request包。request 用于发起http请求,cheerio 用于将下载下来的dom进行分析和提取 你可以把它当做jQuery来用。

说明:由于http模块、fs模块都是内置的包,因此不需要额外添加。

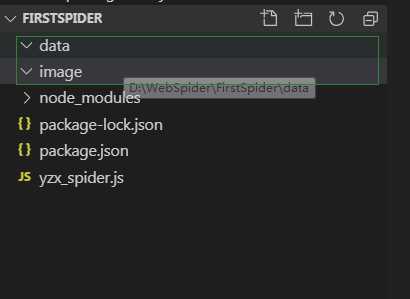

9.如果想要将爬取的数据和图片分类放好,那就事先建立一个data和image文件夹准备着。(在FirstSpider文件夹下新建。)

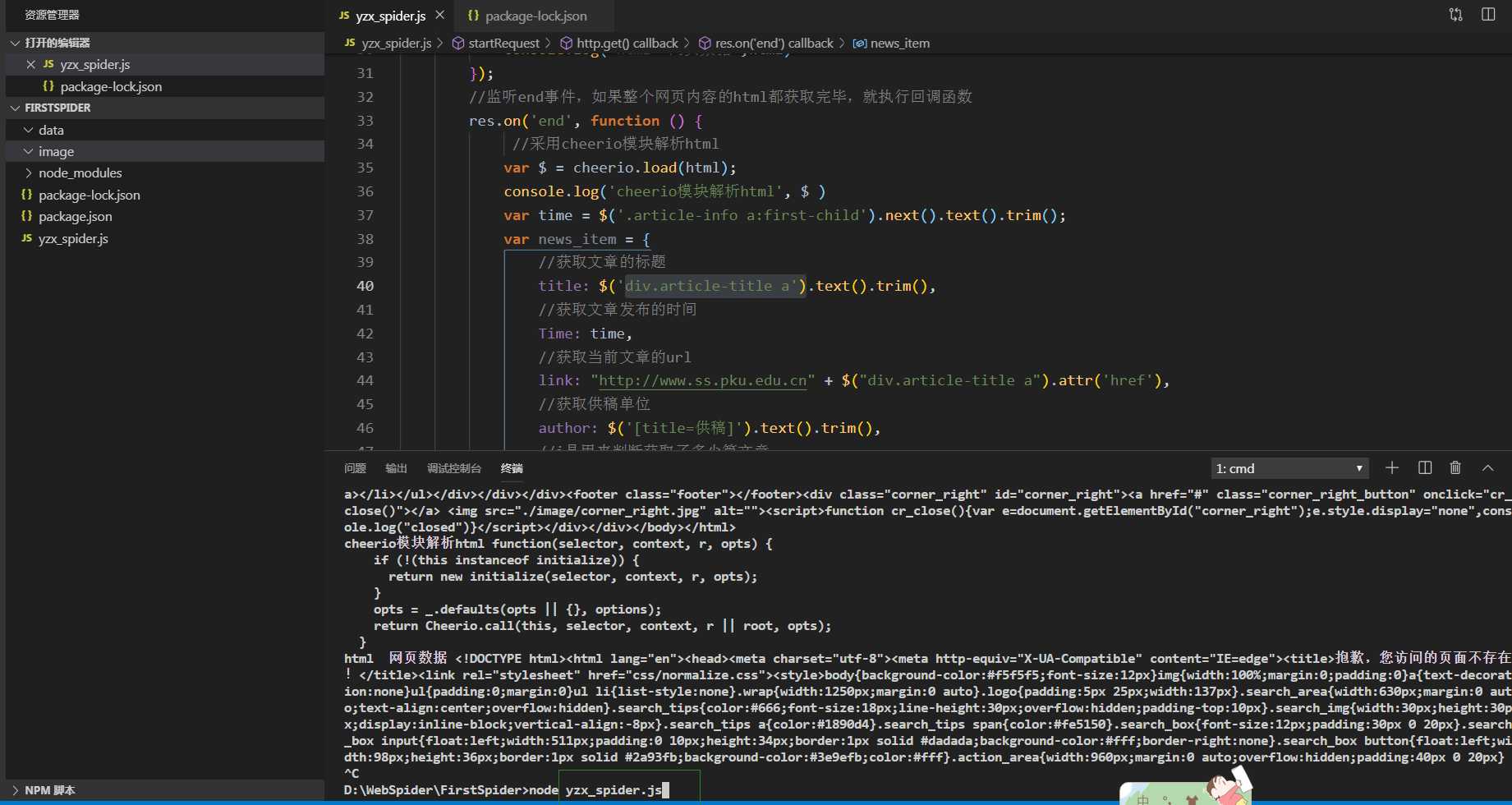

10.打开yzx_spider.js,ctrl+c” + “ctrl+v”

var http = require(‘http‘);

var fs = require(‘fs‘);

var cheerio = require(‘cheerio‘);

var request = require(‘request‘);

var i = 0;

var url = "http://www.ss.pku.edu.cn/index.php/newscenter/news/2391";

//初始url

function fetchPage(x) { //封装了一层函数

startRequest(x);

}

function startRequest(x) {

//采用http模块向服务器发起一次get请求

http.get(x, function (res) {

var html = ‘‘; //用来存储请求网页的整个html内容

var titles = [];

res.setEncoding(‘utf-8‘); //防止中文乱码

//监听data事件,每次取一块数据

res.on(‘data‘, function (chunk) {

html += chunk;

});

//监听end事件,如果整个网页内容的html都获取完毕,就执行回调函数

res.on(‘end‘, function () {

var $ = cheerio.load(html); //采用cheerio模块解析html

var time = $(‘.article-info a:first-child‘).next().text().trim();

var news_item = {

//获取文章的标题

title: $(‘div.article-title a‘).text().trim(),

//获取文章发布的时间

Time: time,

//获取当前文章的url

link: "http://www.ss.pku.edu.cn" + $("div.article-title a").attr(‘href‘),

//获取供稿单位

author: $(‘[title=供稿]‘).text().trim(),

//i是用来判断获取了多少篇文章

i: i = i + 1,

};

console.log(news_item); //打印新闻信息

var news_title = $(‘div.article-title a‘).text().trim();

savedContent($,news_title); //存储每篇文章的内容及文章标题

savedImg($,news_title); //存储每篇文章的图片及图片标题

//下一篇文章的url

var nextLink="http://www.ss.pku.edu.cn" + $("li.next a").attr(‘href‘);

str1 = nextLink.split(‘-‘); //去除掉url后面的中文

str = encodeURI(str1[0]);

//这是亮点之一,通过控制I,可以控制爬取多少篇文章.

if (i <= 500) {

fetchPage(str);

}

});

}).on(‘error‘, function (err) {

console.log(err);

});

}

//该函数的作用:在本地存储所爬取的新闻内容资源

function savedContent($, news_title) {

$(‘.article-content p‘).each(function (index, item) {

var x = $(this).text();

var y = x.substring(0, 2).trim();

if (y == ‘‘) {

x = x + ‘\n‘;

//将新闻文本内容一段一段添加到/data文件夹下,并用新闻的标题来命名文件

fs.appendFile(‘./data/‘ + news_title + ‘.txt‘, x, ‘utf-8‘, function (err) {

if (err) {

console.log(err);

}

});

}

})

}

//该函数的作用:在本地存储所爬取到的图片资源

function savedImg($,news_title) {

$(‘.article-content img‘).each(function (index, item) {

var img_title = $(this).parent().next().text().trim(); //获取图片的标题

if(img_title.length>35||img_title==""){

img_title="Null";}

var img_filename = img_title + ‘.jpg‘;

var img_src = ‘http://www.ss.pku.edu.cn‘ + $(this).attr(‘src‘); //获取图片的url

//采用request模块,向服务器发起一次请求,获取图片资源

request.head(img_src,function(err,res,body){

if(err){

console.log(err);

}

});

request(img_src).pipe(fs.createWriteStream(‘./image/‘+news_title + ‘---‘ + img_filename)); //通过流的方式,把图片写到本地/image目录下,并用新闻的标题和图片的标题作为图片的名称。

})

}

fetchPage(url); //主程序开始运行

11. cd 到你创建工程文件夹yzx_homework下,然后 node yzx_spider.js

用node.js从零开始去写一个简单的爬虫(借鉴别人的,自己写了一遍,没毛病)

原文:https://www.cnblogs.com/hemei1212/p/11660463.html