如果没有安装hadoop,请参照本人前一篇博客:https://www.cnblogs.com/gambler/p/11864596.html

I、下载并解压spark

#下载spark wget --no-cookies --no-check-certificate http://apache.claz.org/spark/spark-2.4.4/spark-2.4.4-bin-hadoop2.7.tgz #解压spark tar xzf spark-2.4.4-bin-hadoop2.7.tgz

#移动到hadoop文件夹中

mv spark-2.4.4-bin-hadoop2.7 /usr/local/hadoop/

II、配置系统环境

#编辑配置文件 vim /etc/profile #添加下面两行 export SPARK_HOME=/usr/local/hadoop/spark-2.4.4-bin-hadoop2.7 export PATH=/data/hadoop/spark/bin:$PATH

III、修改配置文件

#进入conf目录中 cd /usr/local/hadoop/spark-2.4.4-bin-hadoop2.7/conf #先从提供的模板中复制slaves和spark-env.sh文件 cp slaves.template slaves cp spark-env.sh.template spark-env.sh #编辑slaves文件 (删除原有的内容,添加节点) servera serverb #编辑spark-env.sh vim spark-env.sh #添加下面内容 export SPARK_HOME=/usr/local/hadoop/spark-2.4.4-bin-hadoop2.7 export JAVA_HOME=/usr/local/java/jdk1.8.0_141 export HADOOP_HOME=/usr/local/hadoop/hadoop-2.7.7 export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export SPARK_LIBARY_PATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib:$HADOOP_HOME/lib/native export SPAR_MASTER_PORT=7077 export SPARK_MASTER_HOST=servera

#最后别忘记source一下

source spark-env.sh

将spark及相关复制到其他节点

IV、启动spark

#因为hadoop和spark均有start—all.sh,所以进入spark目录启动 cd /usr/local/hadoop/spark-2.4.4-bin-hadoop2.7/sbin/

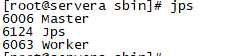

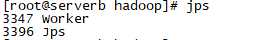

#启动spark ./start-all.sh #使用jps查看一下进程

jps

如果分别出现

表示spark安装成功

搭建hadoop+spark+hive环境(centos极速安装和配置spark)

原文:https://www.cnblogs.com/gambler/p/11867579.html