| 主机名 | 角色 | ip |

|---|---|---|

| hdss7-11.host.com | zk1.od.com(Test环境) | 10.4.7.11 |

| hdss7-12.host.com | zk2.od.com(Prod环境) | 10.4.7.12 |

hdss7-11和hdss7-12上拆分成两个单独的zookeeper,不组成集群

[root@hdss7-11 bin]# ./zkServer.sh stop

[root@hdss7-12 bin]# ./zkServer.sh stop

[root@hdss7-11 zookeeper]# tree /data/zookeeper /删除data和logs下所有文件

.

├── data

└── logs

2 directories, 0 files

[root@hdss7-12 zookeeper]# tree /data/zookeeper /删除data和logs下所有文件

.

├── data

└── logs

2 directories, 0 files

[root@hdss7-11 bin]# vi /opt/zookeeper/conf/zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/data/zookeeper/data

dataLogDir=/data/zookeeper/logs

clientPort=2181

[root@hdss7-12 bin]# vi /opt/zookeeper/conf/zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/data/zookeeper/data

dataLogDir=/data/zookeeper/logs

clientPort=2181

[root@hdss7-11 bin]# ./zkServer.sh start

[root@hdss7-12 bin]# ./zkServer.sh start

[root@hdss7-11 bin]# ./zkServer.sh status

Mode: standalone

[root@hdss7-12 bin]# ./zkServer.sh status

Mode: standalone在运维主机hdss7-200上

[root@hdss7-200 dubbo-monitor]# pwd

/data/k8s-yaml/dubbo-monitor

[root@hdss7-200 dubbo-monitor]# vi cm.yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: dubbo-monitor-cm

namespace: infra

data:

dubbo.properties: |

dubbo.container=log4j,spring,registry,jetty

dubbo.application.name=simple-monitor

dubbo.application.owner=OldboyEdu

dubbo.registry.address=zookeeper://zk1.od.com:2181

dubbo.protocol.port=20880

dubbo.jetty.port=8080

dubbo.jetty.directory=/dubbo-monitor-simple/monitor

dubbo.charts.directory=/dubbo-monitor-simple/charts

dubbo.statistics.directory=/dubbo-monitor-simple/statistics

dubbo.log4j.file=/dubbo-monitor-simple/logs/dubbo-monitor.log

dubbo.log4j.level=WARN

[root@hdss7-200 dubbo-monitor]# vi dp2.yaml

kind: Deployment

apiVersion: extensions/v1beta1

metadata:

name: dubbo-monitor

namespace: infra

labels:

name: dubbo-monitor

spec:

replicas: 1

selector:

matchLabels:

name: dubbo-monitor

template:

metadata:

labels:

app: dubbo-monitor

name: dubbo-monitor

spec:

containers:

- name: dubbo-monitor

image: harbor.od.com/infra/dubbo-monitor:latest

ports:

- containerPort: 8080

protocol: TCP

- containerPort: 20880

protocol: TCP

imagePullPolicy: IfNotPresent

volumeMounts:

- name: configmap-volume

mountPath: /dubbo-monitor-simple/conf

volumes:

- name: configmap-volume

configMap:

name: dubbo-monitor-cm

imagePullSecrets:

- name: harbor

restartPolicy: Always

terminationGracePeriodSeconds: 30

securityContext:

runAsUser: 0

schedulerName: default-scheduler

strategy:

type: RollingUpdate

rollingUpdate:

maxUnavailable: 1

maxSurge: 1

revisionHistoryLimit: 7

progressDeadlineSeconds: 600任意运算节点上,这里为hdss7-21

[root@hdss7-21 bin]# kubectl apply -f http://k8s-yaml.od.com/dubbo-monitor/cm.yaml

configmap/dubbo-monitor-cm created

[root@hdss7-21 bin]# kubectl apply -f http://k8s-yaml.od.com/dubbo-monitor/dp2.yaml

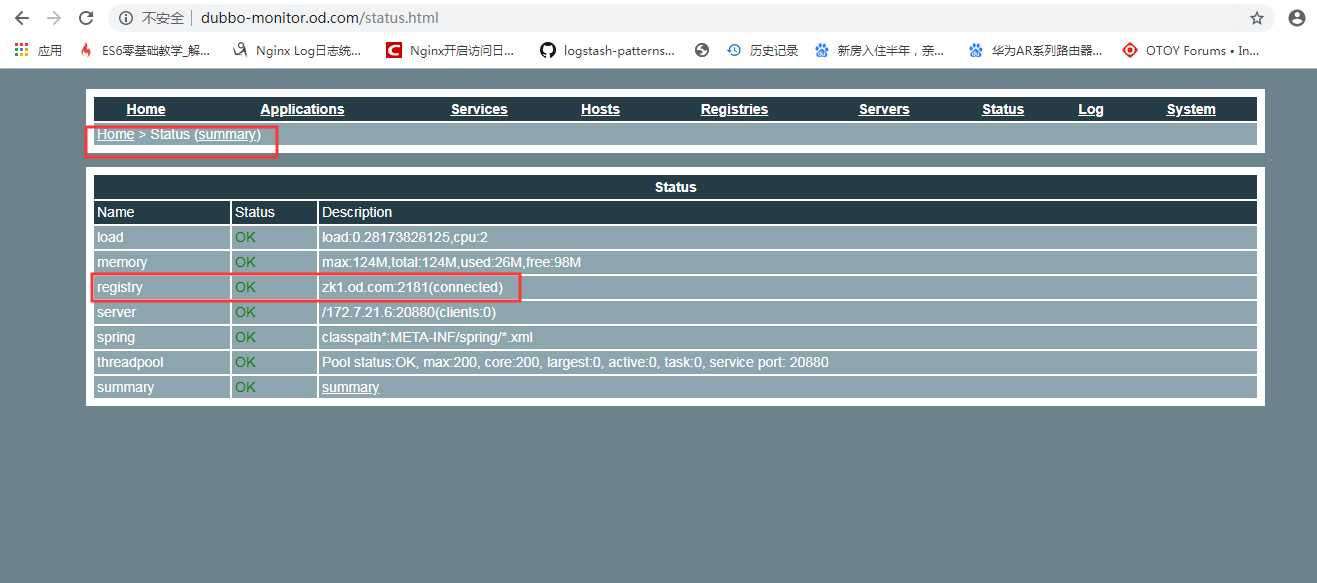

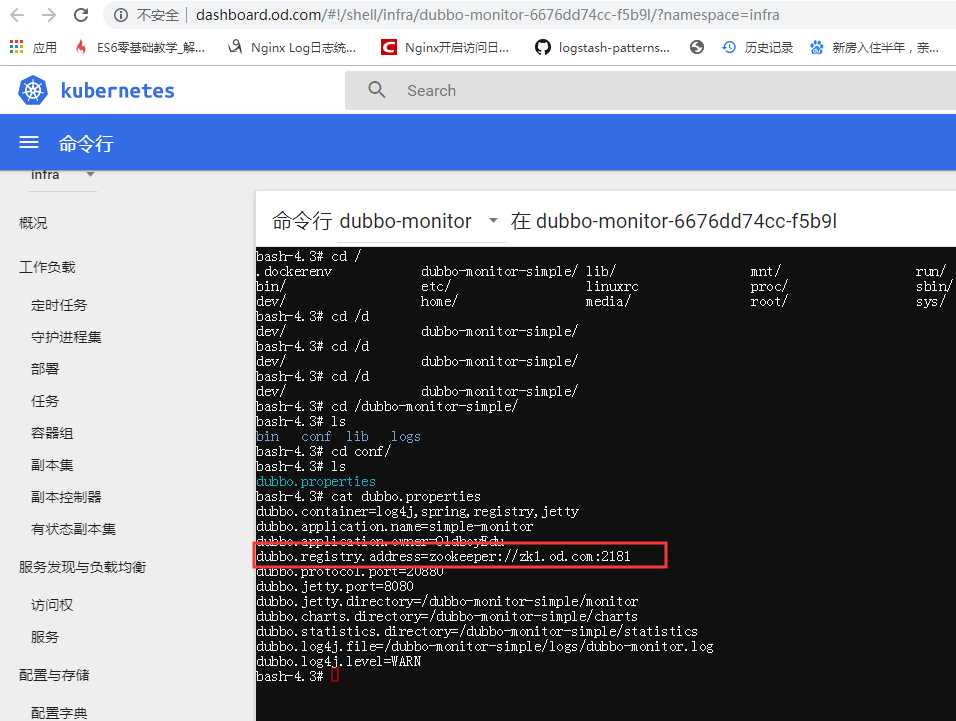

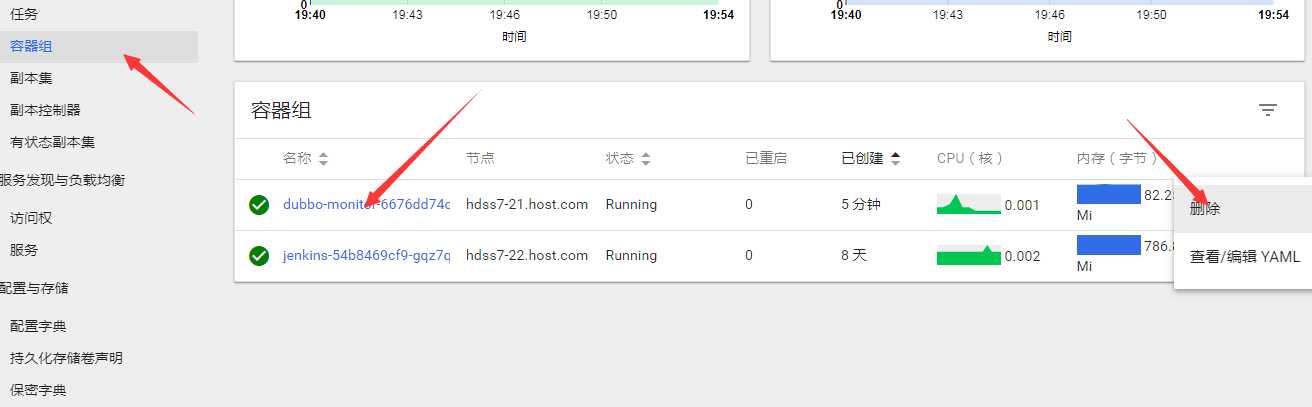

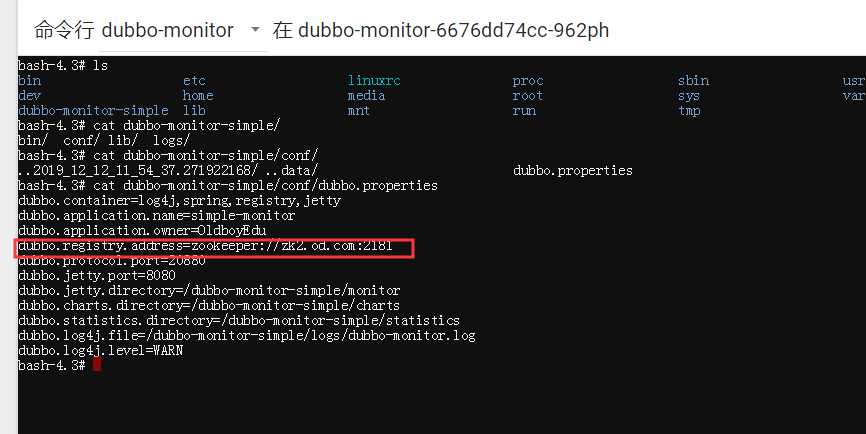

deployment.extensions/dubbo-monitor configured可以看到registry现在是zk1.od.com

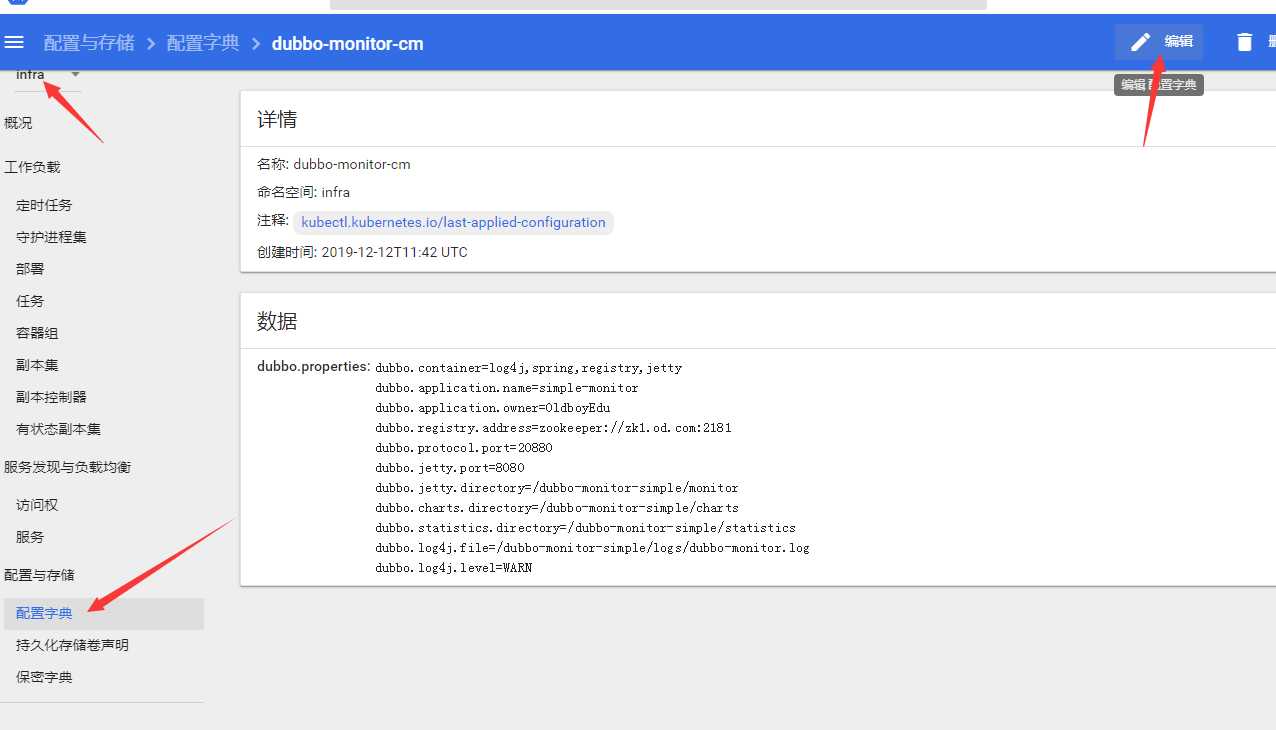

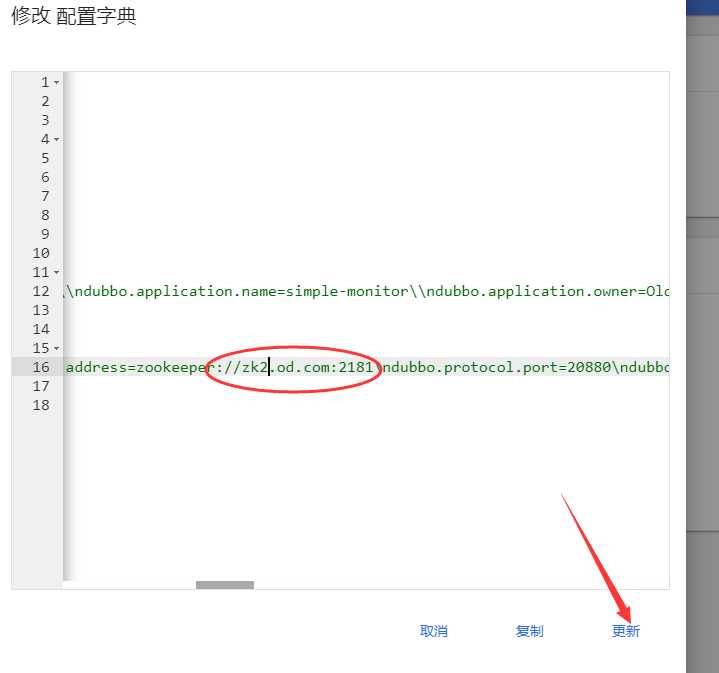

修改configmap并重启pod

step1:编辑configmap

step2:修改 dubbo.registry.address=zookeeper://zk2.od.com:2181

step3:重启pod

访问dubbo-monitor.od.com

dashboard里进pod查看:

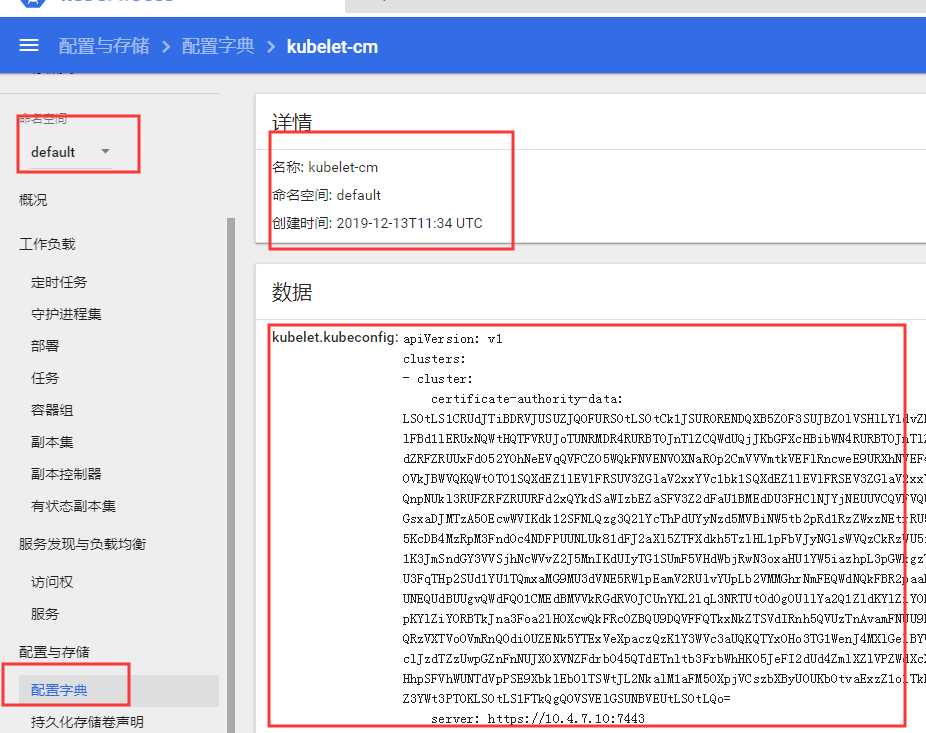

//创建

[root@hdss7-21 ~]# kubectl create cm kubelet-cm --from-file=/opt/kubernetes/server/bin/conf/kubelet.kubeconfig -n default

configmap/kubelet-cm created

//查看

[root@hdss7-21 ~]# kubectl get cm kubelet-cm -n default

NAME DATA AGE

kubelet-cm 1 56s

[root@hdss7-21 ~]# kubectl get cm kubelet-cm -o yaml -n default

apiVersion: v1

data:

kubelet.kubeconfig: |

apiVersion: v1

clusters:

- cluster:

。。。略dashboard查看:

-?启动flanel网络的时候,没有读取到?subnet.env的环境变量?FLANNEL_SUBNET

原文:https://www.cnblogs.com/wangchaolinux/p/12037813.html