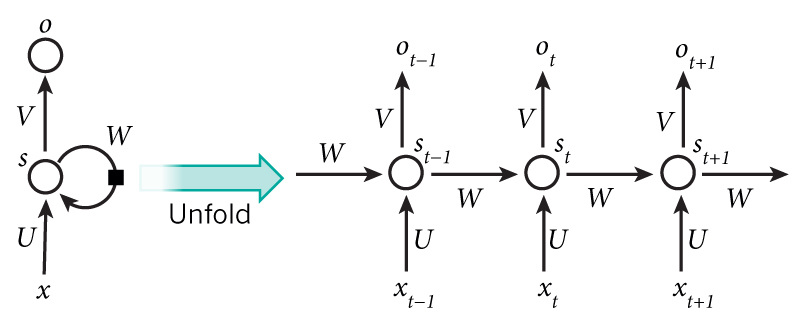

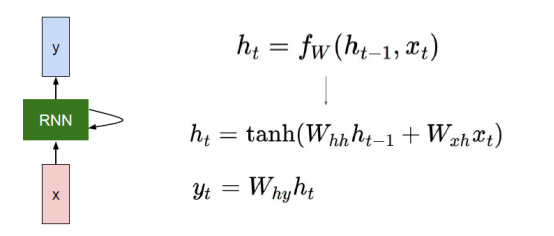

输入单元(Input units)的输入集标记为\(\{x_0,x_1,...,x_t,x_{t+1},...\}\),而输出单元(Output units)的输出集则被标记为\(\{y_0,y_1,...,y_t,y_{t+1},...\}\),隐藏单元(Hidden units)的输出集标记为\(\{h_0,h_1,...,h_t,h_{t+1},...\}\):

对前向传播过程的详细描述见:详细展示RNN的网络结构

RNN反向传播所用的算法被称为:BPTT(BackPropagation Through Time),推导过程可参考:

实现方面可参考:

>>> rnn = nn.RNN(10, 20, 2)

>>> input = torch.randn(5, 3, 10)

>>> h0 = torch.randn(2, 3, 20)

>>> output, hn = rnn(input, h0)参考:

原文:https://www.cnblogs.com/lokvahkoor/p/12245347.html