????今天主要是利用Autogluon框架完成图像分类任务。下面主要总结其中涉及的一些要点。

ResNet简介:

????ResNet(Residual Networks 残差网络),2015年何凯明团队提出,在2015年的ILSVRC(ImageNet)的classification、detection、localization以及COCO的detection、segmentation均第一。ResNet性能好很多,检测和分割任务的特征表达网络结构等,一般都会用它来做改造,识别性能和训练速度都有提升。最高152层。论文连接作者源代码

????今天主要用到?ResNet50_v1b?和?ResNet18_v1b?两个模型,网络层数分别为50层、18层。

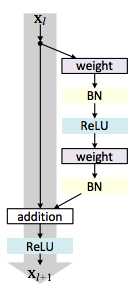

图1 ResNet_V1版本网络结构

ResNet设计思想:

残差比较小,残差学习会更容易,因为有恒等映射性能至少不会下降,梯度不会消失;残差映射还会学习新的特征,性能更好。

ResNet网络结构:

????设计了18、34、50、101、152层,用的都是11和33的小卷积核。普通电脑跑34就可以了,Cifar 100能到75%左右。

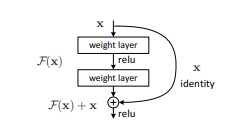

ResNet构成快

????在残差块中,当输入为 x 时其原来学习到的原始学习特征是H(x)=F(x)+x,但现在我们希望其可以学习到残差F(x)=H(x)-x,这是因为残差学习相比原始特征的直接学习更小更容易。

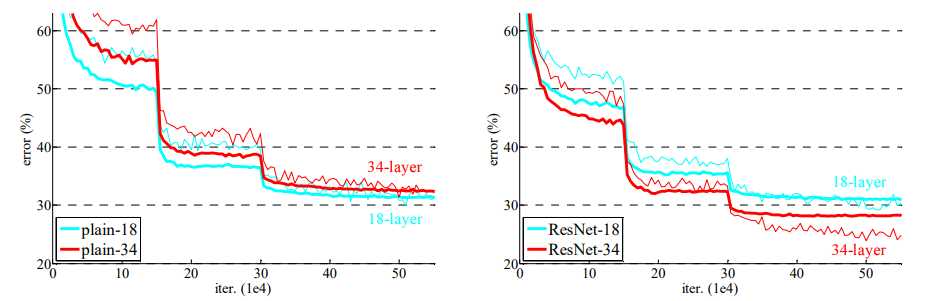

残差作用的验证

ResNet的实验:

????Minist数据集图像比较小,用VGG可能就跑不了,图像经过多个卷积和pooling后可能就变成1*1了,再做pooling就会报错。可以把原始图像resize到更大尺寸来做。

Cifar 10数据集,10个类别的分类,要生成lmdb格式,也可以直接用ImageData数据层直接读取图片。普通电脑一般跑不了50 101 152。

注意训练时一般对图像有个减均值的操作,图像在每个通道上的像素[0,255]范围减去128或均值。有时还把像素值变大0~1之间。这样收敛更快,性能提升不太大。

????详细任务官方指南

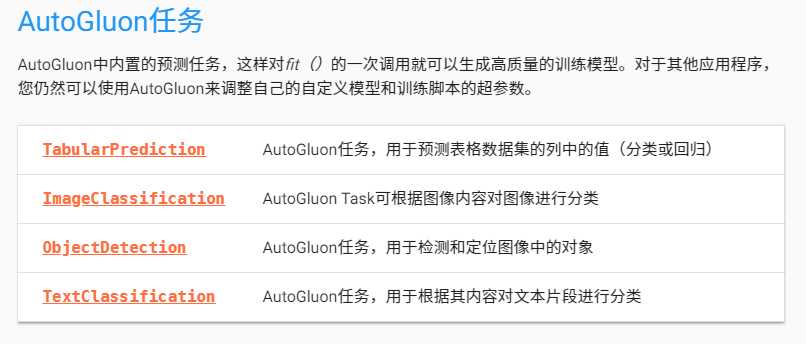

Autogluon任务

????配置好服务器后,运行起来流畅无比。整体说使用Autogluon完成实验整体比较容易,但弄懂背后相关的步骤原理还是比较费劲。

原文:https://www.cnblogs.com/somedayLi/p/12271176.html