------------恢复内容开始------------

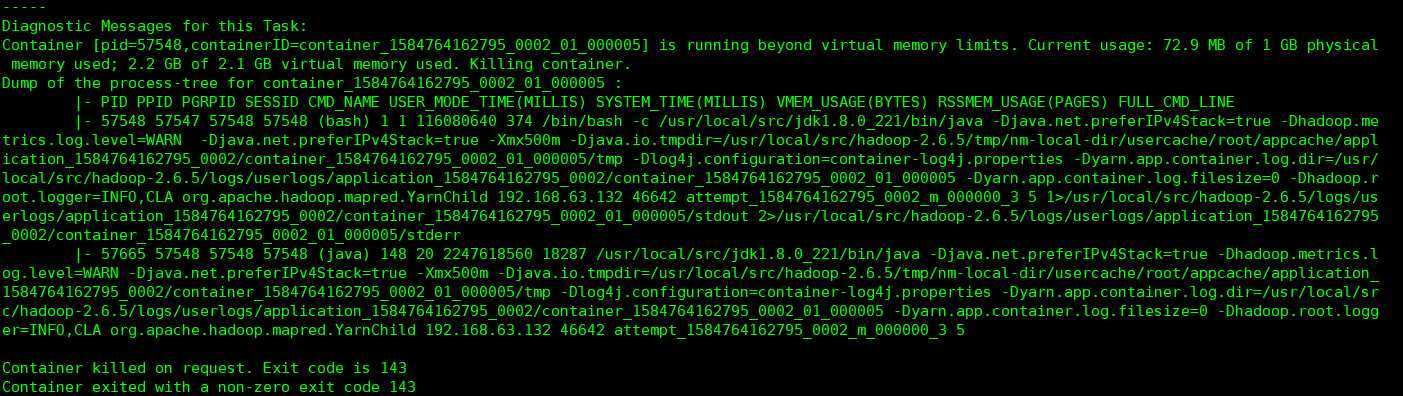

1.在练习hive跑任务过程出现如下错误:

2.根据报错信息:

hadoop运行时使用的虚拟内存不足,从机上运行的Container想用更多的虚拟内存,而被NodeManager kill ,致使任务失败

3.解决方法:

进入hadoop安装目录/etc/hadoop/

3.1.在yarn-site.xml文件中添加如下配置:

<!--当运行时所需内存超过虚拟内存限制是否强制关闭container-->

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

<description>Whether virtual memory limits will be enforced for containers</description>

</property>

<!--设置容器的内存限制时虚拟内存与物理内存之间的比率-->

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>4</value>

<description>Ratio between virtual memory to physical memory when setting memory limits for containers</description>

</property>

3.2.在mapred-site.xml文件中添加如下配置:修改map和reduce任务时内存配置(value需要根据自己的虚拟机内存及应用修改)

<property>

<name>mapreduce.map.memory.mb</name>

<value>2048</value>

</property>

<property>

<name>mapreduce.reduce.memory.mb</name>

<value>2048</value>

</property>

------------恢复内容结束------------

running beyond virtual memory limits 错误

原文:https://www.cnblogs.com/motivated-qinglin/p/12540593.html