通俗理解:爬虫就是一个模拟人类请求网站行为的程序。可以自动请求网页,并将数据抓取下来,然后使用一定的规则提取有价值的数据。

百度 谷歌 雅虎...搜索引擎

特点:关键字获取既定的目标,覆盖率很大

特点:到互联网上有选择有目的去抓取特定的目标和相关的主题内容。

特点:只采取增量式的更新或者是只爬取新产生或者是已经发生变化的网页。

| 简称 | 全称 | 描述 | 端口 |

|---|---|---|---|

| HTTP | HyperText Transfer Protocol | 超文本传输协议 | 80 |

| HTTPS | Hyper Text Transfer Protocol over SecureSocket Layer | HTTP下加入了SSL层 | 443 |

我们在浏览器的地址中输入一个URL地址并按回车之后,浏览器会向HTTP服务器发送HTTP请求。网站服务器接收到这个请求后进行处理和解析,然后返回对应的响应,接着传回给浏览器。响应里包含了页面的源代码等,浏览器再对其进行解析,并将网页呈现了出现。HTTP请求主要分为get和post两种方法。

URL是Uniform Resource Locator的简写,统一资源定位符。

一个URL有以下几部分组成:

schema://host:port/path/?query-string=xxx#anchor

www.baidu.com/s?wd=python,后面的wd=python就是查询字符串在http协议中,定义了8种请求方法,此处只是介绍常用的请求方法,分别是get和post。

get请求

一般情况下,只从服务器获取数据下来,并不会对服务器资源产生任何影响的时候会使用get请求

post请求

向服务器发送数据(登录)、上传文件等。会对服务器资源产生影响的时候回使用post请求。

以上是在网站开发中常用的两种方法。并且一般情况下都会遵守使用的原则。但是由的网站和服务器为了做反爬虫机制,也经常会不安常理出牌。

在http协议中,向服务器发送一个请求,数据分为三部分,第一个是把数据放在url中,第二个是把数据放在body中(在post请求中),第三个就是把数据放在head中。此处只介绍常见的请求头:

| 状态码 | 说明 | 详情 |

|---|---|---|

| 200 | 成功 | 服务器已经成功处理了请求 |

| 301 | 永久重定向 | 比如在访问了www.jingdong.com,被重定向到了www.jd.com |

| 302 | 临时重定向 | 比如在访问一个需要登录的页面的时候,而此时没有登录,那么就会重定向到登录页面 |

| 400 | 请求的url在服务器上找不到 | url请求错误 |

| 403 | 拒绝访问 | 服务器拒绝此请求 |

| 500 | 服务器内部错误 | 服务器遇到错误,无法完成请求 |

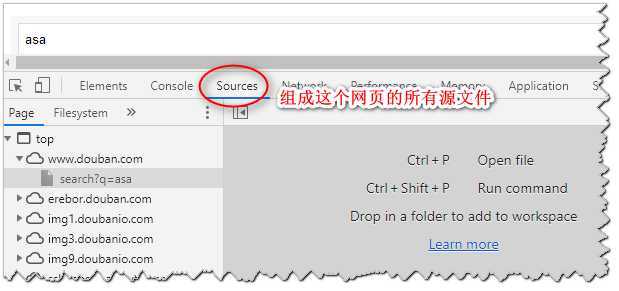

通过右键-->>检查 或者F12都可以打开谷歌浏览器的开发者工具。下图说明:

原文:https://www.cnblogs.com/OliverQin/p/12563020.html