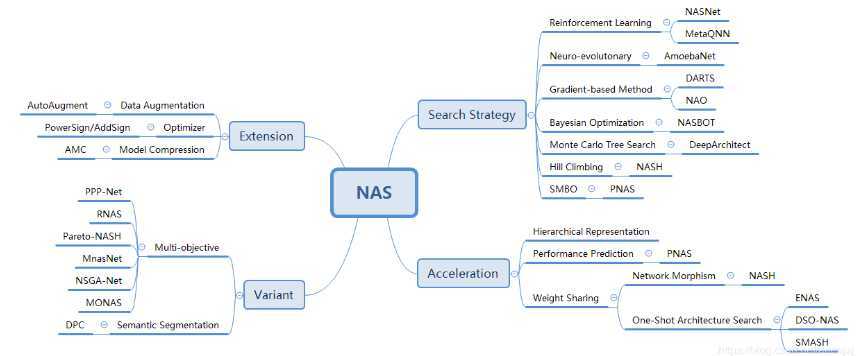

神经架构搜索(Neural Architecture Search,简称 NAS)的核心思想是使用搜索算法来发现用于解决我们的问题所需要的神经网络结构。

有些论文的结果很难重现原因之一就是获得最优超参值往往需要花很大的力气。超参数的自动搜索优化是一个古老的话题了。

对于深度学习来说,超参数(Hyperparameter)主要有两类:

对于训练参数的自动调优属于超参数优化(Hyperparameter optimization,简称HO);而定义网络结构的参数进行自动调优一般称为网络架构搜索(Neural Architecture Search,简称NAS)。下面对两者进行概述:

参考博客:https://blog.csdn.net/jinzhuojun/article/details/84698471

原文:https://www.cnblogs.com/somedayLi/p/12629508.html