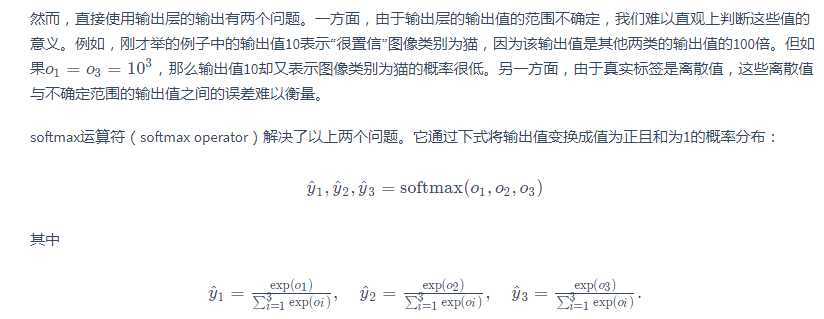

前几节介绍的线性回归模型适用于输出为连续值的情景。在另一类情景中,模型输出可以是一个像图像类别这样的离散值。对于这样的离散值预测问题,我们可以使用诸如softmax回归在内的分类模型。和线性回归不同,softmax回归的输出单元从一个变成了多个,且引入了softmax运算使输出更适合离散值的预测和训练。本节以softmax回归模型为例,介绍神经网络中的分类模型

【这个是针对离散的 之前的输出是一个 现在是多个了的分类模型】

【这里可以看出动物的类别 在乘以特征的个数就得到 了最多的w个数

权重个数】

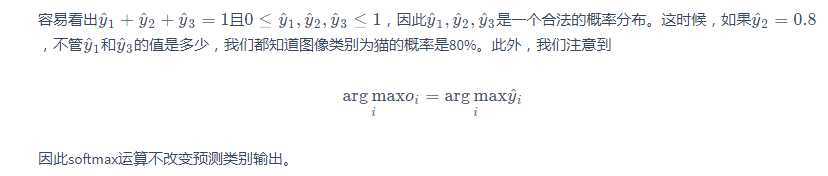

一个的指数

除以所有的指数和

得到最大的概率

【】这里的y是经过softmax后的o

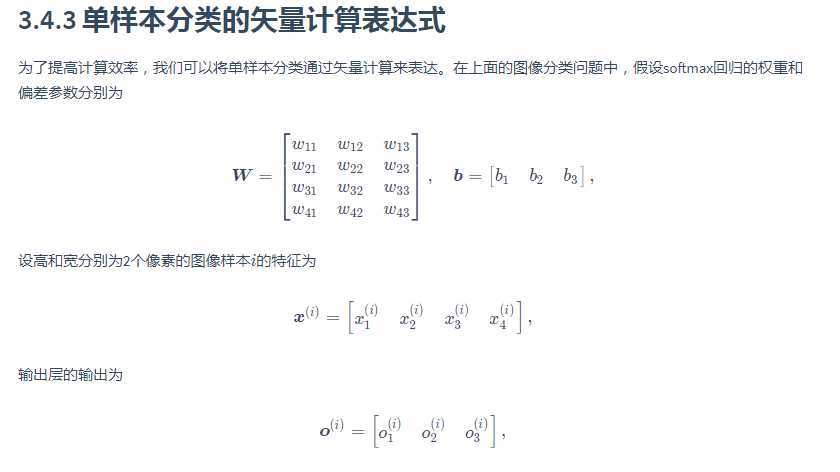

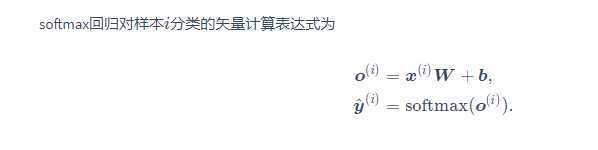

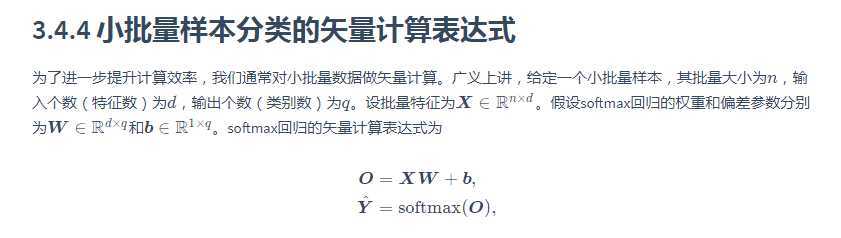

注意x按行排

w按列排

【这里采取的是XW而不是WX 正常情况下不应是WX吗 这样的矩阵w是输出单元数*输入的单元数的维度

而且这里的b是行排 不是列排 这样会导致y也行排 正常情况是列排的话 就为WX的计算 而不是XW 行排的话为XW也就合理了】

【】均方差会因为彼此的差距变大了

导致loss会很大

所以这个loss就不符合了

所以要换一个loss函数】】

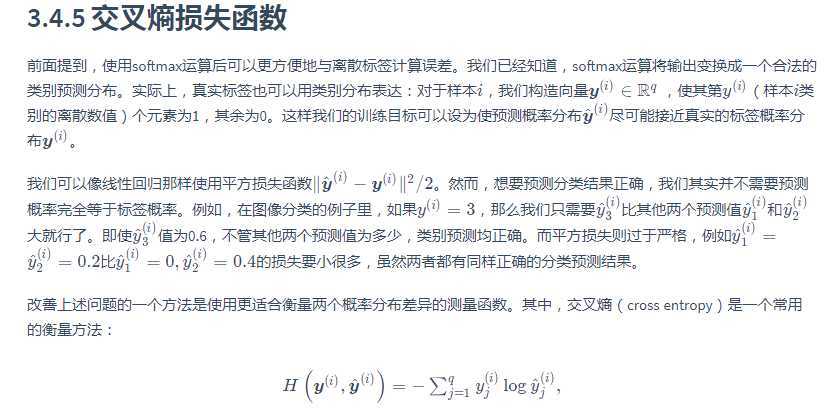

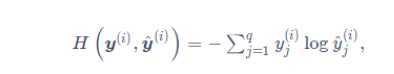

【】这个 y i j的理解方法是这样的

这里的

可以看出 y i是说第i个样本的所有j的值

然后j是指y i中的某一个量

所以

这个是算出每一个y中每一个y j被分类到的概率

】】

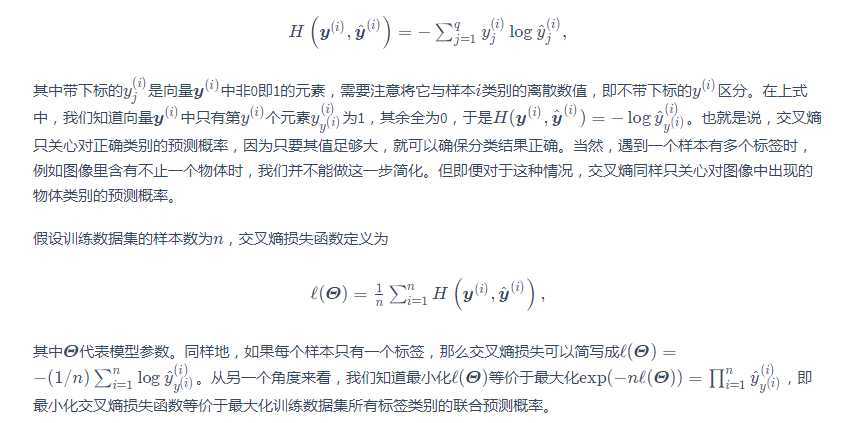

=========================

【这里是说只有一个标签的时候 所以会只有一个为1 其他都为0

所以才可以变为1 如果不止一个的话 是不为1 的

然后这里的j的下标 变成了y i 本人并不知道这可不可行

但是好像是可行的 前面的y i是向量

后面的y i是标量 有点像是在说向量中的一个小标量情况

可以认为这个小标量情况是适用于为1 的 其他是为0 的

所以这样的话 就可以认为是j = y i】

在训练好softmax回归模型后,给定任一样本特征,就可以预测每个输出类别的概率。通常,我们把预测概率最大的类别作为输出类别。如果它与真实类别(标签)一致,说明这次预测是正确的。在3.6节的实验中,我们将使用准确率(accuracy)来评价模型的表现。它等于正确预测数量与总预测数量之比。

原文:https://www.cnblogs.com/c2d3dmm/p/12819350.html