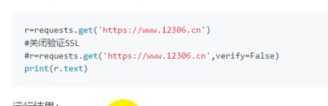

requests可以为https请求验证SSL证书,就像web浏览器一样,SSL验证默认是开启的,如果验证失败,会抛出SSLerror,如果不想验证,可以使用verify来关闭验证SSL。

r= requests.get(‘https://baidu.com‘)

r=requests.get(‘https://baidu.com‘,verfy=false)

代理设置:

网络代理,特殊的网络服务,允许一个网络终端通过这个服务器和另一个网络中断进行非直接的代理。

代理服务器位于客户端和访问的互联网之间,服务器收到 客户端的请求,然后代替客户端向目标网站发出请求。

有些接口,持续请求服务器会开启验证,或者封掉IP,所以需要设置代理来解决这个问题。

requests中需要用到proxies这个参数,在爬虫中需要用到代理。

例如:西刺免费代理。包括代理的地址,请求的类型。

首先设定一个代理网址:

proxies={‘http‘:’http://120.20.23.231‘‘

r=requests.get(baseurl+‘/get‘,proxies=proxies)

print(r.text)

回车后显示的就是代理的地址而不是真实的地址。

原文:https://www.cnblogs.com/super-lebron/p/12824485.html