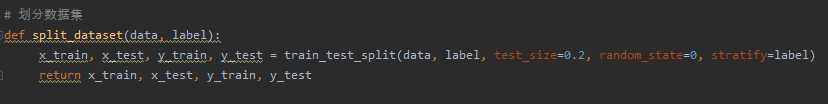

from sklearn.model_selection import train_test_split

x_train,x_test, y_train, y_test = train_test_split(data, target, test_size=0.2, random_state=0, stratify=y_train)

sklearn.feature_extraction.text.CountVectorizer

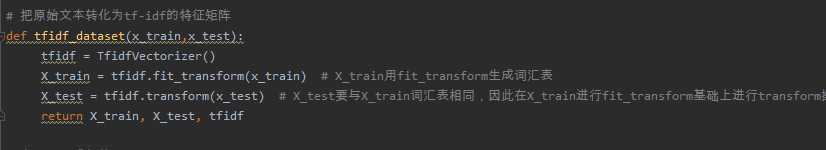

sklearn.feature_extraction.text.TfidfVectorizer

from sklearn.feature_extraction.text import TfidfVectorizer

tfidf2 = TfidfVectorizer()

观察邮件与向量的关系

向量还原为邮件

from sklearn.naive_bayes import GaussianNB

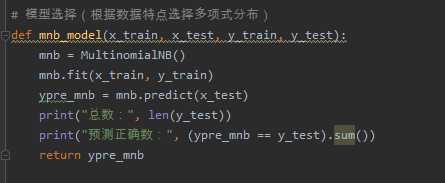

from sklearn.naive_bayes import MultinomialNB

说明为什么选择这个模型?

from sklearn.metrics import confusion_matrix

confusion_matrix = confusion_matrix(y_test, y_predict)

说明混淆矩阵的含义

from sklearn.metrics import classification_report

说明准确率、精确率、召回率、F值分别代表的意义

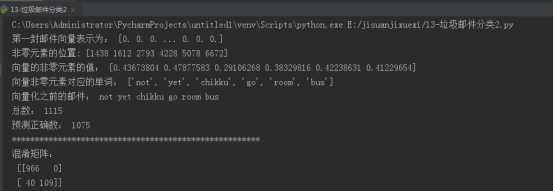

(1)混淆矩阵 confusion-matrix:

TP(True Positive):真实为0,预测为0

TN(True Negative):真实为1,预测为1

FN(False Negative):真实为0,预测为1

FP(False Positive):真实为1,预测为0

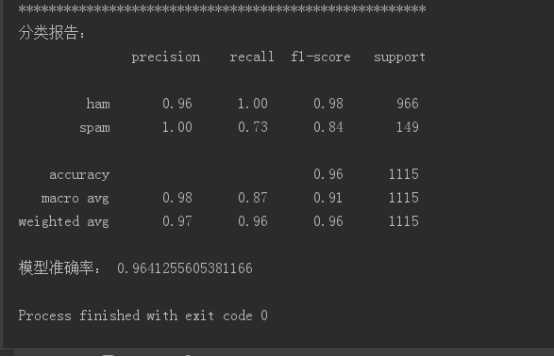

(2)准确率 accuracy:代表分类器对整个样本判断正确的比重。

(3)精确率 precision:指被分类器判断正例中的正样本的比重。

(4)召回率 recall:指被预测为正例的占总的正例的比重。

(5)F值:准确率和召回率的加权调和平均。

# 6、模型评价

def class_report(pre, y_test):

conf_matrix = confusion_matrix(y_test, pre)

print("=====================================================")

print("混淆矩阵:\n", conf_matrix)

c = classification_report(y_test, pre)

print("分类报告:\n", c)

print("模型准确率:", (conf_matrix[0][0] + conf_matrix[1][1]) / np.sum(conf_matrix))

如果用CountVectorizer进行文本特征生成,与TfidfVectorizer相比,效果如何?

CountVectorizer 与 TfidfVectorizer,这两个类都是特征数值计算的常见方法。对于每一个训练文本,CountVectorizer 只考虑每种词汇在该训练文本中出现的频率,而TfidfVectorizer 除了考量某一词汇在当前训练文本中出现的频率之外,同时关注包含这个词汇的其它训练文本数目的倒数。相比之下,训练文本的数量越多,TfidfVectorizer 这种特征量化方式就更有优势。

原文:https://www.cnblogs.com/yeli1629/p/12964725.html