CART(Classification and Regression Tree),中文名为分类回归树,顾名思义,这种算法既可以完成分类任务,又可以完成回归模型。是1984年由Breiman等四英国人提出的。

一、 特点:

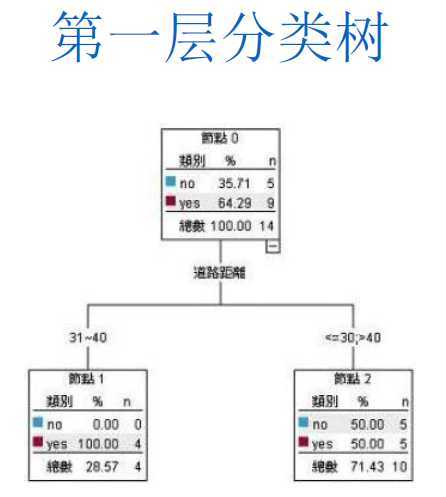

1.该算法是构建二元(Binary)分类回归树的算法,也即,,决策树在每次分叉的时候,只能分出两支数值;

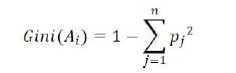

2.该算法在字段选择的时候,使用Gini Index 作为评估指标;

3.C5.0是通过计算预测错误率来剪枝,而CRAT是通过验证集的真实数值来剪枝。简单说,CRAT听过训练数据产生决策树,再用验证数据判断剪枝。对于训练数据来说,该决策树的叶节点能够达到100%分类正确,这时,决策树划分的太细了,会对噪声数据产生过度拟合,所以需要对决策树进行修剪。将验证数据带入训练数据生成的树,计算各叶节点的错误率。如果一个分支,叶节点的错误率之和大于该分支砍去所产生的错误率,则对此分支进行修剪。

4.分类树和回归树的区别在于叶节点,如果目标字段是类别型的,则建立的模型为分类树,如果目标字段是数值型的,则建立的模型就是回归树。

二、Gini Index (评估指标)

Gini Index 为0 ,则纯度最高,Gini Index的值越大纯度越低。Gini Index 的取值范围为:0-0.5.

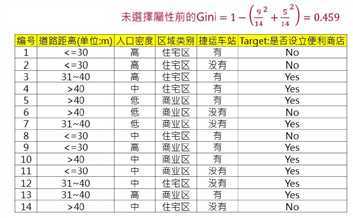

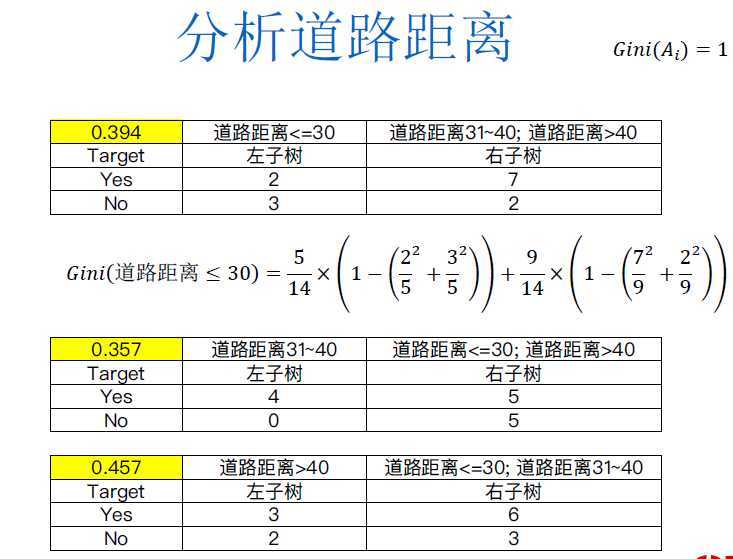

(图片来自:经管之家CDA)

(图片来自:经管之家CDA)

原文:https://www.cnblogs.com/liyuewdsgame/p/13235762.html