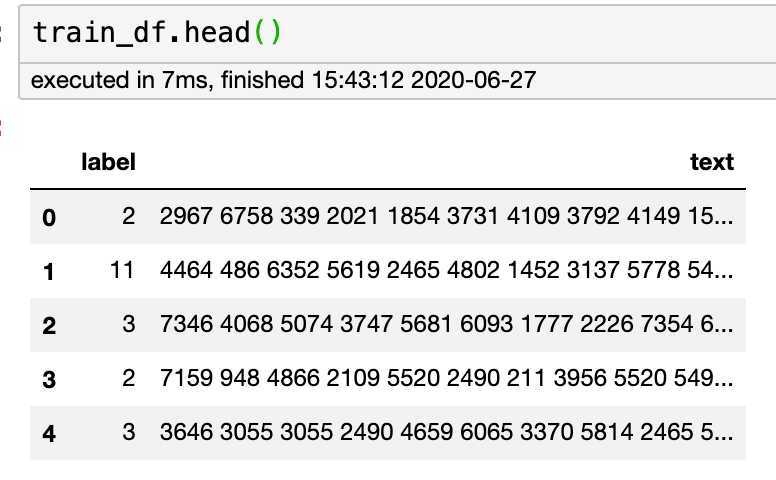

一、数据读取

import pandas as pd train_df = pd.read_csv(‘../input/train_set.csv‘, sep=‘\t‘, nrows=100)

二、数据分析

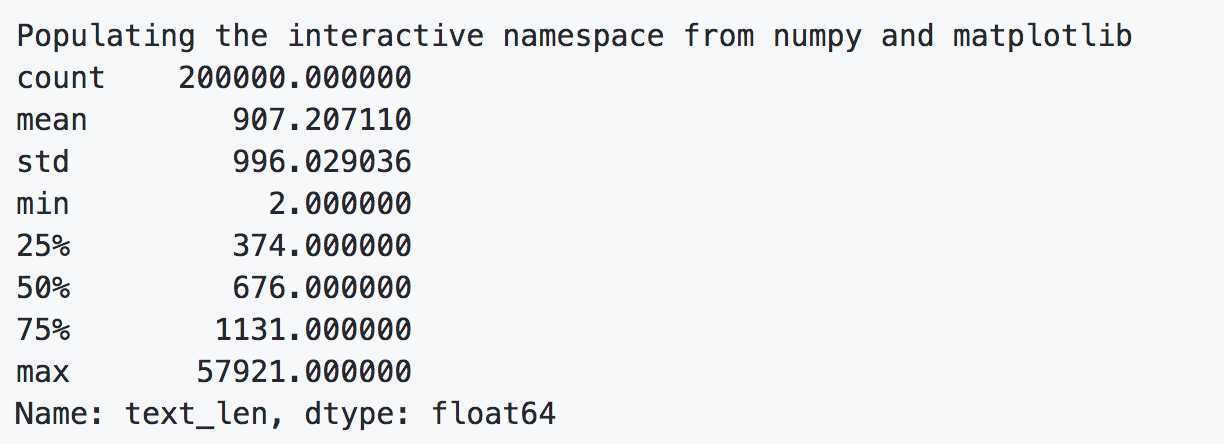

1、长度分析

%pylab inline train_df[‘text_len‘] = train_df[‘text‘].apply(lambda x: len(x.split(‘ ‘))) print(train_df[‘text_len‘].describe())

result:

2、字符分布统计

from collections import Counter

all_lines = ‘ ‘.join(list(train_df[‘text‘]))

word_count = Counter(all_lines.split(" "))

word_count = sorted(word_count.items(), key=lambda d:d[1], reverse = True)

print(len(word_count))

# 6869

print(word_count[0])

# (‘3750‘, 7482224)

print(word_count[-1])

# (‘3133‘, 1)

train_df[‘text_unique‘] = train_df[‘text‘].apply(lambda x: ‘ ‘.join(list(set(x.split(‘ ‘)))))

all_lines = ‘ ‘.join(list(train_df[‘text_unique‘]))

word_count = Counter(all_lines.split(" "))

word_count = sorted(word_count.items(), key=lambda d:int(d[1]), reverse = True)

print(word_count[0])

# (‘3750‘, 197997)

print(word_count[1])

# (‘900‘, 197653)

print(word_count[2])

# (‘648‘, 191975)

三、数据分析的结论

通过上述分析我们可以得出以下结论:

通过数据分析,我们还可以得出以下结论:

每个新闻平均字符个数较多,可能需要截断;

由于类别不均衡,会严重影响模型的精度;

四、结论

待更新。。。

原文:https://www.cnblogs.com/yuyunfei/p/13363469.html