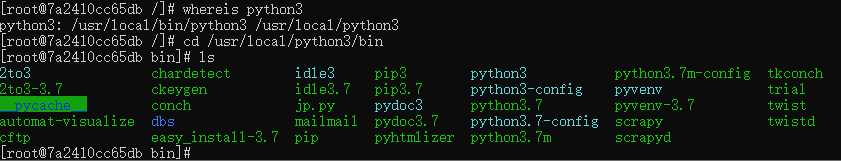

如果安装那么便配置软连接

ln -s /usr/local/python3/bin/scrapy /usr/bin/scrapy scrapy软连接

ln -s /usr/local/python3/bin/scrapyd /usr/bin/scrapyd scrapyd软连接

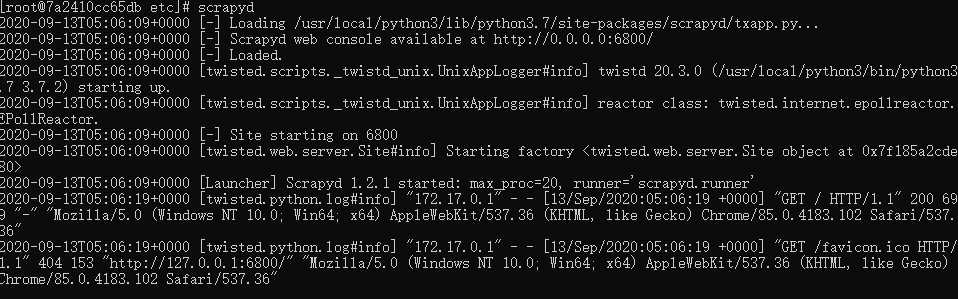

再次运行scrapyd

成功运行

[scrapyd] # 网页和Json服务监听的IP地址,默认为127.0.0.1 修改成 0.0.0.0可以远程访问 bind_address = 127.0.0.1 # 监听的端口,默认为6800 http_port = 6800 # 是否打开debug模式,默认为off debug = off # 每个CPU可启用的Scrapy 进程数,默认为4 max_proc_per_cpu = 4 # 可启用的最多进程数,默认为0.如果未设置或者设为0,则使用的最多进程数=CPU数量*max_proc_per_cpu max_proc = 0 # 项目eggs生成目录,默认为项目目录下eggs eggs_dir = eggs # 项目日志生成目录,默认为项目目录下logs,如果不想要生成日志,可以直接设置成空 logs_dir = logs items_dir = # 项目dbs生成目录,默认为项目目录下dbs dbs_dir = dbs # 爬取的items存储的文件夹(版本0.15.以上),默认为空,不存储。 items_dir = # 每个爬虫保持的完成任务数,默认为5.(版本0.15.以上,以前版本中为logs_to_keep) jobs_to_keep = 5 # 保持的完成任务进程数。默认为100.(版本0.14.以上) finished_to_keep = 100 # 轮训请求队列的时间间隔。默认为5s,可以为浮点数 poll_interval = 5.0 # 启动子进程的模块。可以使用自定义 runner = scrapyd.runner # 返回可用于twisted的application,可继承于Scrapyd添加和移除自己的组件和服务。 https://twistedmatrix.com/documents/current/core/howto/application.html查看更多 application = scrapyd.app.application launcher = scrapyd.launcher.Launcher # twisted的web资源,表示到scrapyd的接口。Scrapyd包含一个带有网站的界面,可以提供对应用程序的web资源的简单监视和访问。此设置必须提供twisted web资源的根类。 webroot = scrapyd.website.Root

原文:https://www.cnblogs.com/chenlizhi/p/13661141.html