爬虫是一段代码,用来模仿浏览器访问网站的过程,可以从服务器上获取数据。

按照常规的分类,爬虫可以分为下面几种

门户网站可以通过制定相应的策略或技术手段,防止爬虫程序

爬虫程序可以通过制定相关的策略或技术手段,啪姐门户网站中的反爬机制,从而获取数据

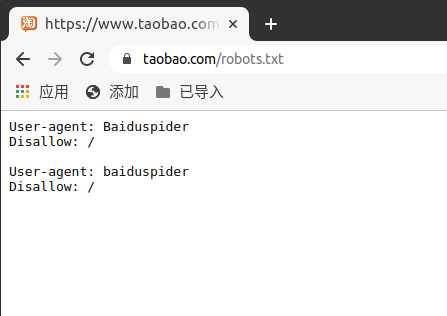

robots.txt是一个君子协议,用来规定网站中哪些数据可以被爬取哪些不可以。我们可以看一下淘宝的这个链接

但是这是个防君子不防小人的协议,并没有从实际的技术上做到反爬。

requests模块是python原生的一款基于网络请求的模块,功能强大,使用方便。使用的流程

原文:https://www.cnblogs.com/yinsedeyinse/p/13762964.html