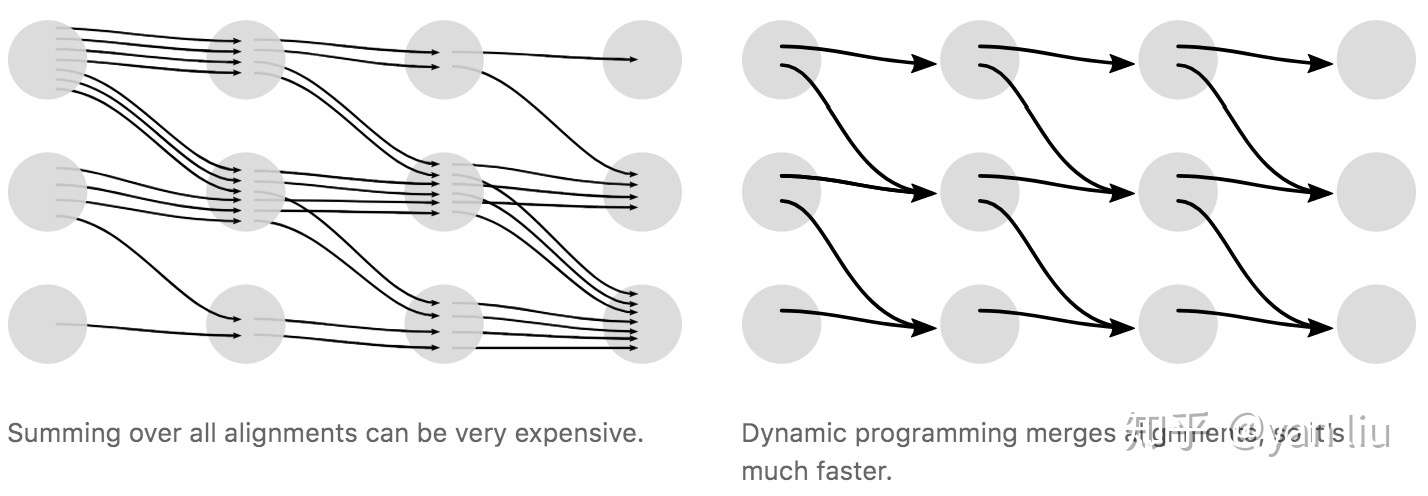

在CTC中采用了动态规划的思想来对查找路径进行剪枝,算法的核心思想是如果路径 和路径

在时间片

之前的输出均相等,我们就可以提前合并他们

现在,我们已经可以高效的计算损失函数,下一步的工作便是计算梯度用于训练模型。由于 的计算只涉及加法和乘法,因此其一定是可导函数,进而我们可以使用SGD优化模型。

求解最可能的输出有两种方案,一种是Greedy Search,第二种是beam search

本文主要参考自Hannun等人在distill.pub发表的文章(https://distill.pub/2017/ctc/),感谢Hunnun等人对CTC的梳理。

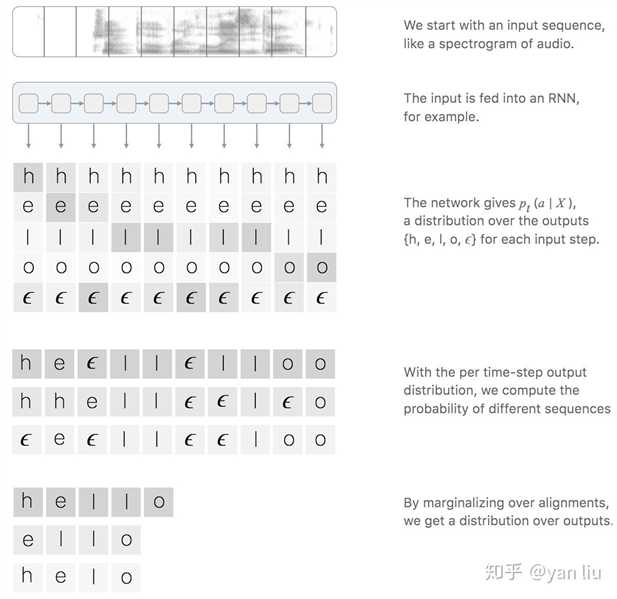

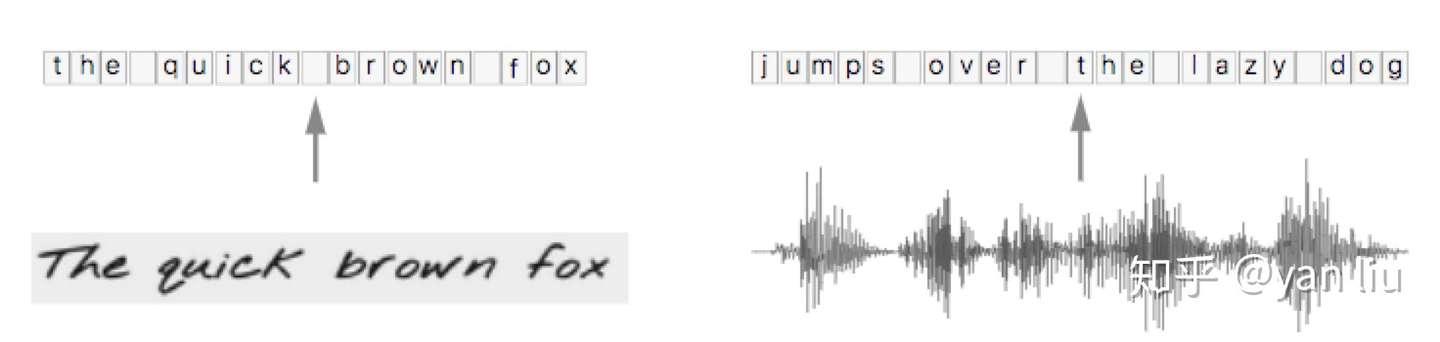

在语音识别中,我们的数据集是音频文件和其对应的文本,不幸的是,音频文件和文本很难再单词的单位上对齐。除了语言识别,在OCR,机器翻译中,都存在类似的Sequence to Sequence结构,同样也需要在预处理操作时进行对齐,但是这种对齐有时候是非常困难的。如果不使用对齐而直接训练模型时,由于人的语速的不同,或者字符间距离的不同,导致模型很难收敛。

CTC(Connectionist Temporal Classification)是一种避开输入与输出手动对齐的一种方式,是非常适合语音识别或者OCR这种应用的。

图1:CTC用于语音识别

图1:CTC用于语音识别

给定输入序列 以及对应的标签数据

,例如语音识别中的音频文件和文本文件。我们的工作是找到

到

的一个映射,这种对时序数据进行分类的算法叫做Temporal Classification。

对比传统的分类方法,时序分类有如下难点:

CTC提供了解决方案,对于一个给定的输入序列 ,CTC给出所有可能的

的输出分布。根据这个分布,我们可以输出最可能的结果或者给出某个输出的概率。

损失函数:给定输入序列 ,我们希望最大化

的后验概率

,

应该是可导的,这样我们能执行梯度下降算法;

测试:给定一个训练好的模型和输入序列 ,我们希望输出概率最高的

:

当然,在测试时,我们希望 能够尽快的被搜索到。

给定输入 ,CTC输出每个可能输出及其条件概率。问题的关键是CTC的输出概率是如何考虑

和

之间的对齐的,这种对齐也是构建损失函数的基础。所以,首先我们分析CTC的对齐方式,然后我们在分析CTC的损失函数的构造。

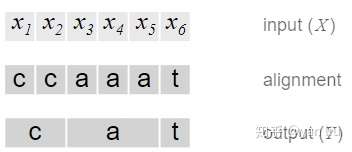

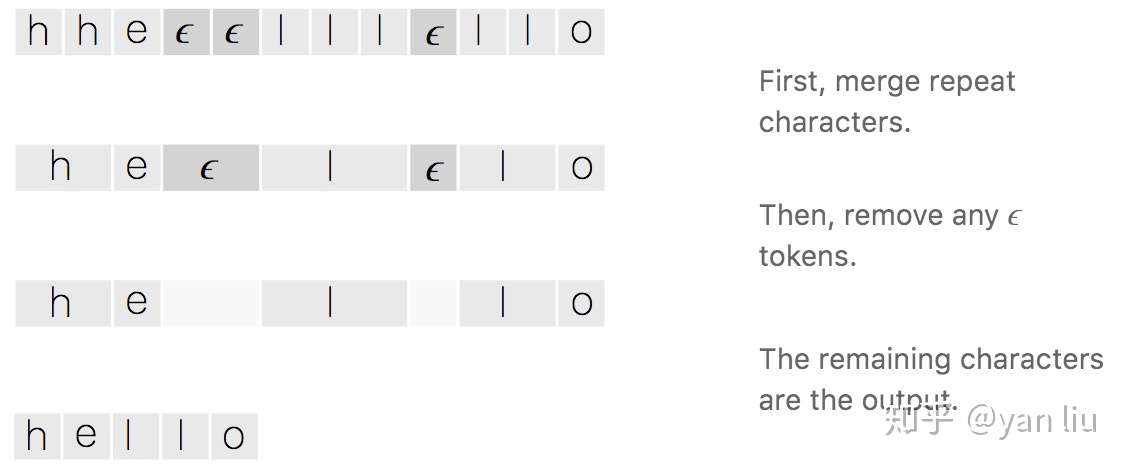

需要注意的是,CTC本身是不需要对齐的,但是我们需要知道 的输出路径和最终输出结果的对应关系,因为在CTC中,多个输出路径可能对应一个输出结果,举例来理解。例如在OCR的任务中,输入

是含有“CAT”的图片,输出

是文本[C, A, T]。将

分割成若干个时间片,每个时间片得到一个输出,一个最简答的解决方案是合并连续重复出现的字母,如图2.

图2:CTC的一种原始对齐策略

图2:CTC的一种原始对齐策略

这个问题有两个缺点:

为了解决上面的问题,CTC引入了空白字符 ,例如OCR中的字符间距,语音识别中的停顿均表示为

。所以,CTC的对齐涉及去除重复字母和去除

两部分,如图3。

图3:CTC的对齐策略

图3:CTC的对齐策略

这种对齐方式有三个特征:

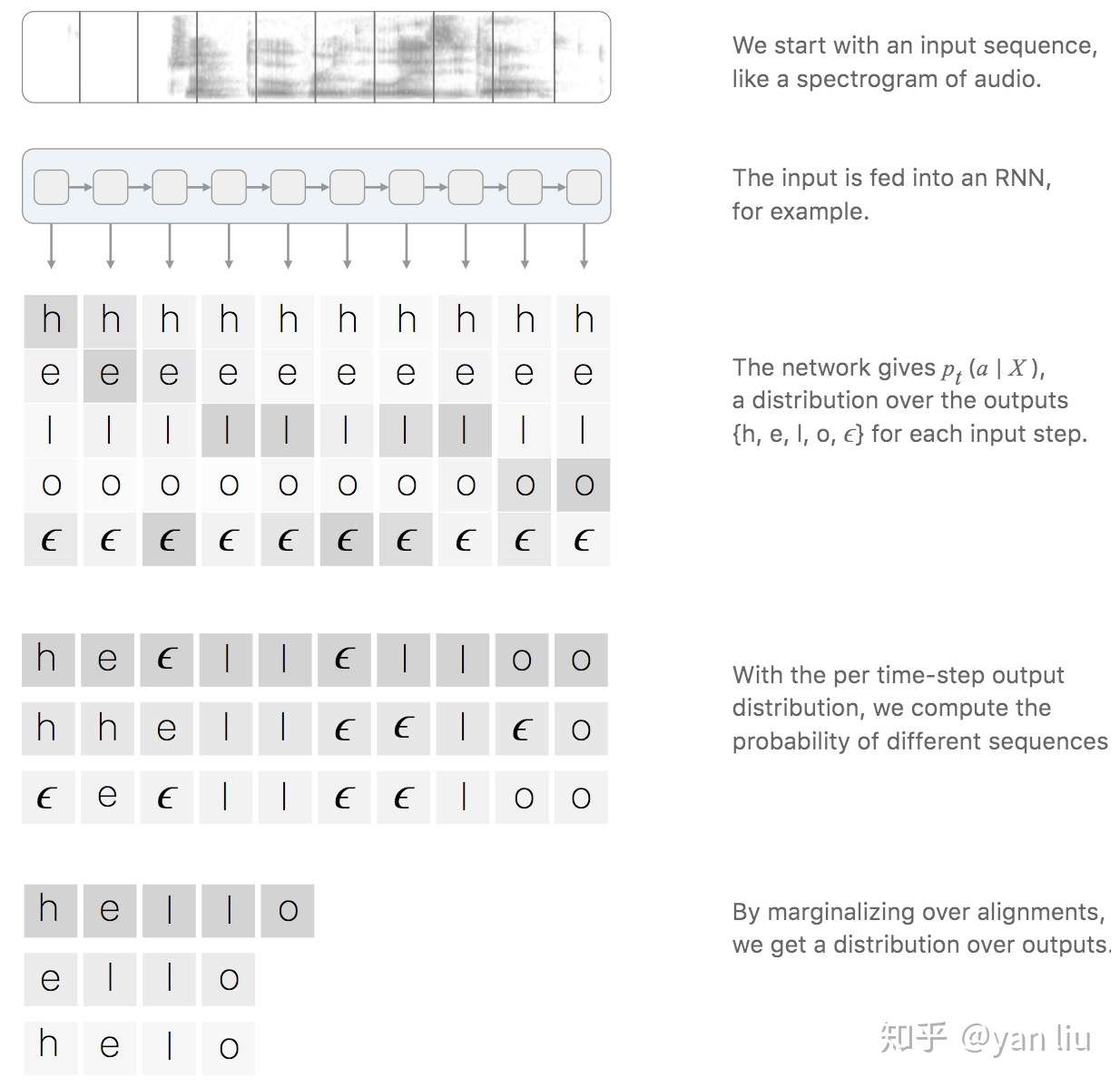

CTC的时间片的输出和输出序列的映射如图4:

图5:CTC的流程

图5:CTC的流程

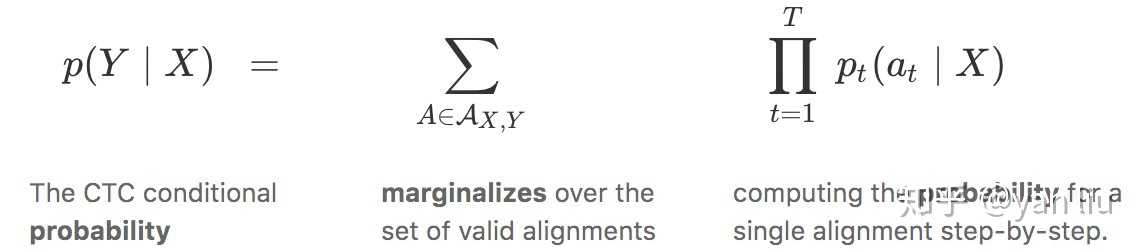

也就是说,对应标签 ,其关于输入

的后验概率可以表示为所有映射为

的路径之和,我们的目标就是最大化

关于

的后验概率

。假设每个时间片的输出是相互独立的,则路径的后验概率是每个时间片概率的累积,公式及其详细含义如图5。

图6:CTC的公式及其详细含义

图6:CTC的公式及其详细含义

上面的CTC算法存在性能问题,对于一个时间片长度为 的

分类任务,所有可能的路径数为

,在很多情况下,这几乎是一个宇宙级别的数字,用于计算Loss几乎是不现实的。在CTC中采用了动态规划的思想来对查找路径进行剪枝,算法的核心思想是如果路径

和路径

在时间片

之前的输出均相等,我们就可以提前合并他们,如图6。

图6:CTC的动态规划计算输出路径

图6:CTC的动态规划计算输出路径

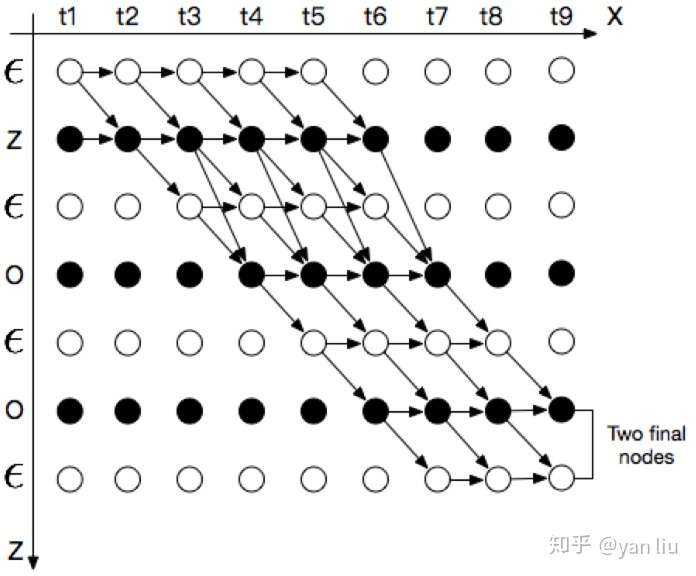

其中,横轴的单位是 的时间片,纵轴的单位是

插入

的序列

。例如对于单词“ZOO”,插入

后为:

我们用 表示路径中已经合并的在横轴单位为

,纵轴单位为

的节点。根据CTC的对齐方式的三个特征,输入有9个时间片,标签内容是“ZOO”,

的所有可能的合法路径如下图

图7:CTC中单词ZOO的所有合法路径

图7:CTC中单词ZOO的所有合法路径

上图分成两种情况

Case 1:

如果 , 则

只能由前一个空格

或者其本身

得到,如果

不等于

,但是

为连续字符的第二个,即

,则

只能由前一个空格

或者其本身

得到,而不能由前一个字符得到,因为这样做会将连续两个相同的字符合并成一个。

表示在时刻t输出字符

的概率。

Case 2:

如果 不等于

,则

可以由

,

以及

得来,可以表示为:

从图7中我们可以看到,合法路径有两个起始点,合法路径的概率 是两个final nodes的概率之和。

现在,我们已经可以高效的计算损失函数,下一步的工作便是计算梯度用于训练模型。由于 的计算只涉及加法和乘法,因此其一定是可导函数,进而我们可以使用SGD优化模型。

对于数据集 ,模型的优化目标是最小化负对数似然

当我们训练好一个RNN模型时,给定一个输入序列 ,我们需要找到最可能的输出,也就是求解

求解最可能的输出有两种方案,一种是Greedy Search,第二种是beam search

每个时间片均取该时间片概率最高的节点作为输出:

这个方法最大的缺点是忽略了一个输出可能对应多个对齐方式.

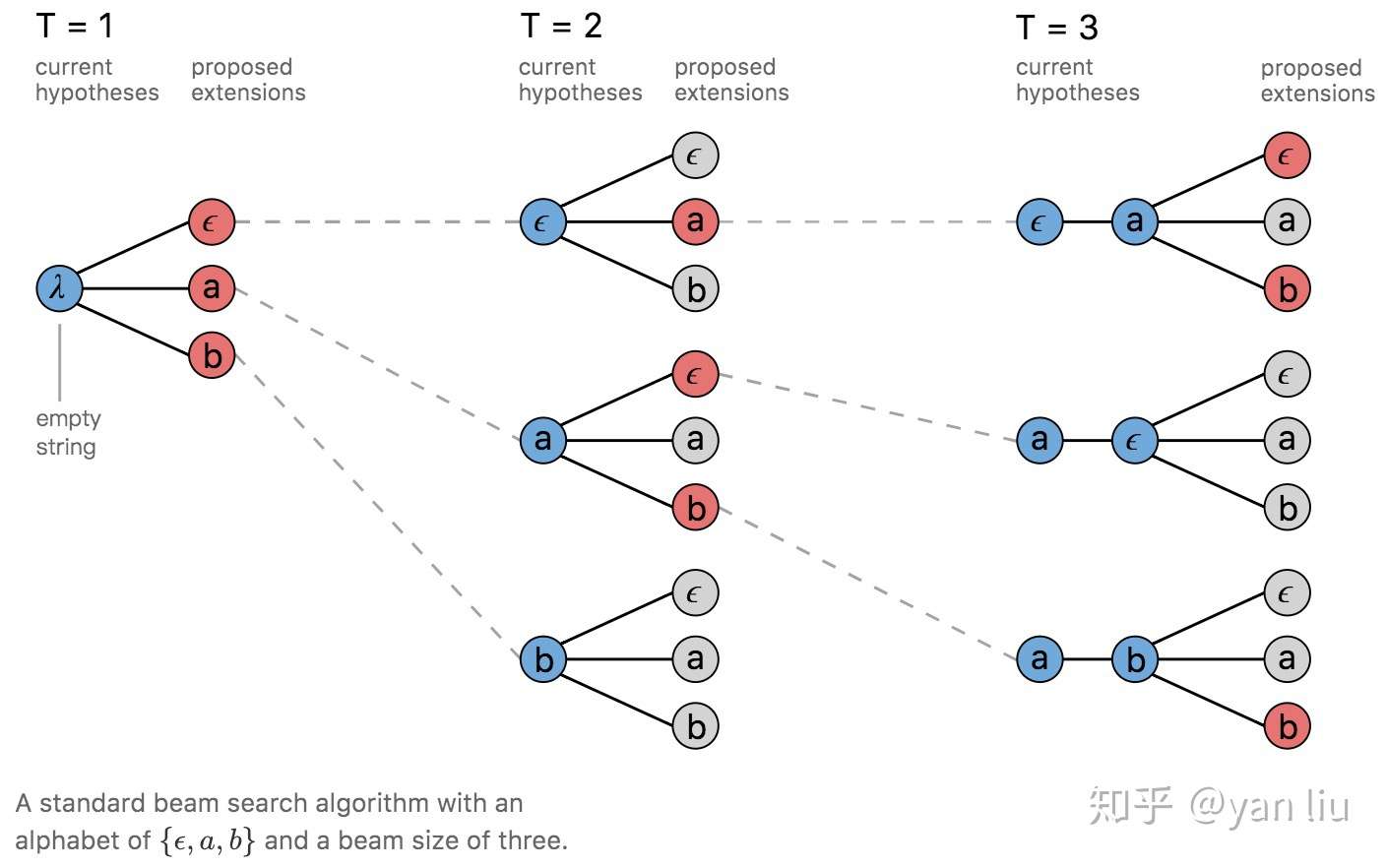

Beam Search是寻找全局最优值和Greedy Search在查找时间和模型精度的一个折中。一个简单的beam search在每个时间片计算所有可能假设的概率,并从中选出最高的几个作为一组。然后再从这组假设的基础上产生概率最高的几个作为一组假设,依次进行,直到达到最后一个时间片,下图是beam search的宽度为3的搜索过程,红线为选中的假设。

图8:Beam Search

图8:Beam Search

[1] Connectionist Temporal Classification : Labelling Unsegmented Sequence Data with Recurrent Neural Networks. Graves, A., Fernandez, S., Gomez, F. and Schmidhuber, J., 2006. Proceedings of the 23rd international conference on Machine Learning, pp. 369--376. DOI: 10.1145/1143844.1143891

[2] Sequence Modeling with CTC. Hunnun, Awni, Distill, 2017

原文:https://www.cnblogs.com/cx2016/p/13873777.html

13 条评论

我在我的博客最近也写了一篇CTC的详细介绍,包括算法原理、理论推导、代码Demo实现等各个方面都有,希望对你有帮助。链接:https://xiaodu.io/ctc-explained/

简单过了一遍,非常优秀的文章

路径总数不应该是N^T吗?每个时刻有N个可能,N*N...*N

不是这样的,并不是每个时间片都有N种可能,就比如第一个时间片就不能取第N个值

上面只算了前向α,没有算后向β,训练的时候优化的目标函数应该是前项和后项的结合吧

图7的所有合法路径,我有点小疑问,为什么不能在t1的‘z‘和t2的‘空‘之间连线

这个不是已经是语言模型了吗,各时间片不是独立的吧