使输出不再是x的线性关系,增强神经网络的表达力。

优秀的激活函数:非线性,可微性,单调性,近似恒等性。

输出范围:有限值,基于梯度,无限值,调小学习率。

sigmoid函数:求导后为0-0.25。易造成梯度消失,输出非0均值收敛慢,幂运算复杂训练时间长。

Tanh函数:易造成梯度消失,幂运算复杂训练时间长。

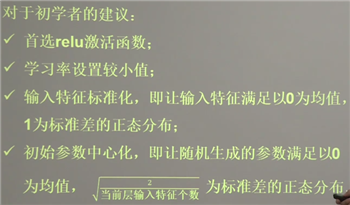

Relu函数:Dead Relu问题,某些神经元不会被激活,参数不被更新,可以通过调整初始值和学习率来避免。

原文:https://www.cnblogs.com/wmc258/p/14182900.html