TensorRT深度学习训练和部署

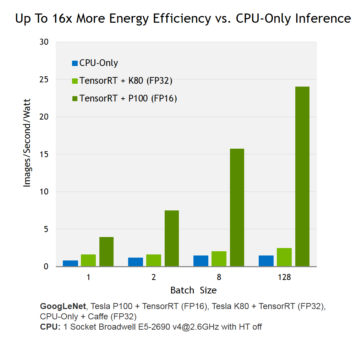

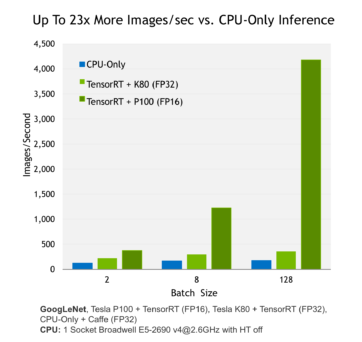

NVIDIA TensorRT是用于生产环境的高性能深度学习推理库。功率效率和响应速度是部署的深度学习应用程序的两个关键指标,因为它们直接影响用户体验和所提供服务的成本。Tensor RT自动优化训练好的神经网络,以提高运行时性能,与仅使用通用CPU的深度学习推理系统相比,Tesla P100 GPU的能源效率(每瓦性能)提高多达16倍(见图1)。图2显示了使用TensorRT和相对复杂的GoogLenet神经网络架构运行NVIDIA Tesla P100和K80进行推理的性能。

本文将展示如何使用Tensor RT,在基于GPU的部署平台上,从经过训练的深度神经网络中,获得最佳效率和性能。

图1:NVIDIA Tensor RT通过Tesla P100上的FP16,为神经网络推理提供了16倍的高能效。

图2:NVIDIA Tensor RT通过Tesla P100上的FP16提供了23倍的神经网络推理性能。

用深度神经网络解决有监督的机器学习问题,涉及两个步骤。

原文:https://www.cnblogs.com/wujianming-110117/p/14249742.html