bin/spark-shell --master local[6] #本地运行

读取文件

val rdd1=sc.textFile("file:///export/wordcount.txt") #读取本地文件

val rdd1=sc.textFile("hdfs://node01:8020/wordcount.txt") #读取hdfs文件

分割展平

val rdd2=rdd1.flatMap(item=>item.split(" "))

赋予词频

val rdd3=rdd2.map(item=>(item,1))

reduce聚合

val rdd4=rdd3.reduceByKey((curr,agg)=>curr+agg)

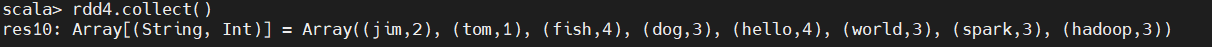

数据展示

rdd4.collect()

原文:https://www.cnblogs.com/haheihei/p/14368841.html