概念:通过编写程序,模拟浏览器上网,然后让程序自动去互联网上爬取数据的过程。

价值:提高数据提取效率,具有实际应用的价值。

爬虫技术是一种计算机技术,具有中立性,爬虫本身在法律上不被禁止,但是在获取数据的行为具有违法的风险。

根据合法性分类:

实际运用中需要注意事项:

1、通用爬虫:抓取系统重要组成部分,爬取的是一整张页面数据。

2、聚焦爬虫:建立在通用爬虫基础之上,抓取页面中特定的数据。

3、增量式爬虫:可以用来检测网站数据更新的情况,并且可以将网站更新的数据进行爬取。

反爬机制:门户网站通过制定相应的策略或者技术手段,防止爬虫程序进行网站数据的爬取。

反反爬机制:爬虫程序通过制定相关策略或者技术手段,用来破解门户网站中的反爬机制,从而获取数据。

搜索引擎从业者和网站站长通过邮件讨论定下了一项“君子协议”—— robots.txt。即网站有权规定网站中哪些内容可以被爬虫抓取,哪些内容不可以被爬虫抓取。这样既可以保护隐私和敏感信息,又可以被搜索引擎收录、增加流量。

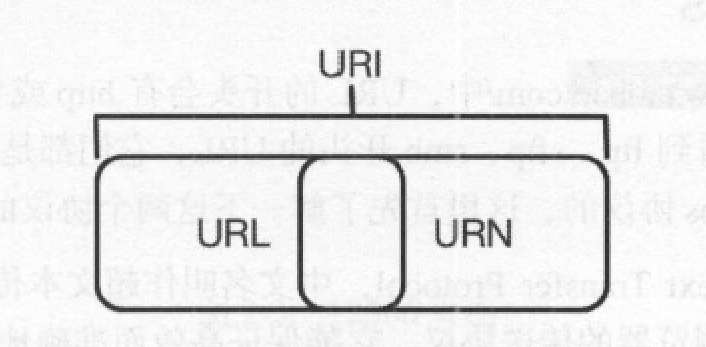

用于指定资源的访问方式:访问协议(HTTP/HTTPS) + 访问路径(/即根目录)+资源名称

URI:Uniform Resource Identifier,统一资源标志符;

URL:Uniform Resource Locator,统一资源定位符;

URN:Uniform Resource Name,统一资源名称。

服务器和客户端进行数据交互的形式(访问资源需要的协议类型)。

http协议:(Hyper Text Transfer Protocol)万维网(WWW:World Wide Web )服务器传输超文本到本地浏览器的传送协议。基于TCP/IP通信协议来传递数据(HTML 文件, 图片文件, 查询结果等)。

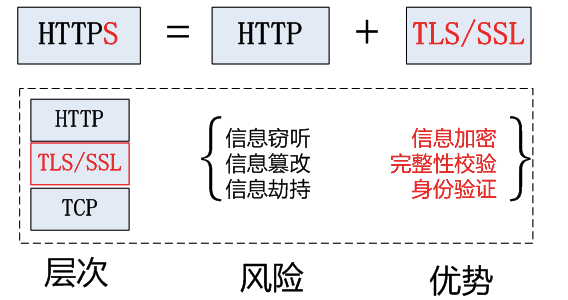

https协议:(Hyper Text Transfer Protocol over SecureSocket Layer),是以安全为目标的 HTTP 通道,在HTTP的基础上通过传输加密和身份认证保证了传输过程的安全性 。HTTPS 在HTTP 的基础下加入SSL 层,HTTPS 的安全基础是SSL,因此加密的详细内容就需要 SSL。 HTTPS 存在不同于 HTTP 的默认端口及一个加密/身份验证层(在 HTTP与 TCP 之间)。这个系统提供了身份验证与加密通讯方法。它被广泛用于万维网上安全敏感的通讯,例如交易支付等方面 。

https加密算法:

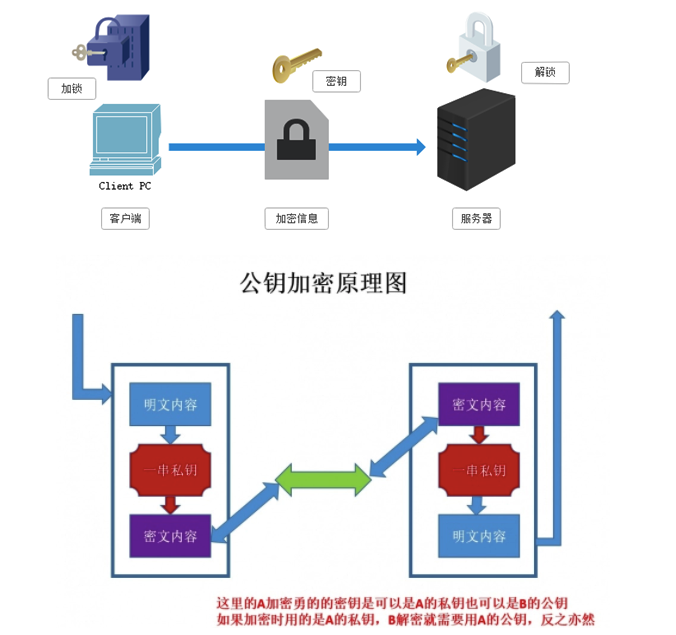

对称秘钥加密:客户端向服务器发送一条信息,首先客户端会采用已知的算法对信息进行加密,比如MD5或者Base64加密,接收端对加密的信息进行解密的时候需要用到密钥,中间会传递密钥,(加密和解密的密钥是同一个),密钥在传输中间是被加密的。这种方式看起来安全,但是仍有潜在的危险,一旦被窃听,或者信息被挟持,就有可能破解密钥,而破解其中的信息。因此“共享密钥加密”这种方式存在安全隐患。

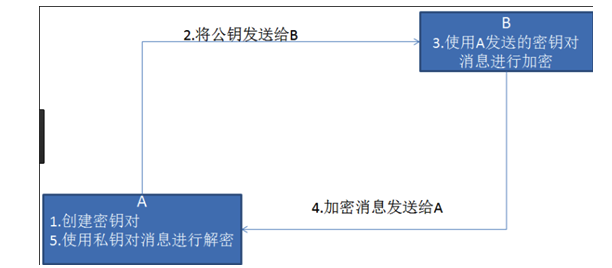

非对称秘钥加密:使用两把锁,一把叫做“私有密钥”,一把是“公开密钥”。服务器首先告诉客户端按照自己给定的公开密钥进行加密处理,客户端按照公开密钥加密后传输加密的数据给服务器,服务器在接受到信息后通过自己的私有密钥进行解密。解密的钥匙不会进行传输,因此也就避免了被挟持的风险。就算公开密钥被窃听者拿到了,它也很难进行解密,因为解密过程是对离散对数求值。

非对称秘钥加密技术的缺点:

第一是:公开秘钥传输还是有可能被挟持,客户端无法确保收到的公开密钥是没有被篡改过的。

第二是:非对称加密的方式效率比较低,处理起来更为复杂,会影响通信速度。

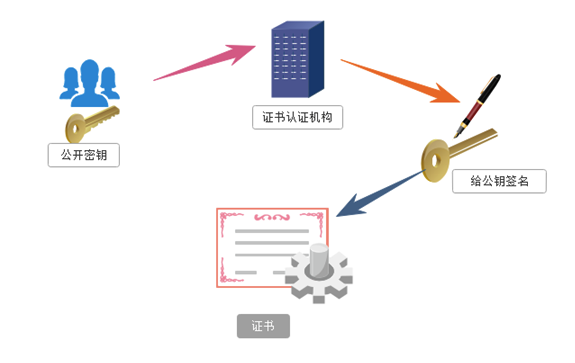

证书秘钥加密:为避免公钥可能存在被挟持的情况,保证客户端收到的公开密钥就是服务器发行的,就此引出了公开密钥证书机制,在客户端和服务器之间建立一个可信赖的第三方机构担任数字证书认证机构。

证书的具体传播过程如下:

服务器的开发者携带公开密钥,向数字证书认证机构提出公开密钥的申请;

数字证书认证机构去辨认申请者的身份,在审核通过以后,会对开发者申请的公开密钥进行数字签名,然后分配这个已签名的公开密钥,并将密钥放在证书里面,将这份数字证书发送给客户端;

客户端也认可证书机构,可以通过数字证书中的数字签名来验证公钥的真伪,来确保服务器传过来的公开密钥是真实的,一旦确认信息无误之后,客户端就会通过公钥对报文进行加密发送,服务器接收到以后就可以用自己的私钥进行解密。

一般情况下,证书的数字签名是很难被伪造的,但这也取决于认证机构的公信力。

由客户端向服务端发出。

请求方法(Request Method)

常用的请求:GET 和 POST;

区别:GET请求的参数包含在URL里面, POST请求的参数不包含在URL里面,数据都是通过表单形式传输的,包含在请求体内;GET请求提交的数据最多只有1024字节,而POST方式没有限制。

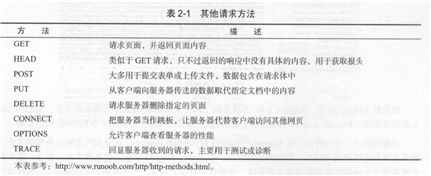

其他请求方法:

请求网址(Request URL):即统一资源定位码(URL);

请求头(Request Headers):包含Accept\Accept-Language\Accept-Encoding\Host\Cookie\Referer\User-Agent\Content-Type等信息;

请求体(Request Body):POST请求中的表单数据,对于GET请求,请求体则为空。

由服务端返回给客户端。

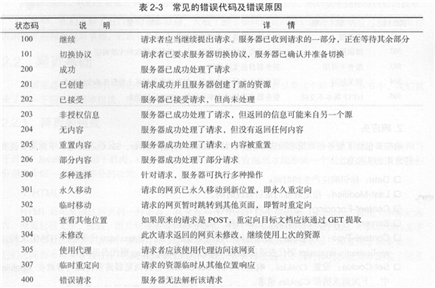

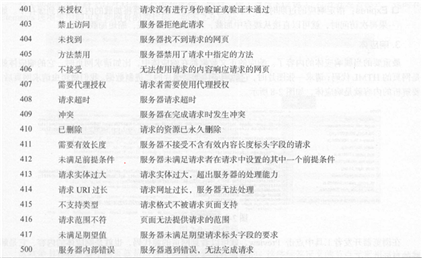

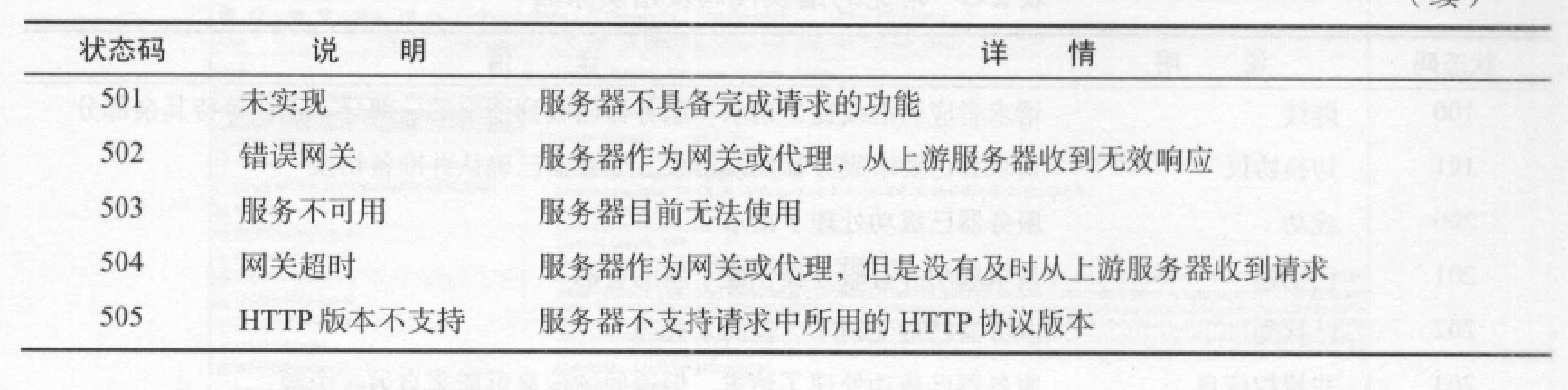

响应状态码(Response Status Code)

常见状态码:200代表服务器正常响应,404代表页面未找到,500代表服务器内部发生错误。

响应头(Response Headers)

包含服务器对请求的应答信息,如Date\Last-Modified\Content-Encoding\Content-Type\Set-Cookie\Expires等。

响应体(Response Body):HTML代码,响应的正文数据。

网页主要三大部分:HTML、CSS和JavaScript。

HTML定义网页的内容和结构;CSS描述了网页的布局;JavaScript定义了网页的行为。

HTML(Hyper Text Markup Language,超文本标记语言)--骨架

HTML用来描述网页的一种语言,网页的基础骨架,不同的元素通过不同类型的标签表示,并通过布局标签嵌套组合而成。

CSS(Cascading Styple Sheets,层叠样式表)--皮肤

通过CSS实现网页页面的排版,使页面更加美观。

JavaScript--肌肉

一种脚本语言,可使网页实现实时、动态、交互的页面功能。

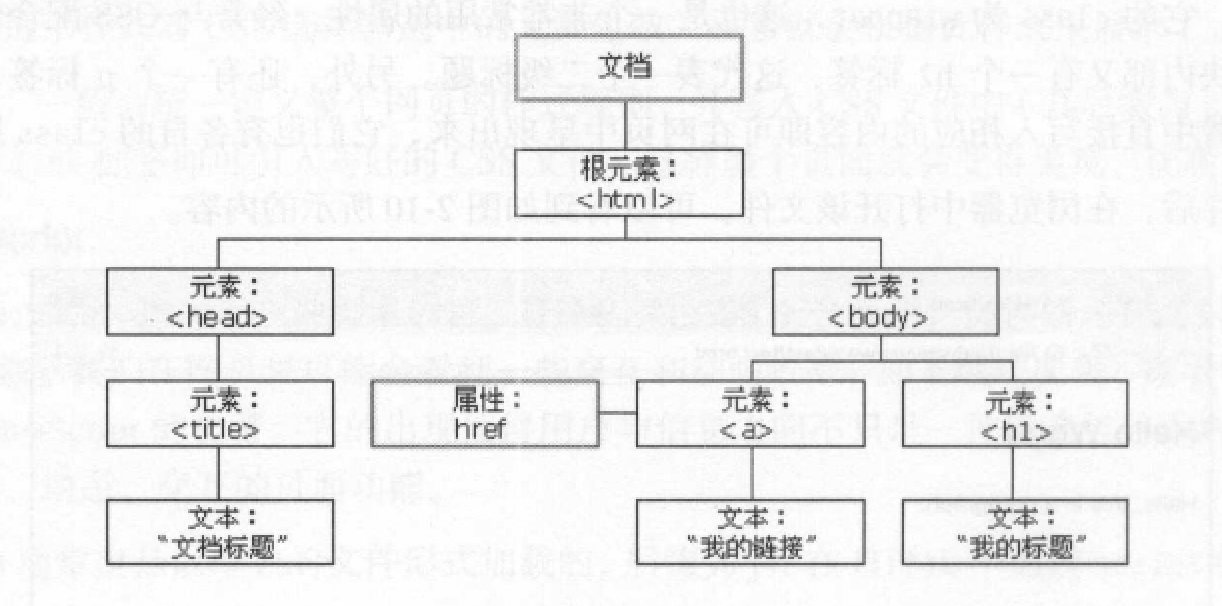

DOM(Document Object Model,文档对象模型) :中立于平台和语言的接口,它允许程序和脚本动态地访问和更新文档的内容、结构和样式。

W3C DOM标准:

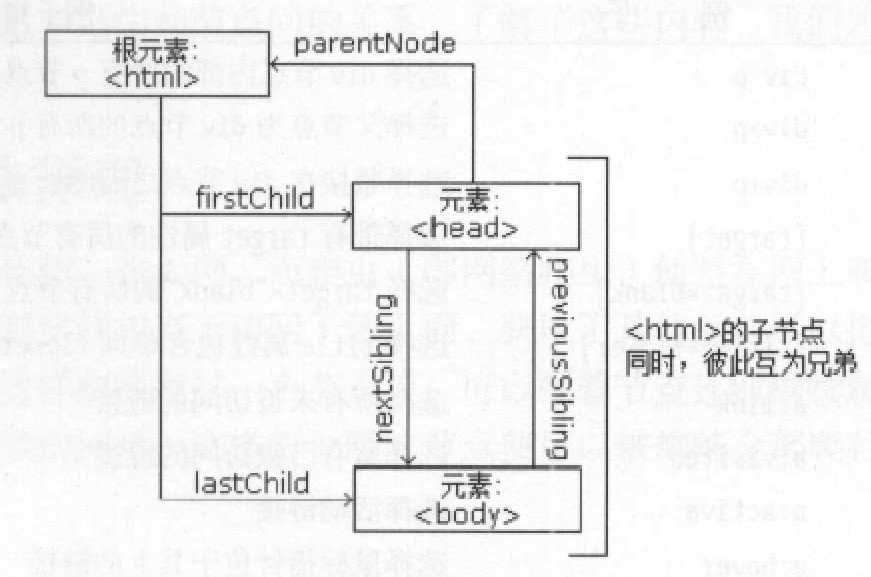

HTML DOM:将HTML文档视作树结构,称为节点树。树中的节点可通过JavaScript访问,节点元素均可被修改、创建、删除,彼此之间具有层次关系(父节点、子节点、兄弟节点)。

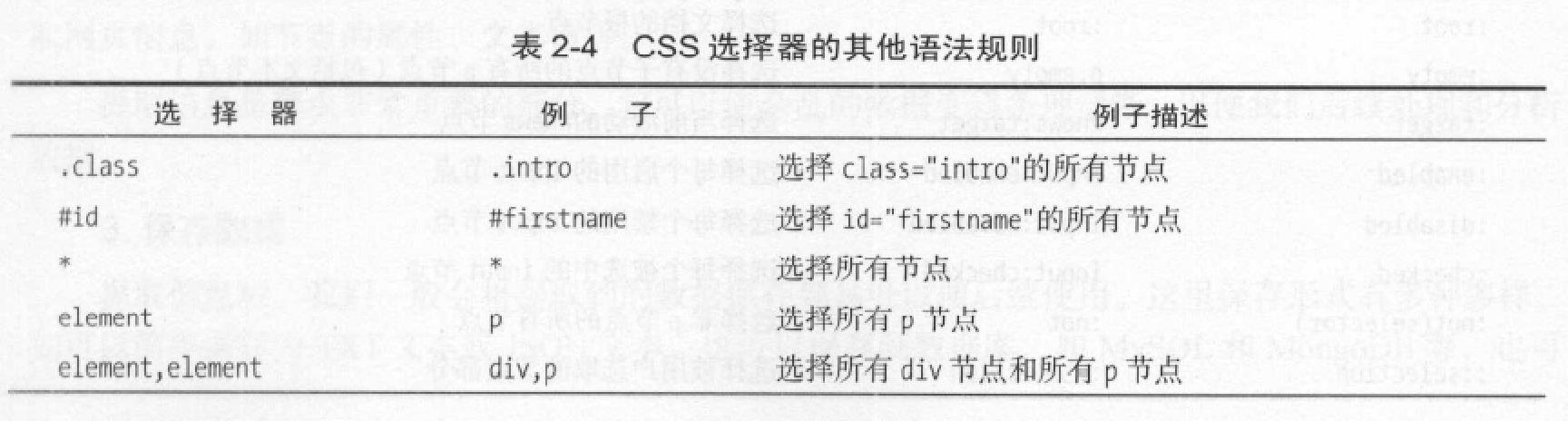

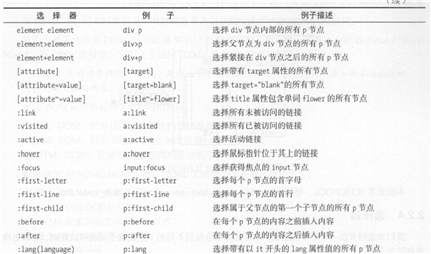

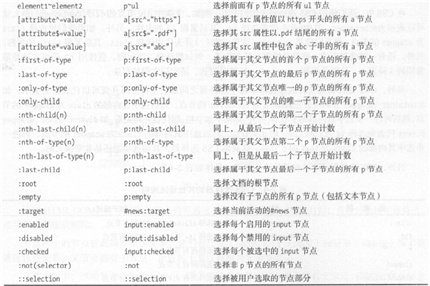

CSS选择器会根据不同的节点设置不同的样式规则,也可以用来定位节点。

CSS语法规则:

主要流程:获取网页-->提取信息-->保存数据。(利用程序自动化)

由于HTTP协议对事务处理没有记忆能力,服务器不知道客户端是什么状态。

为保持HTTP连接状态,需要会话和Cookies配合。

原文:https://www.cnblogs.com/xiqi2018/p/13953110.html