最近在做自然语言处理,需要对文本进行分词,我使用的是jieba分词,记录一下安装的步骤防止自己会忘记,前期在学习神经网络的时候安装了anaconda,所以我的python环境有点乱

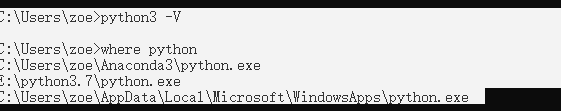

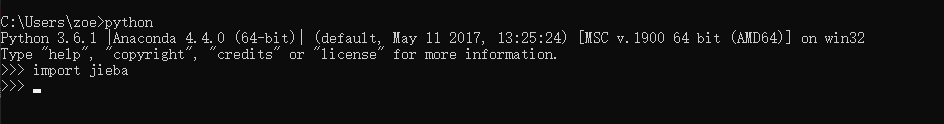

1、查看电脑的python

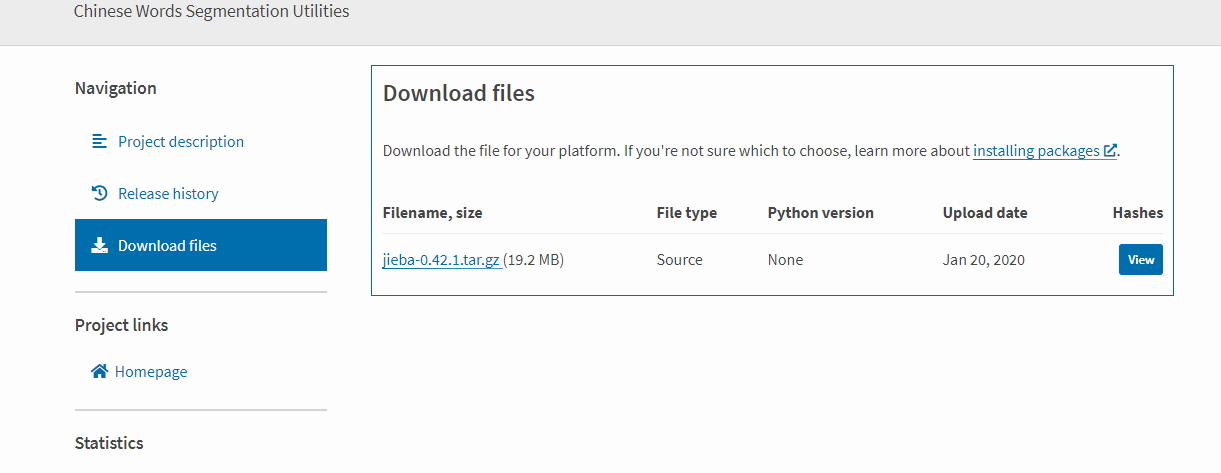

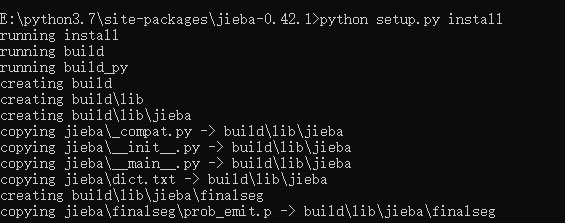

2、下载安装jieba

官网:https://pypi.org/project/jieba/#files

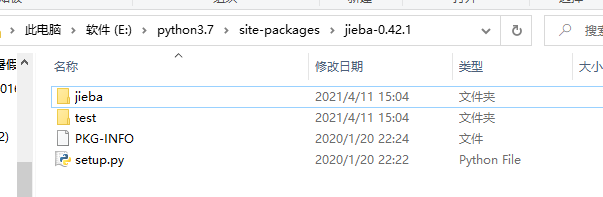

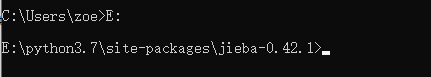

安装到python目录下,随便那个路径但是要记住路径

没有报错说明安装成功了,因为我安装了anaconda所以我的上面会显示anaconda,可能会不太一样。

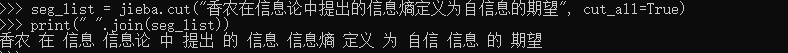

测试一波

在这里说明一下如果采用不同的分词模式,分词的结果也会不同。

原文:https://www.cnblogs.com/chuxinbubian/p/14644684.html