1. 修改mapred-site.xml配置,配置文件在Hadoop安装目录下,etc/hadoop/mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.job.tracker</name>

<value>hdfs://master:8001</value>

<final>true</final>

</property>

2. 修改完以上配置,重启下服务试试看

stop-all.sh

start-all.sh

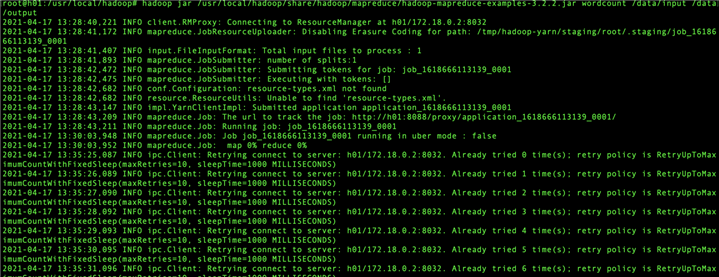

3. 如果还是不行,则修改yarn-site.xml,新增如下配置

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>20480</value>

</property>

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>2048</value>

</property>

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>2.1</value>

</property>

4. 解决完成

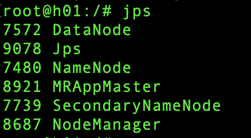

1. 重启yarn

start-yarn.sh

2. 输入jps查看是否启动完成

3. 解决完成

hadoop dfsadmin -safemode leave

用户可以通过dfsadmin -safemode value 来操作安全模式,参数value的说明如下:

enter - 进入安全模式

leave - 强制NameNode离开安全模式

get - 返回安全模式是否开启的信息

wait - 等待,一直到安全模式结束

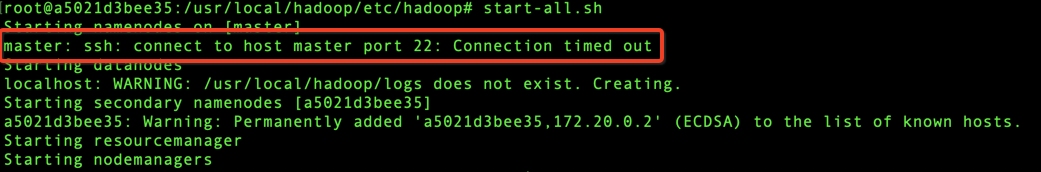

1.关闭所有的节点:

stop-all.sh

2.namenode格式化

hadoop namenode -format

3.开启所有的节点:

start-all.sh

4. 解决完成

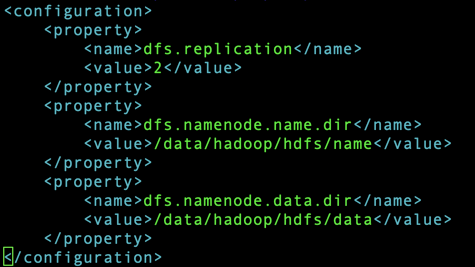

解决如下:

1. 停止服务

stop-all.sh

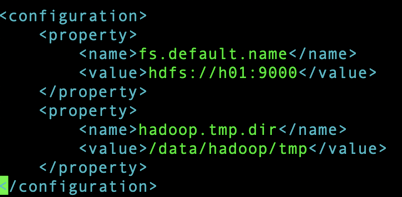

2. 找到hadoop安装目录下配置的tmp,/etc/hadoop/core-site.xml,查看tmp目录

3. 删除/data/hadoop/tmp目录下的文件

4. 找到hadoop安装目录下配置的name、data目录,/etc/hadoop/hdfs-site.xml ,查看目录

5. 删除/data/hadoop/hdfs/data/和/data/hadoop/hdfs/name目录下的文件

6. 启动服务

start-all.sh

1. 安装ssh

2. 启动服务

service ssh start

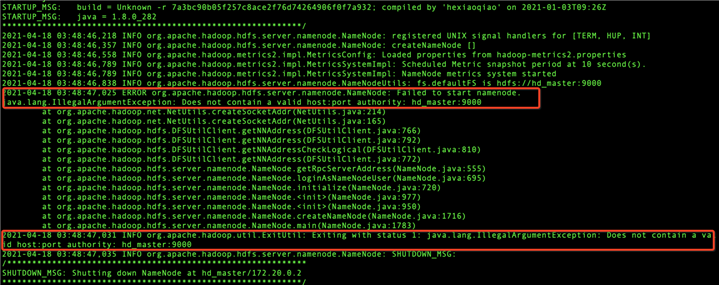

原因是:Hostname不能包含-或_。且不要重复绑定

解决如下:

1. 重新配置打包镜像,将hosts的下划线"_"去掉,即,“hd_master”改“hdmaster”

原文:https://www.cnblogs.com/will-xz/p/14672894.html