github链接:https://github.com/fanjianhai/CODE/tree/main/SpringBoot/springboot-11-elasticsearch-jd

搭建springboot项目,添加依赖,修改es版本

ElasticSearch简称es,是一个开源的高扩展的分布式全文检索引擎。

很简单,指的就是 Elastic Stack。

“ELK”是三个开源项目的首字母缩写,这三个项目分别是:Elasticsearch、Logstash 和 Kibana。

Elasticsearch 是一个搜索和分析引擎。

Logstash 是服务器端数据处理管道,能够同时从多个来源采集数据,转换数据,然后将数据发送到诸如 Elasticsearch 等“存储库”中。

Kibana 则可以让用户在 Elasticsearch 中使用图形和图表对数据进行可视化。

ElasticSearch :https://mirrors.huaweicloud.com/elasticsearch/?C=N&O=D

logstash :https://www.elastic.co/cn/downloads/logstash

kibana : https://mirrors.huaweicloud.com/kibana/?C=N&O=D

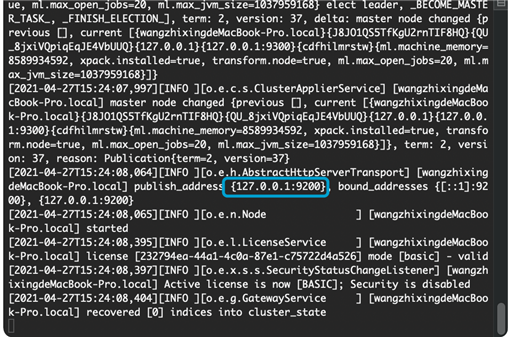

1、解压Es之后,进入bin目录

可以双击运行软件

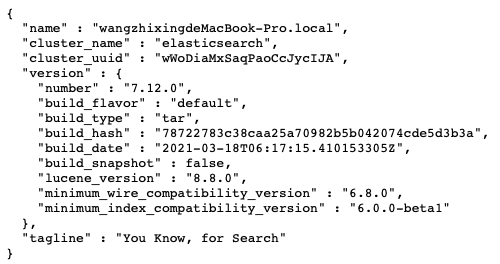

访问127.0.0.1:9200可以看到:

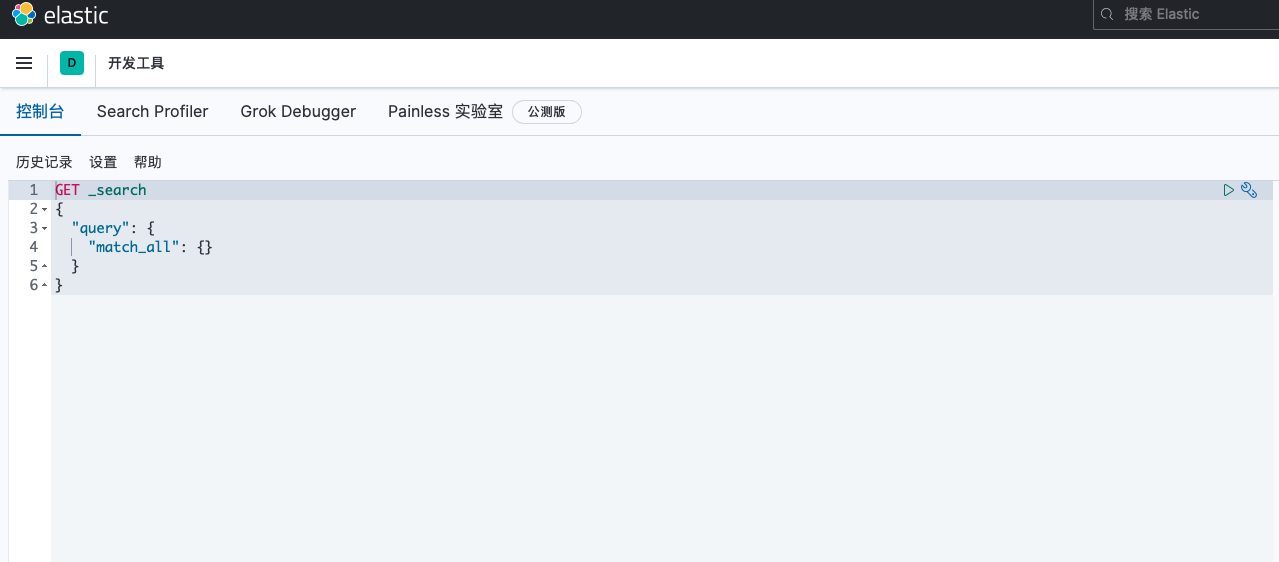

像之前es的一样直接双击kibana即可

访问127.0.0.1:5601

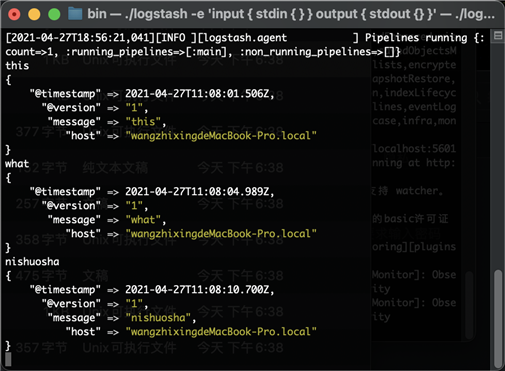

要测试 Logstash 安装,请运行最基本的 Logstash 管道。 例如:

cd logstash-7.6.2

bin/logstash -e ‘input { stdin { } } output { stdout {} }‘

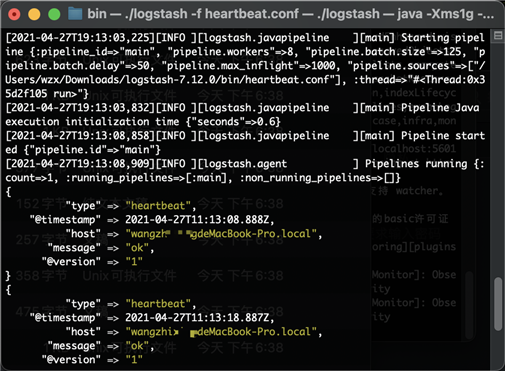

等 Logstash 完成启动后,我们在 stdin 里输入一下文字,我们可以看到如下的输出:

当我们打入一行字符然后回车,那么我们马上可以在 stdout 上看到输出的信息。

如果我们能看到这个输出,说明我们的 Logstash 的安装是成功的。

另外一种运行 Logstash 的方式,也是一种最为常见的运行方式。我们首先需要创建一个配置文件,比如:heartbeat.conf

input {

heartbeat {

interval => 10

type => "heartbeat"

}

}

output {

stdout {

codec => rubydebug

}

}

使用如下命令执行,发现每隔10s进行一次output

bin/logstash -f heartbeat.conf

详细的请看:https://elasticstack.blog.csdn.net/article/details/105979677

下载:https://github.com/mobz/elasticsearch-head

cnpm install

npm run start

发现连接不上,跨域问题(跨端口,跨网站等)

添加两行:

http.cors.enabled: true

http.cors.allow-origin: "*"

再次访问127.0.0.1:9100

可以发现可以访问了

集群,节点,索引,类型,文档,分片,映射是什么?

elasticsearch是面向文档,关系型数据库和elasticsearch客观的对比!一切都是json

| Relational DB | Elasticsearch |

|---|---|

| 数据库(database) | 索引(indices) |

| 表(tables) | types |

| 行(rows) | documents |

| 字段(columns) | fields |

物理设计:

逻辑设计:

索引->类型->文档id,通过这个组合我们就能索引到某个具体的文档。注意:ID不必是整数,实际上它是一个字符串。就是我们的一条条的记录,elasticsearch是面向文档的,那么就意味着索弓和搜索数据的最小单位是文档, elasticsearch中,文档有几个重要属性:

自我包含, 一篇文档同时包含字段和对应的值,也就是同时包含key:value !

可以是层次型的,一个文档中包含自文档,复杂的逻辑实体就是这么来的! {就是一 个json对象! fastjson进行自动转换!}

灵活的结构,文档不依赖预先定义的模式,我们知道关系型数据库中,要提前定义字段才能使用,在elasticsearch中,对于字段是非常灵活的,有时候,我们可以忽略该字段,或者动态的添加一个新的字段。

尽管我们可以随意的新增或者忽略某个字段,但是,每个字段的类型非常重要,比如一个年龄字段类型,可以是字符串也可以是整形。因为elasticsearch会保存字段和类型之间的映射及其他的设置。这种映射具体到每个映射的每种类型,这也是为什么在elasticsearch中,类型有时候也称为映射类型。

就是数据库。索引是映射类型的容器,。elasticsearch中的索引是一个非常大的文档集合。索引存储了映射类型的字段和其他设置。然后它们被存储到了各个分片上了。

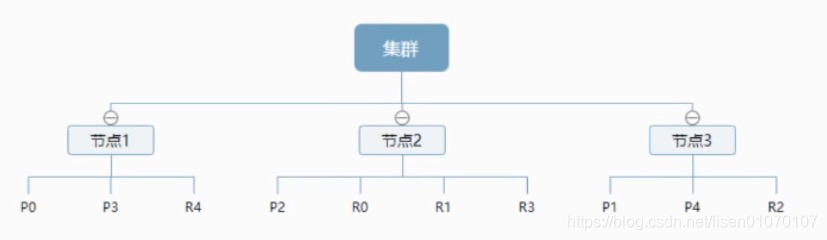

物理设计:节点和分片如何工作

一个集群至少有一 个节点,而一个节点就是一个elasricsearch进程,节点可以有多个索引默认的,如果你创建索引,那么索引将会有个5个分片( primary shard,又称主分片)构成的,每一个主分片会有一个副本( replica shard ,又称复制分片)

上图是一个有3个节点的集群,可以看到主分片和对应的复制分片都不会在同一个节点内,这样有利于某个节点挂掉了,数据也不至于丢失。

实际上, 一个分片是一个Lucene索引,一个包含倒排索引的文件目录,倒排索引的结构使得elasticsearch在不扫描全部文档的情况下,就能告诉你哪些文档包含特定的关键字。

elasticsearch使用的是一种称为倒排索引的结构,采用Lucene倒排索作为底层。

这种结构适用于快速的全文搜索,一个索引由文档中所有不重复的列表构成,对于每一个词,都有一个包含它的文档列表。

例如,现在有两个文档,每个文档包含如下内容:

Study every day, good good up to forever # 文档1包含的内容

To forever, study every day,good good up # 文档2包含的内容

为创建倒排索引,我们首先要将每个文档拆分成独立的词(或称为词条或者tokens) ,然后创建一一个包含所有不重 复的词条的排序列表,然后列出每个词条出现在哪个文档:

| term | doc_1 | doc_2 |

|---|---|---|

| Study | √ | x |

| To | x | x |

| every | √ | √ |

| forever | √ | √ |

| day | √ | √ |

| study | x | √ |

| good | √ | √ |

| every | √ | √ |

| to | √ | x |

| up | √ | √ |

现在,我们试图搜索 to forever,只需要查看包含每个词条的文档

| term | doc_1 | doc_2 |

|---|---|---|

| to | √ | x |

| forever | √ | √ |

| total | 2 | 1 |

两个文档都匹配,但是第一个文档比第二个匹配程度更高。如果没有别的条件,现在,这两个包含关键字的文档都将返回。

再来看一个示例,比如我们通过博客标签来搜索博客文章。那么倒排索引列表就是这样的一个结构:

| 博客文章(原始数据) | 博客文章(原始数据) | 索引列表(倒排索引) | 索引列表(倒排索引) |

|---|---|---|---|

| 博客文章ID | 标签 | 标签 | 博客文章ID |

| 1 | python | python | 1,2,3 |

| 2 | python | linux | 3,4 |

| 3 | linux,python | ||

| 4 | linux |

如果要搜索含有python标签的文章,那相对于查找所有原始数据而言,查找倒排索引后的数据将会快的多。只需要查看标签这一栏,然后获取相关的文章ID即可。完全过滤掉无关的所有数据,提高效率!

1、https://github.com/medcl/elasticsearch-analysis-ik

2、解压放到plugins

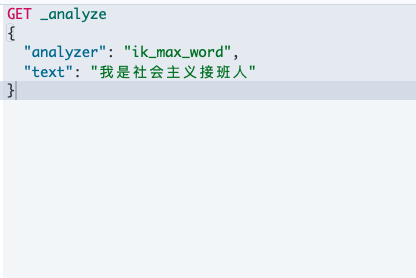

IK提供了两个分词算法: ik_ smart和ik_ max_ word ,其中ik_ smart为最少切分, ik_ max_ _word为最细粒度划分!一会我们测试!

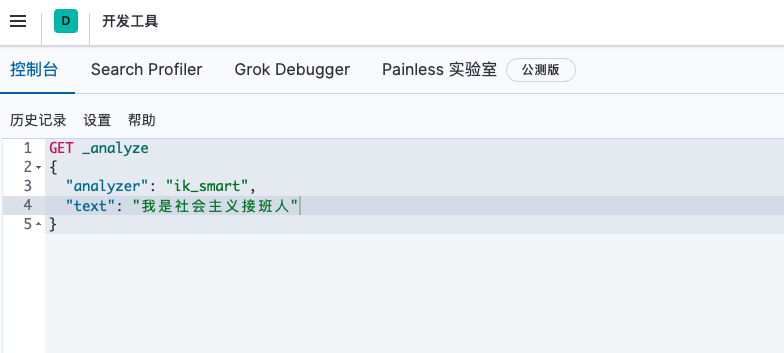

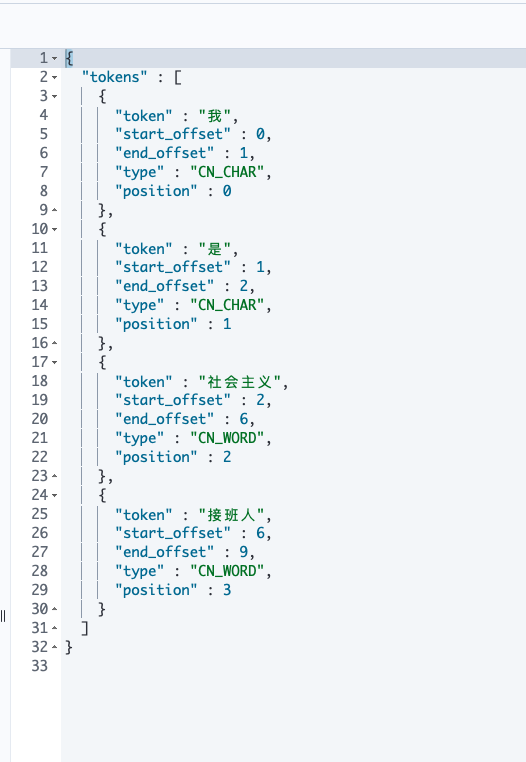

把一句话分词

如果使用中文:推荐IK分词器

两个分词算法:ik_smart(最少切分),ik_max_word(最细粒度划分)

输出:

输出

一种软件架构风格,而不是标准。更易于实现缓存等机制

| method | url地址 | 描述 |

|---|---|---|

| PUT | localhost:9200/索引名称/类型名称/文档id | 创建文档(指定文档id) |

| POST | localhost:9200/索引名称/类型名称 | 创建文档(随机文档id) |

| POST | localhost:9200/索引名称/类型名称/文档id/_update | 修改文档 |

| DELETE | localhost:9200/索引名称/类型名称/文档id | 删除文档 |

| GET | localhost:9200/索引名称/类型名称/文档id | 通过文档id查询文档 |

| POST | localhost:9200/索引名称/类型名称/_search | 查询所有的数据 |

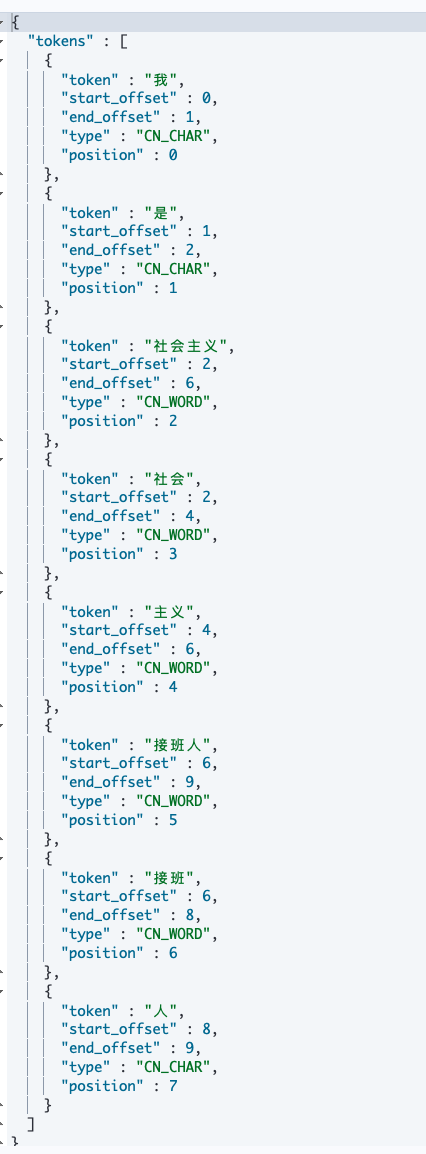

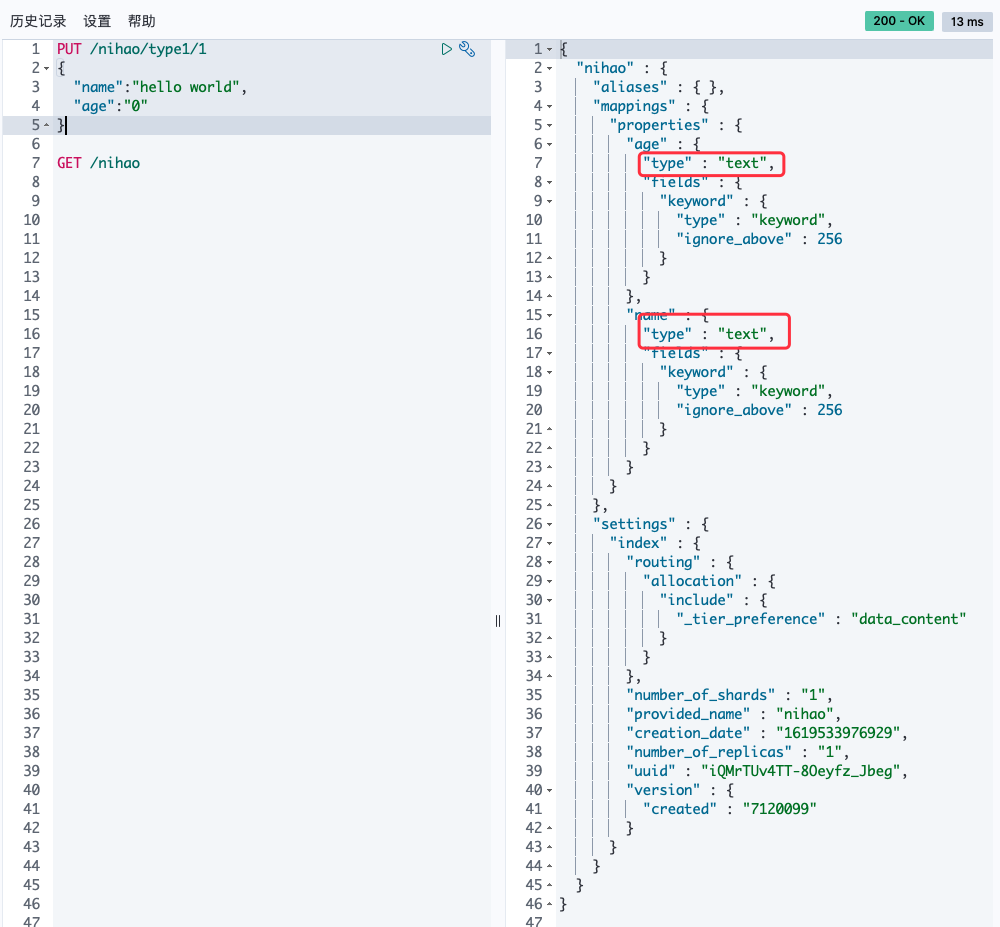

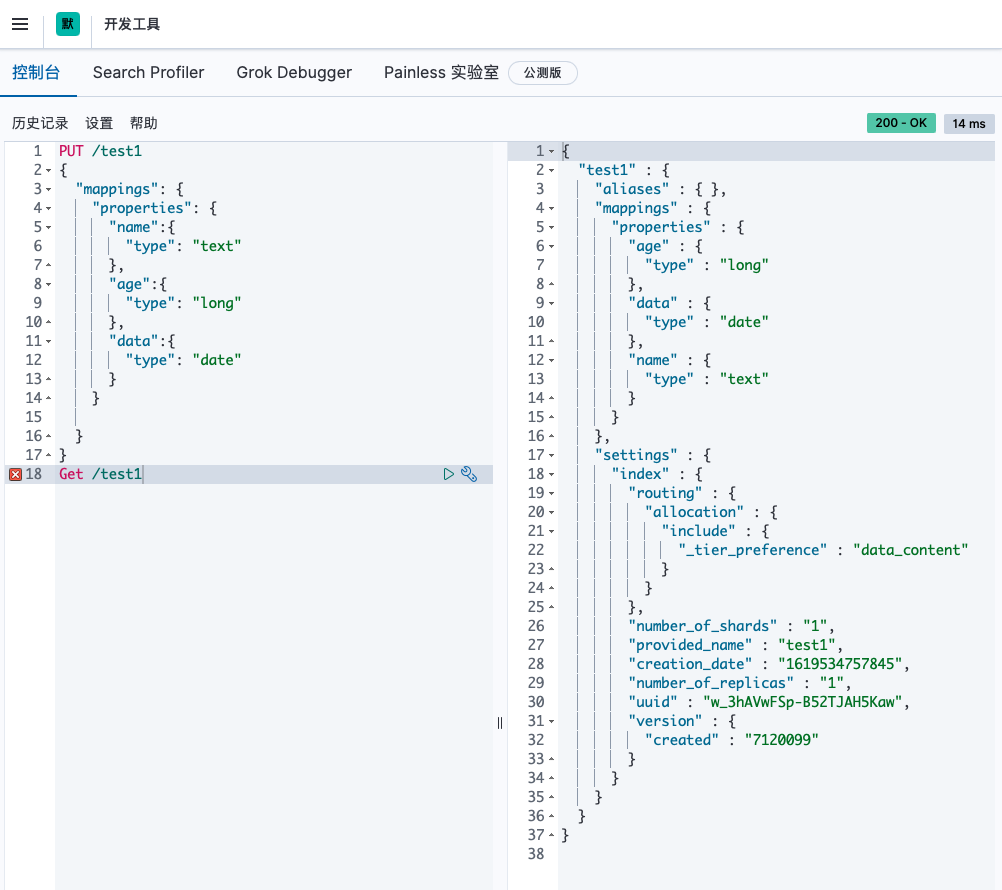

PUT /索引名/类型名/文档id

{请求体}

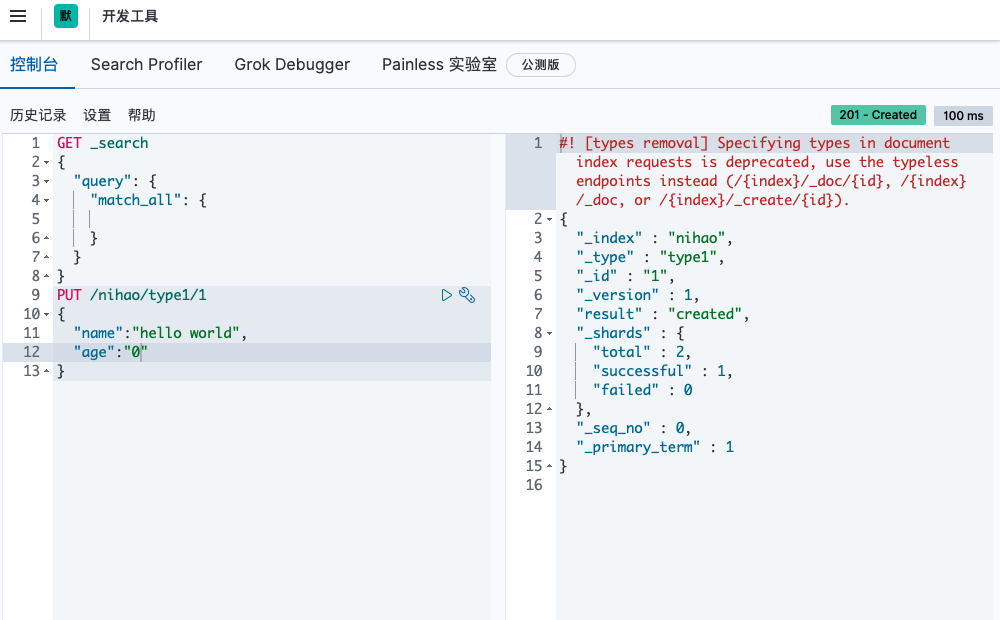

可以看到插入成功。

获得这个规则!可以通过GET请求获得具体的信息

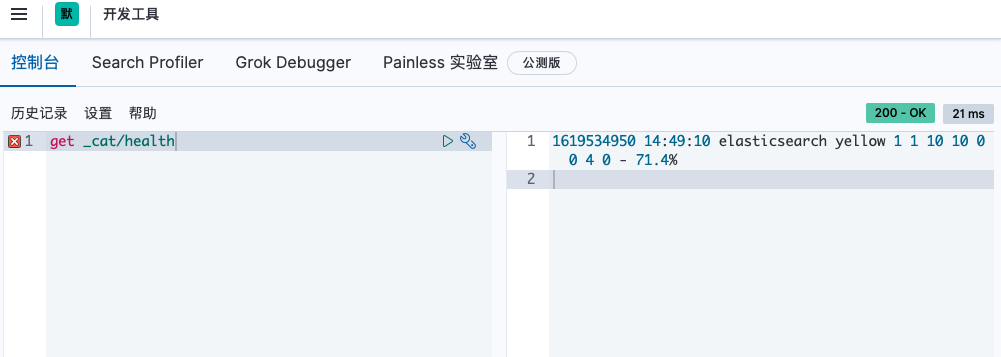

查看健康值

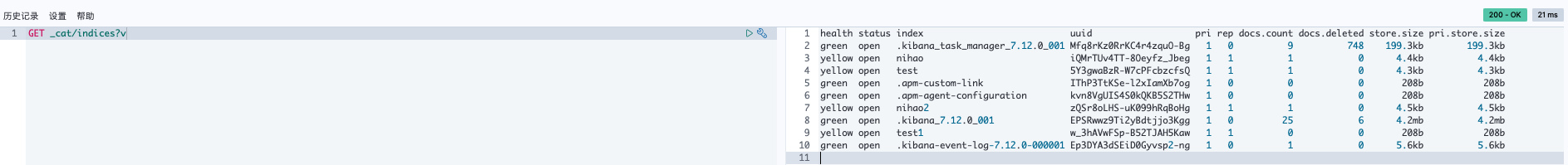

查看所有信息

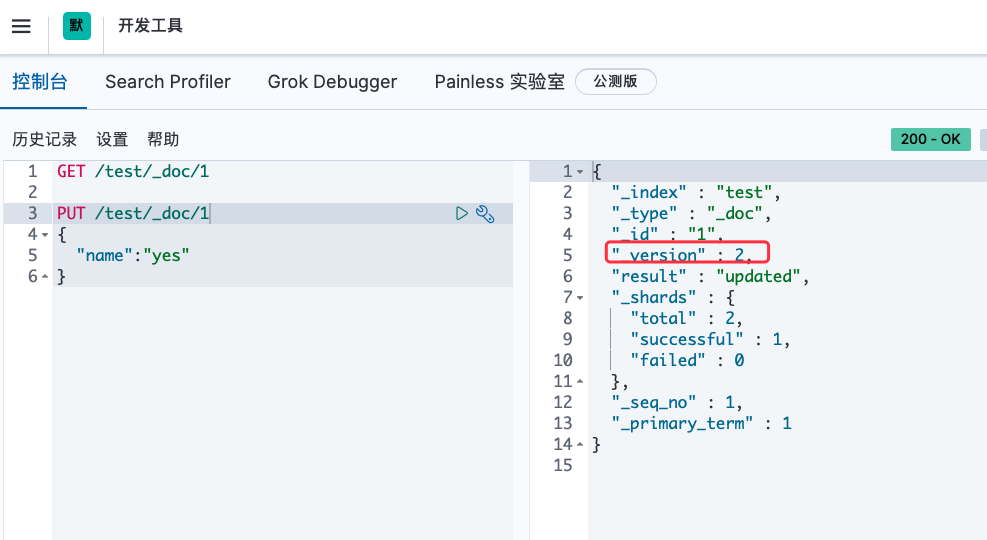

1.修改我们可以还是用原来的PUT的命令,根据id来修改

可以看到version为2证明已经是修改过的了

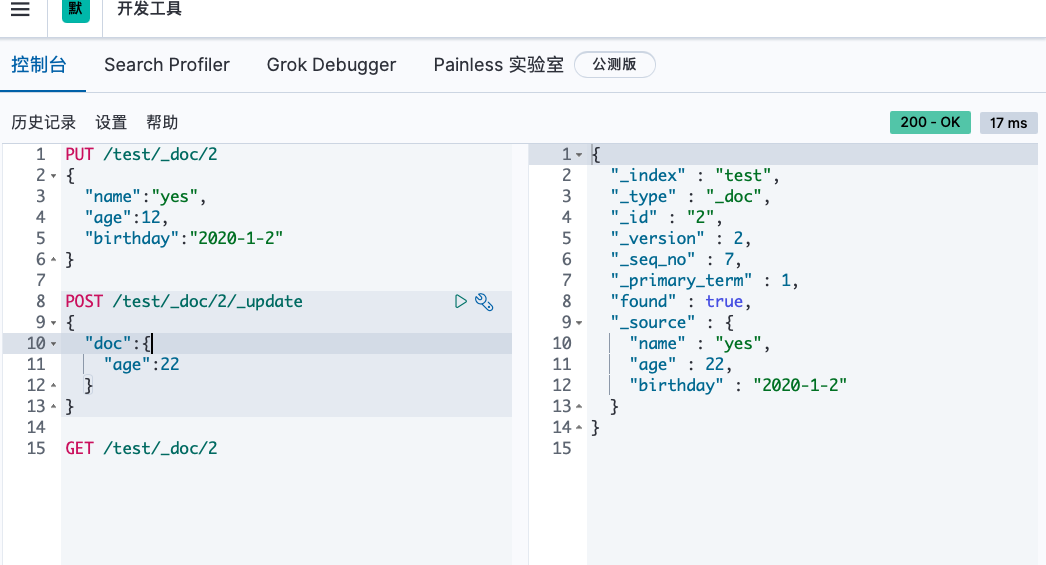

但是如果没有填写的字段 会重置为空了 ,相当于java接口传对象修改,如果只是传id的某些字段,那其他没传的值都为空了。

2.还有一种update方法 这种不设置某些值 数据不会丢失

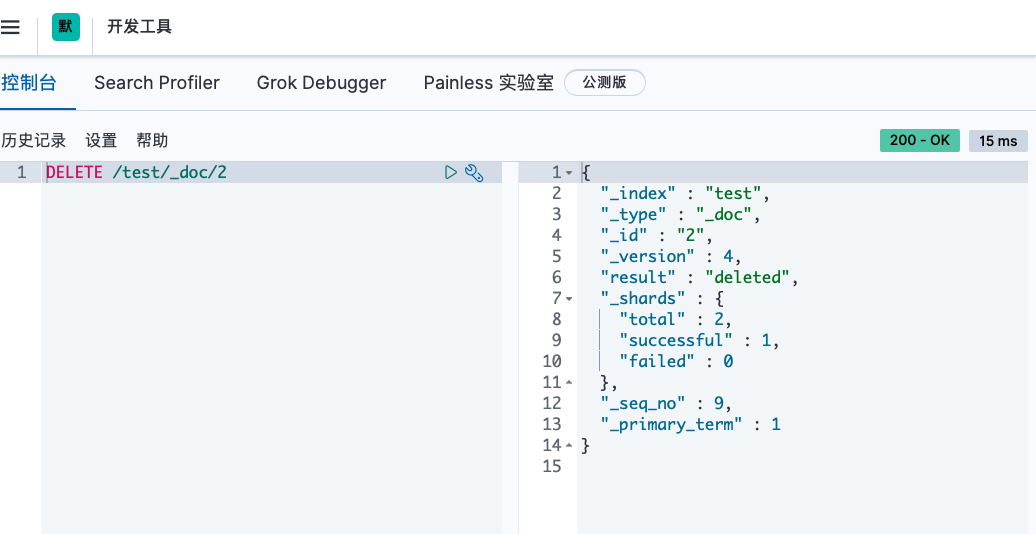

通过DELETE命令实现删除,根据你的请求来判断是删除索引还是删除文档记录。

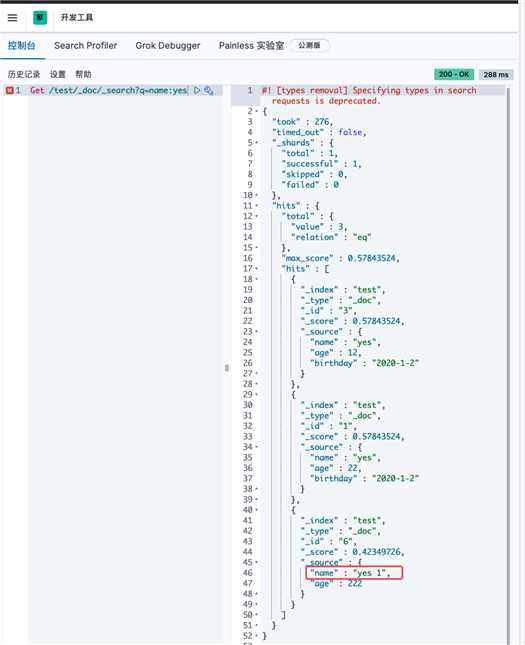

最简单的搜索是GET

搜索功能search

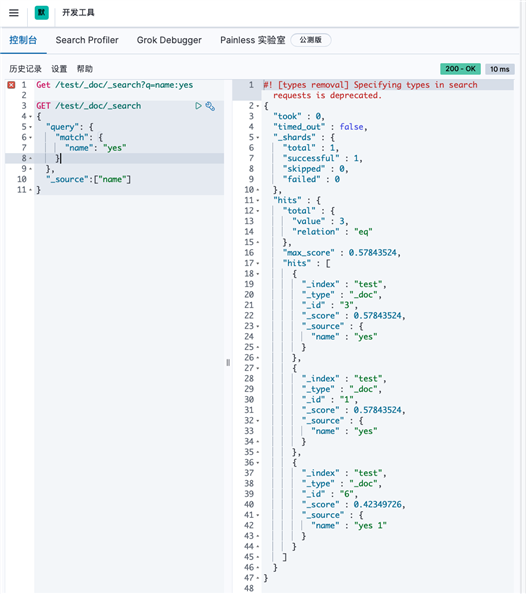

Get /test/_doc/_search?q=name:yes

这边name是text 所以做了分词的查询 如果是keyword就不会分词搜索了

Get /test/_doc/_search?q=name:yesGET /test/_doc/_search{ "query": { "match": { "name": "yes" } }, "_source":["name"]}

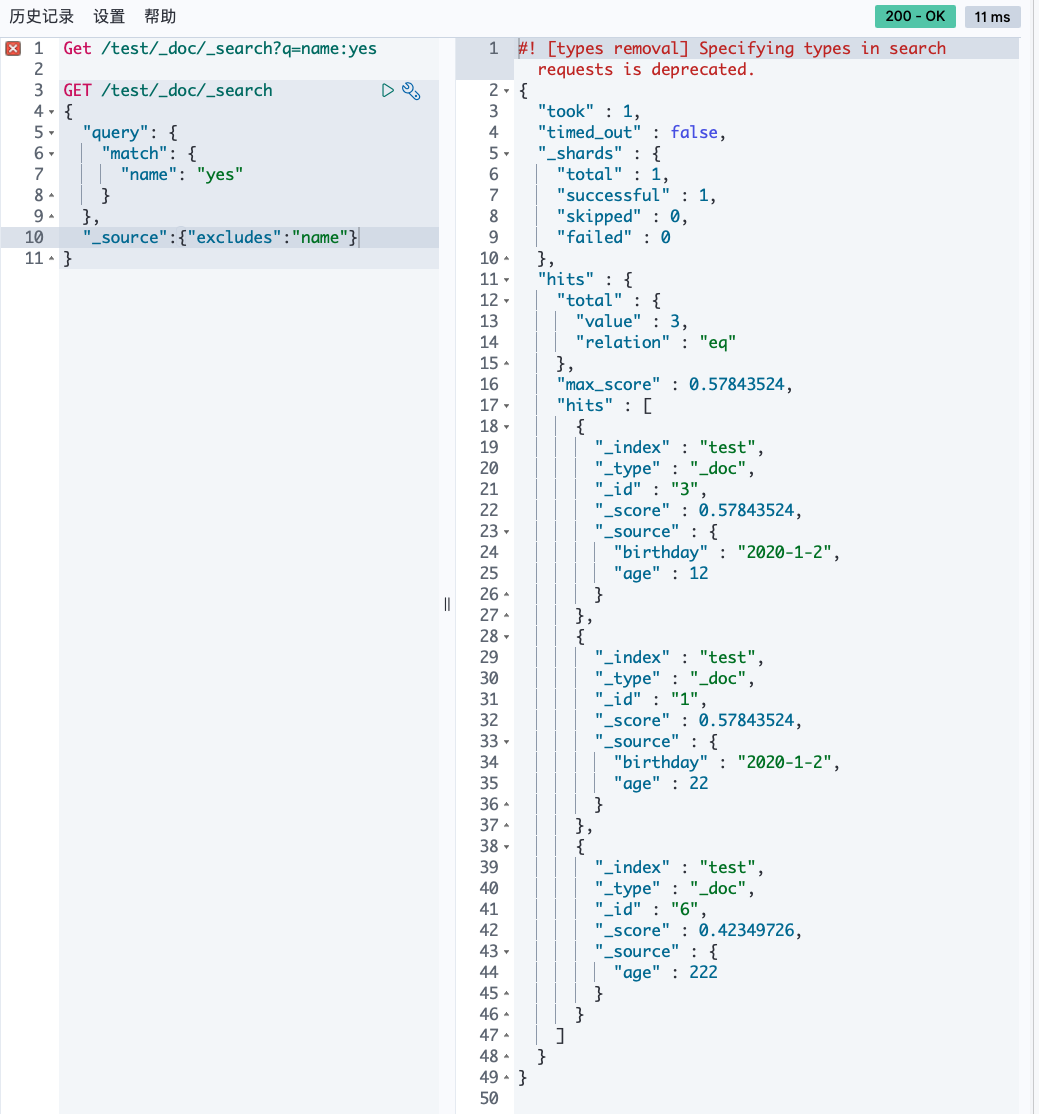

结果过滤,就是只展示列表中某些字段

不包含

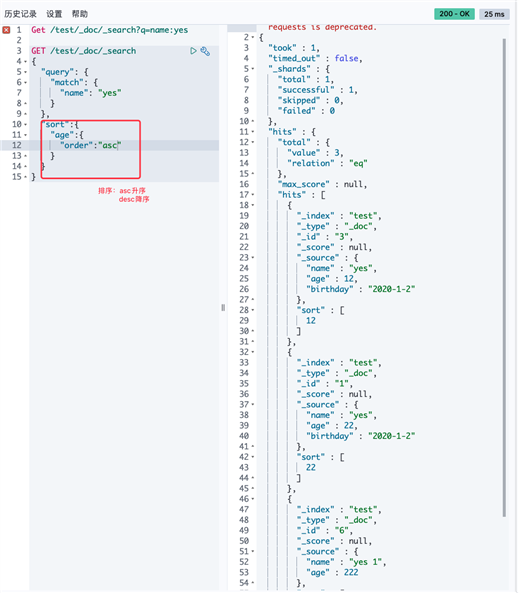

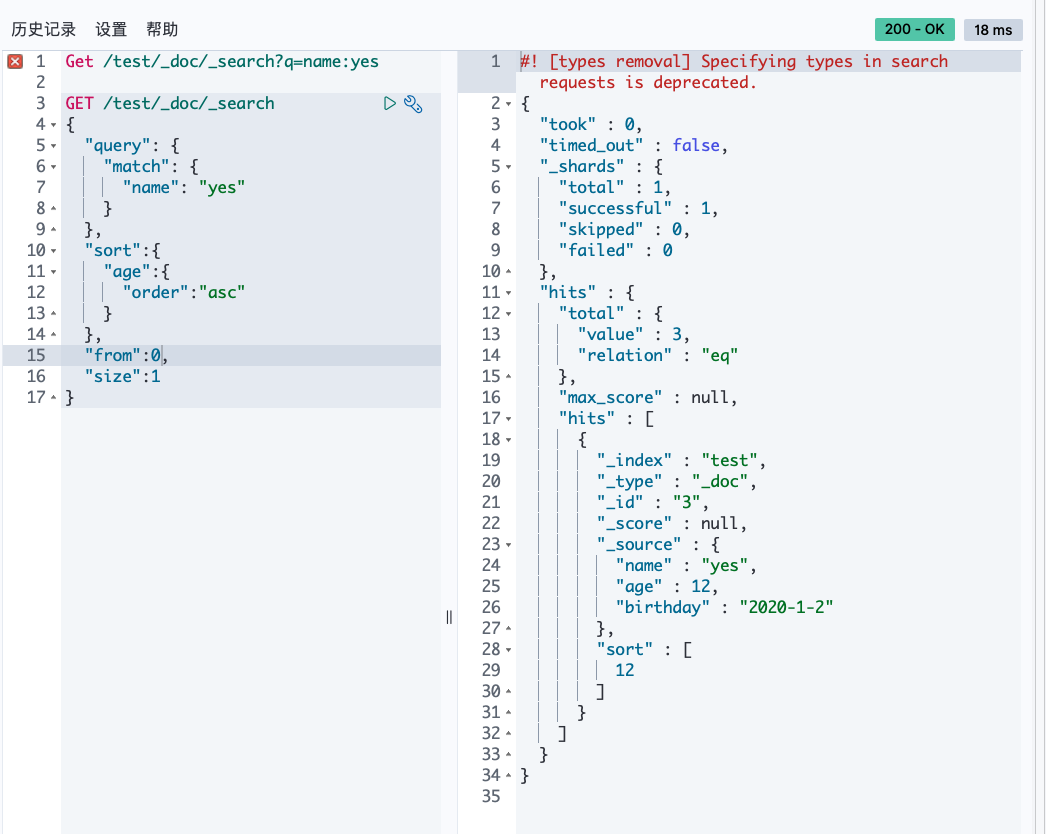

排序

分页

多条件查询

布尔值查询

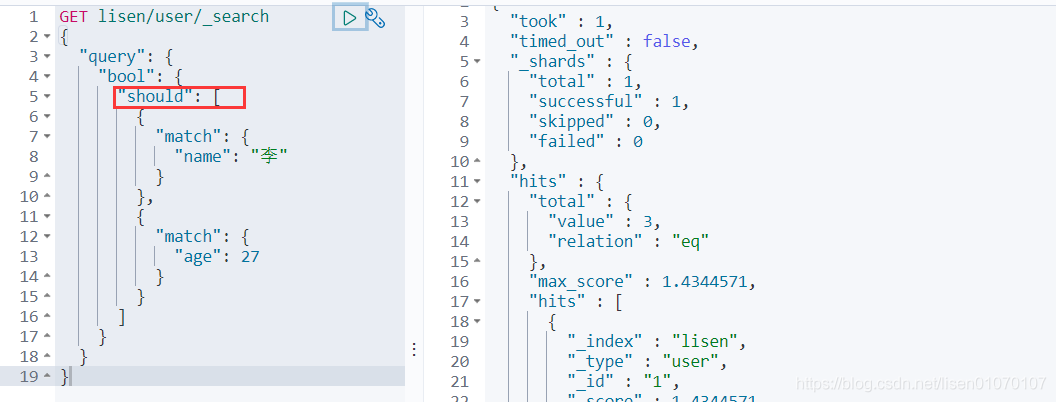

must(and),所有的条件都要符合

should(or)或者的 跟数据库一样

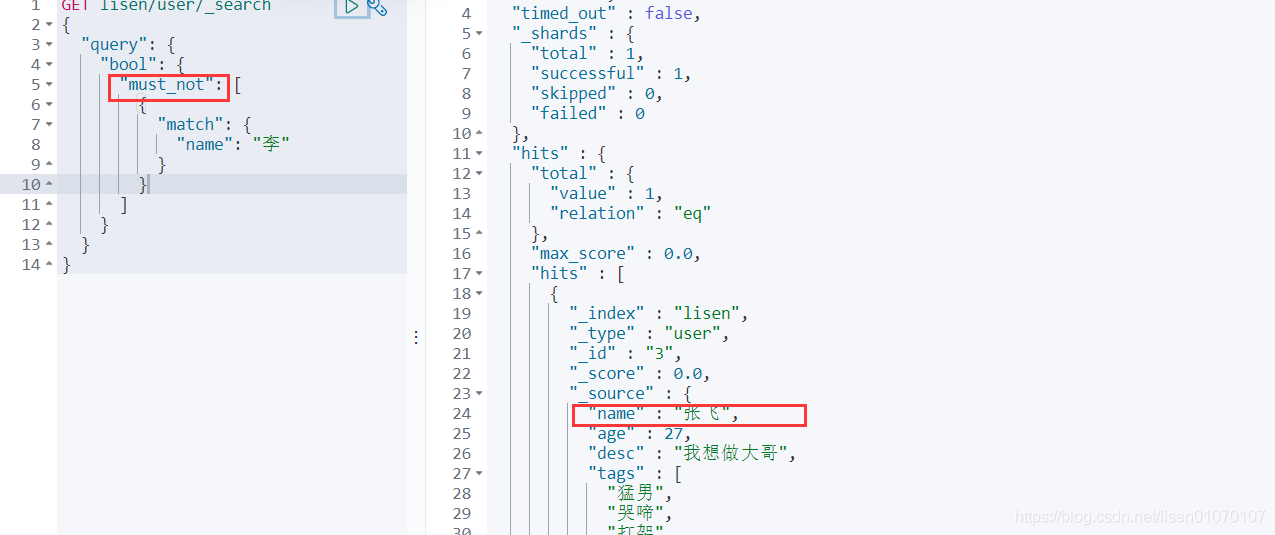

must_not(not)

条件区间

gt大于

gte大于等于

lte小于

lte小于等于

匹配多个条件(数组)

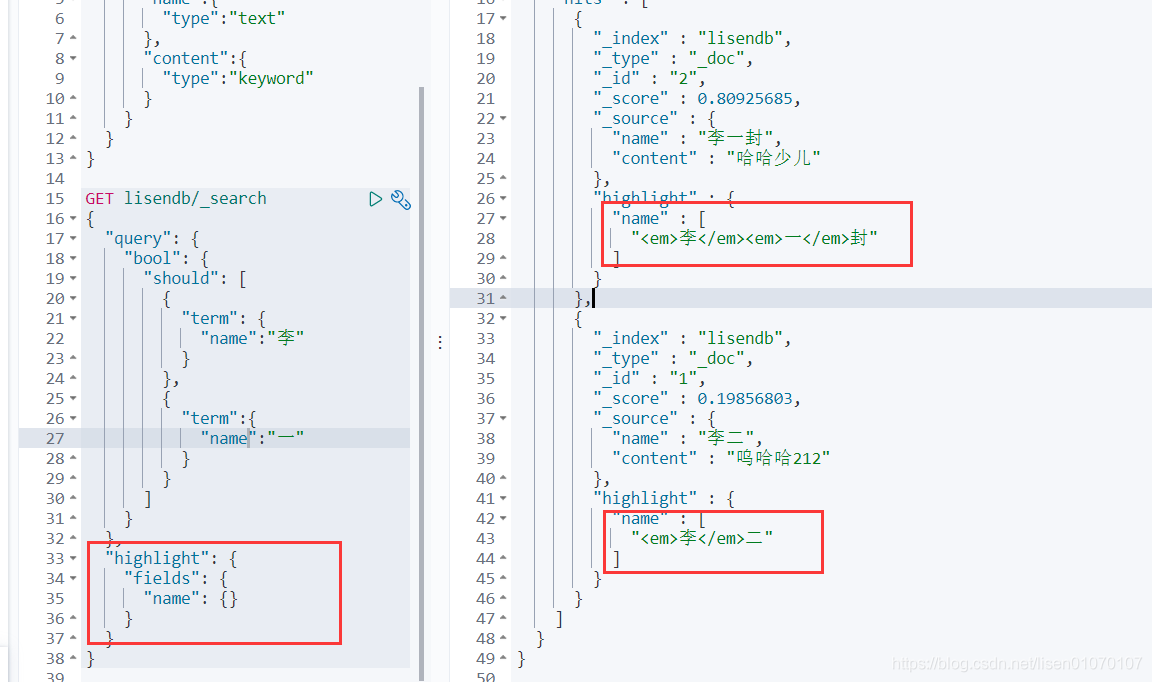

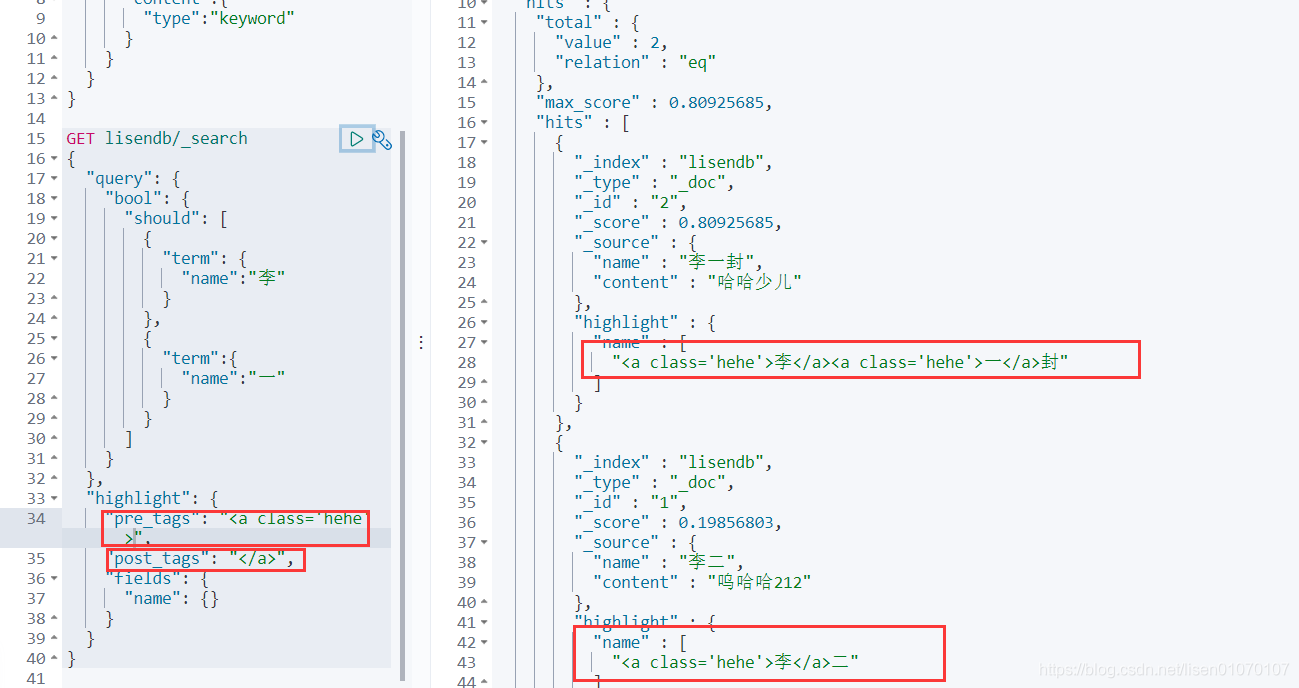

还能自定义高亮的样式

原文:https://www.cnblogs.com/xine/p/14716400.html