来源:https://blog.csdn.net/huahuaxiaoshao/article/details/86183738

分类与回归树(classification and regression tree,CART)模型由Breiman等人在1984年提出,是应用广泛的决策树学习方法。CART同样由特征选择而、树的生成及剪枝组成,既可以用于分类也可以用于回归。

CART假设决策树是二叉树,内部结点特征的取值为“是”和“否”,左分支是取值为“是”的分支,右分支是取值为“否”的分支。这样的决策树等价于递归地二分每个特征,将输入空间即特征空间划分为有限个单元,并在这些单元上确定预测的概率分布,也就是在输入给定的条件下输出的条件概率分布。

CART算法由以下两步组成:

(1)决策树的生成:基于训练数据集生成决策树,生成的决策树要尽量大(大是为了更好地泛化);

(2)决策树剪枝:用验证数据集对已生成的树进行剪枝并选择最优子树,这时损失函数最小作为剪枝的标准。

3.1回归树的生成

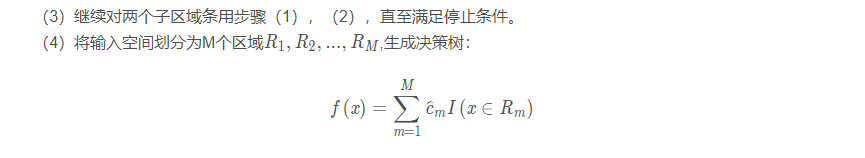

在训练数据集所在的输入空间中,递归地将每个区域划分为两个子区域并决定每个子区域上的输出值,构建二叉决策树。

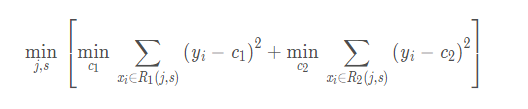

(1)选择最优切分变量j与切分点s,求解

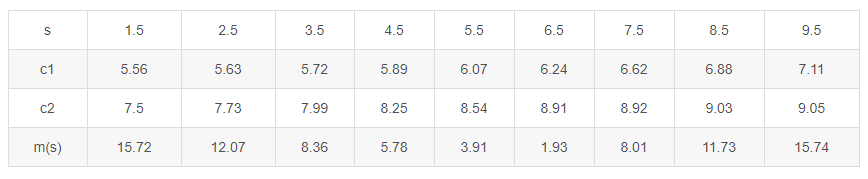

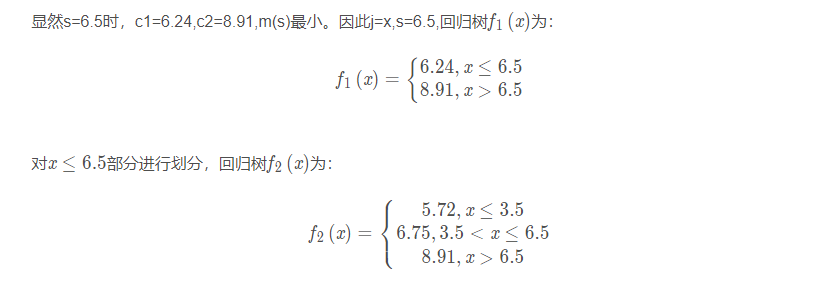

遍历变量j,对固定的切分变量j扫描切分点s,选择使上式达到最小值的对(j,s)j。

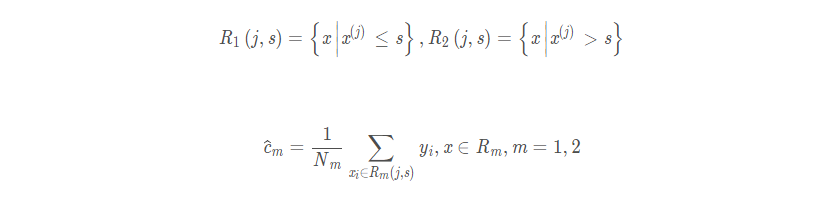

(2)用选定的对(j,s)划分区域并决定响应的输出值:

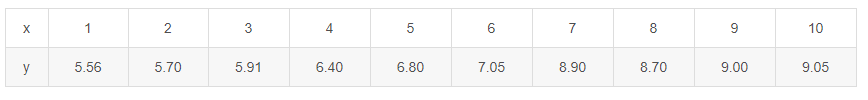

3.2回归树生成的例子

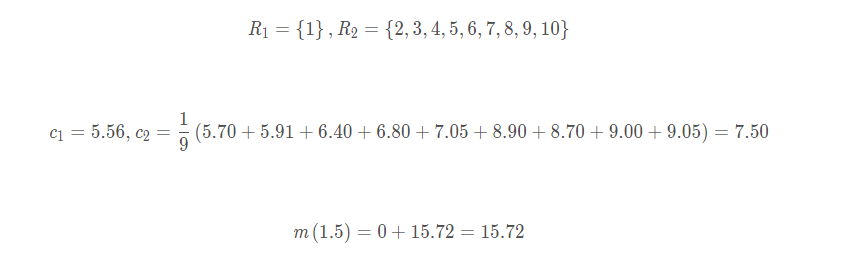

当s=1.5时

回归树使用最大均方差划分节点;每个节点样本的均值作为测试样本的回归预测值。

数据挖掘实践(48):决策树计算过程实例(二)CART回归树及其实战

原文:https://www.cnblogs.com/qiu-hua/p/14851247.html