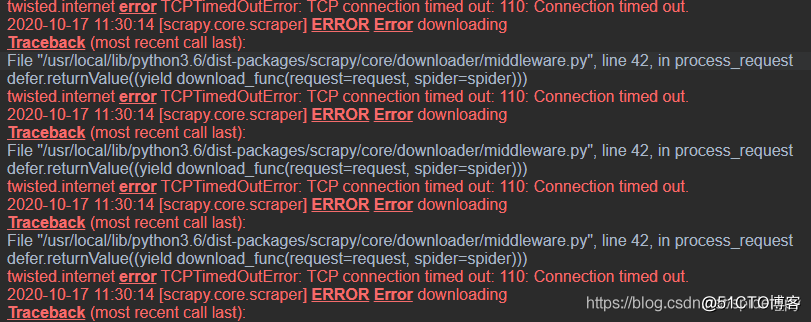

在使用 scapy 进行大批量爬取的时候,少数请求链接会出现请求超时,当出现请求超时时,爬虫会自动重试三次。

扩展,可以 通过 设置 RETRY_ENABLED = False 来关闭重试机制

若超过 180s 且三次后且还是没有得到数据,就会出现 twisted.internet.error.TimeoutError 错误。

提供几种解决办法:

1、降低同时请求的数量

CONCURRENT_REQUESTS = 5

2、 增加超时时间

DOWNLOAD_TIMEOUT = 2000

3、 增加重试次数

RETRY_TIMES = 5

4、下载中间件中,捕获这个报错,并返回request,让它重新请求这个对象:

from twisted.internet.error import TimeoutError

def process_exception(self, request, exception, spider):

if isinstance(exception, TimeoutError):

return request

?

scrapy 出现 [twisted.internet.error.TimeoutError:] 的几种解决方案

原文:https://blog.51cto.com/u_15018246/2908206